@Kokojin

Was den Stromverbrauch angeht, so ist dieser geringer als bei manch anderen Karten, wenn man den Verbrauch mit der resultierenden Leistung vergleicht.

Oblivion ist schlecht programmiert.

Und nur zur Info, bei der 8800GTX läuft Oblivion mit hohen Einstellungen doppelt so schnell wie auf einer X1950XTX oder GX2.

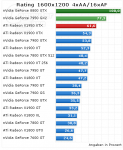

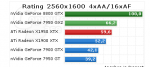

Also macht das 100% Leistungszuwachs. Aber dies kommt dennoch nicht so ganz hin, da dieses Game so bes**issen programmiert ist. Es gibt aber auch Tests wo Oblivion wirklich gut läuft (1600x1200 4xAA 16xAF auf der 8800GTX mit 54fps), dies könnte auch an den Treibern oder an der schnelleren CPU liegen.

Oder guck dir mal Company of Hereos an, da ist eine 8800GTX 3mal so schnell wie eine 7950GX2 bei hohen Einstellungen und bei noch extremeren Einstellungen zieht die 8800GTX die 7950GX2 sogar mit dem mehr als 5fachen an Geschwindigkeit ab. Das war auch nur ein Beispiel, guck dir mal das Review

hier an, da wirst du in etwa sehen wozu der G80 im Stande ist.

Aber leider gibt es nicht arg viele Spiele, die die Leistung des G80 wirklich zeigen können, da die meisten Engines noch auf die ältere Architektur aufbauen. Dann kommt noch die Leistungsbremse DX9 daher und die Treiber für den G80, die sich ja auch noch so stark im Betastadium dass man denken könnte das sind Alphas und das wird durch eine "langsame" CPU (FX60) auch nicht besser mit der Leistung. Und Vista wird da auch noch die Dualcores besser ausnutzen können, wovon eine schnelle Grafikkarte auch noch profitiert und von 64Bit mal ganz zu schweigen. Fest steht dass der G80 so effizient aufgebaut ist wie schon lange kein Grafikchip mehr. Aber effiziente Hardware muss auch effizient angesprochen werden und das ist bis jetzt noch nicht wirklich der Fall. Deswegen find ich das ja auch so krass, dass der G80 unter solchen Umständen noch richtig abgeht und sogar zwei der bisher stärksten Grafikkarten in die Knie zwingt.

Die 8800GTX ist schon eine bombige Karte und nicht annähernd so schlecht wie du sie darstellst. Man muss da nur etwas über den Tellerrand hinaus schauen, seinen Verstand einsetzen und fast sämtliche Tests zum G80 durchlesen dann weiss man das.

tomi0112 schrieb:

Bin ja mal gespannt was die nächste generation kosten soll, wenn wir die MwSt Erhöhung überstanden haben

Deswegen schlag ich auch noch vor dem 1.1.07 zu.