- Registriert

- Feb. 2007

- Beiträge

- 4.750

NVidia DLSS wird von Nvidia und dem Marketing selbst gerne als das Allheilmittel für die Gamer dargestellt, oder von Entwicklern als Mittel zur “ Performance Verbesserung”.

In vielen Tests wird dann auch oft eine relativ aktuelle CPU genutzt, welche mehr als genug Leistung für alle Lebenslagen bereitstellt.

Im CB-Funk folge #16

Ab 11:50 wurde das Thema ja schon von @Jan und @Vitche angeschnitten, aber es kam nie so wirklich ein Follow Up.

Das Folgt jetzt:

Mithilfe einer 4070 einem etwas betagten i5 10400F auf einem Asrock H510M-ITX/ac mit 32Gb 2666mhz Ram: wird Cyberpunk 2077 in Insgesamt 39 Testdurchläufen, Nativ, mit DLSS ( Quality und Performance) sowie Framegeneration mit dem Max RT Preset und Path Tracing Preset Durchgescheucht.

Im Bios wurde die CPU einmal auf 4 Kerne und 8 Threads begrenzt und einmal komplett von der Leine gelassen als 6 Kerne mit 12 Threads.

Als Auflösung wurde 1920x1080 gewählt.

Bei den Graphen und Ansichten achten wir nur auf die Minimum, 1% percentile und den Durchschnitt. ( Ergebnisse finden sich dann nochmal im Anhang )

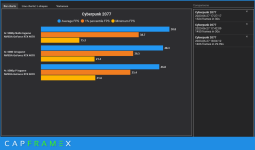

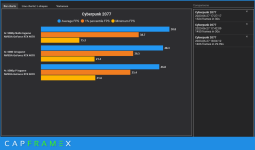

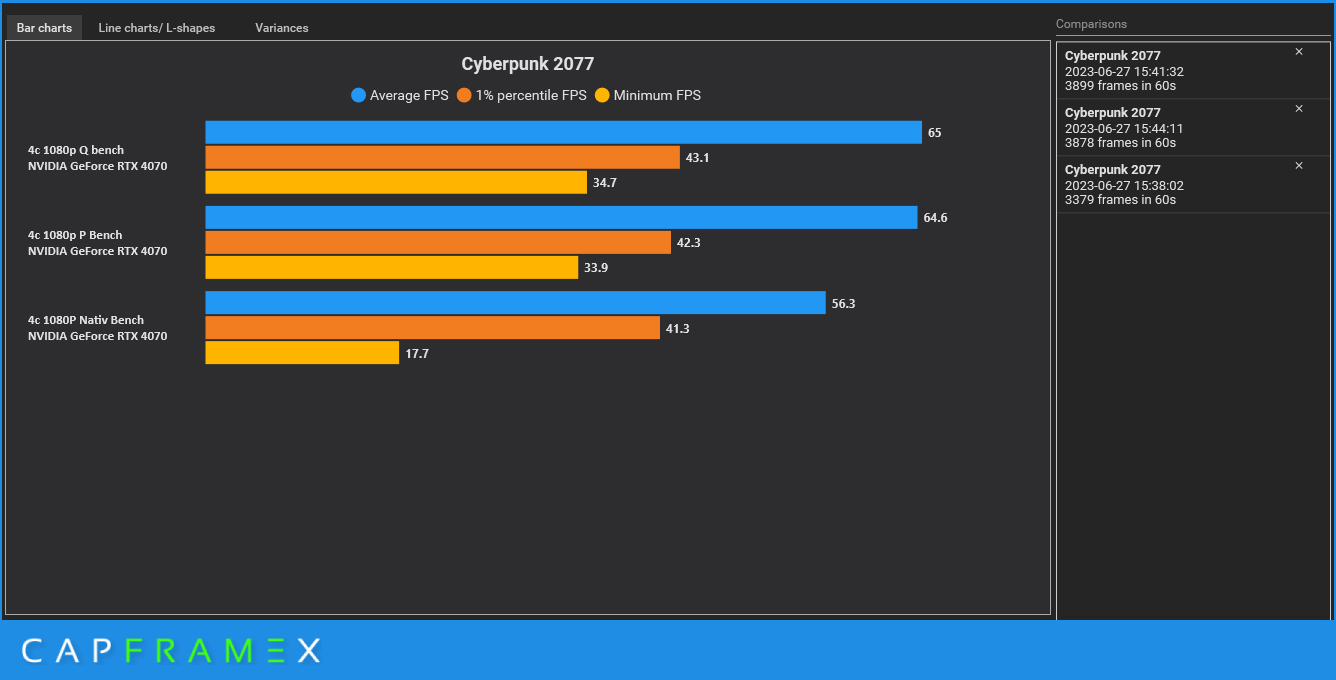

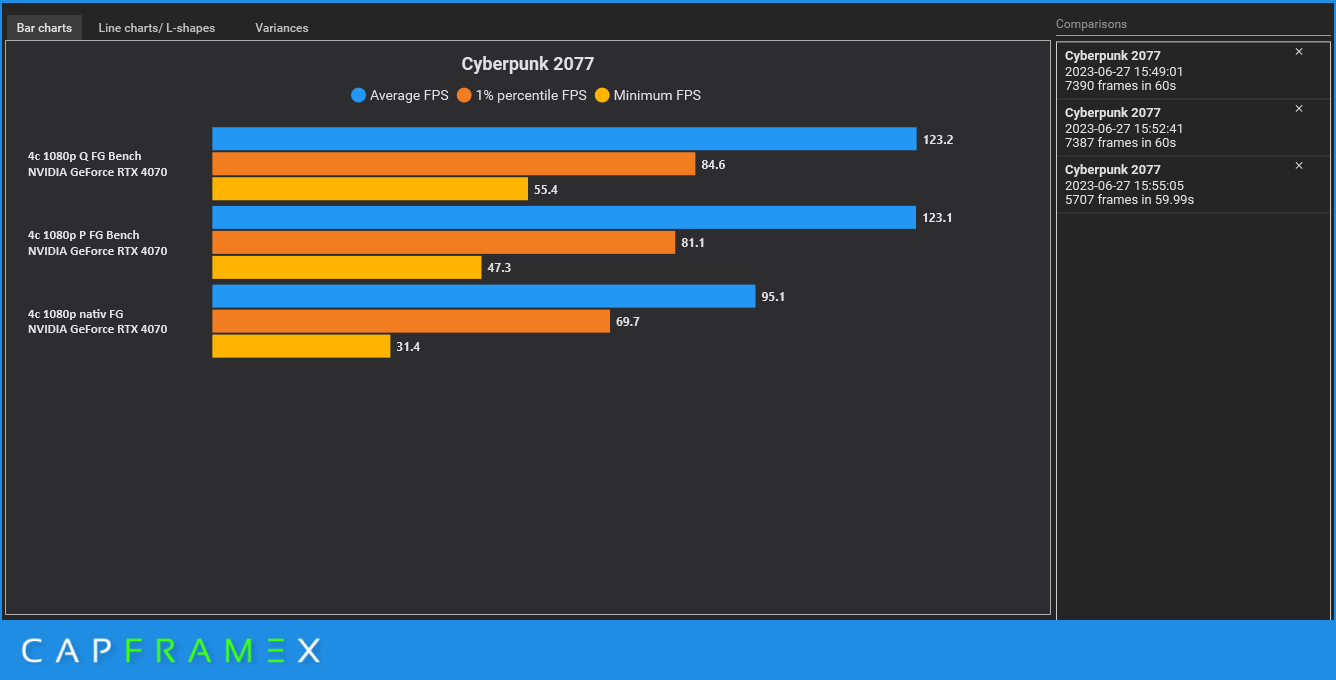

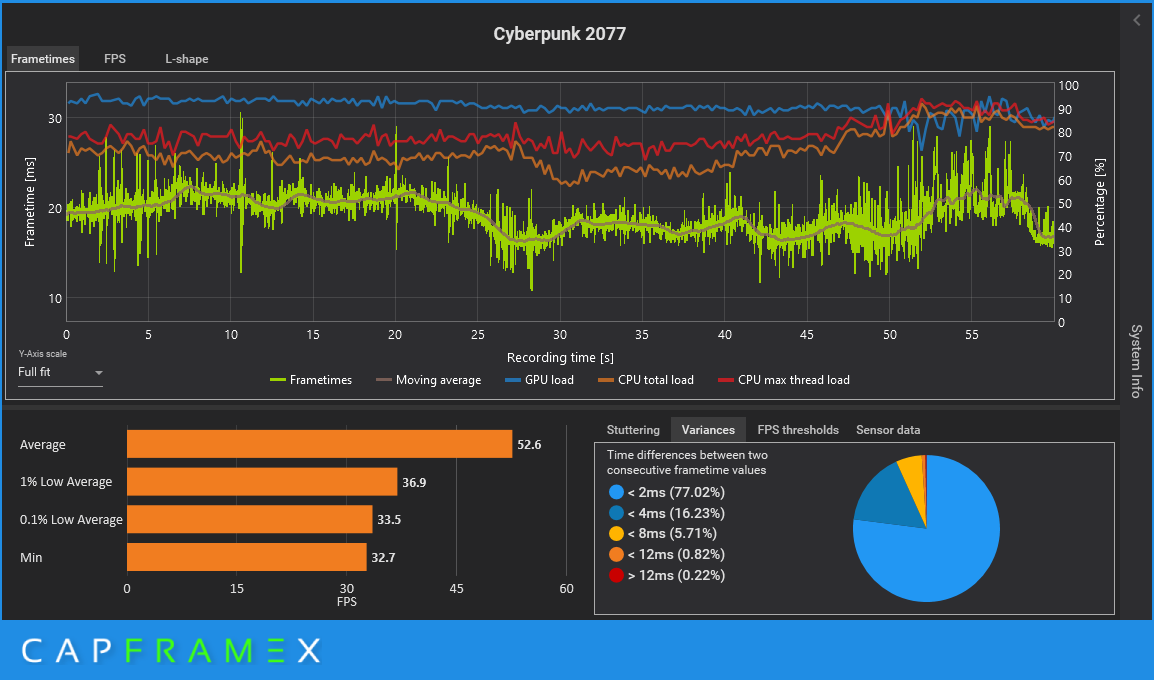

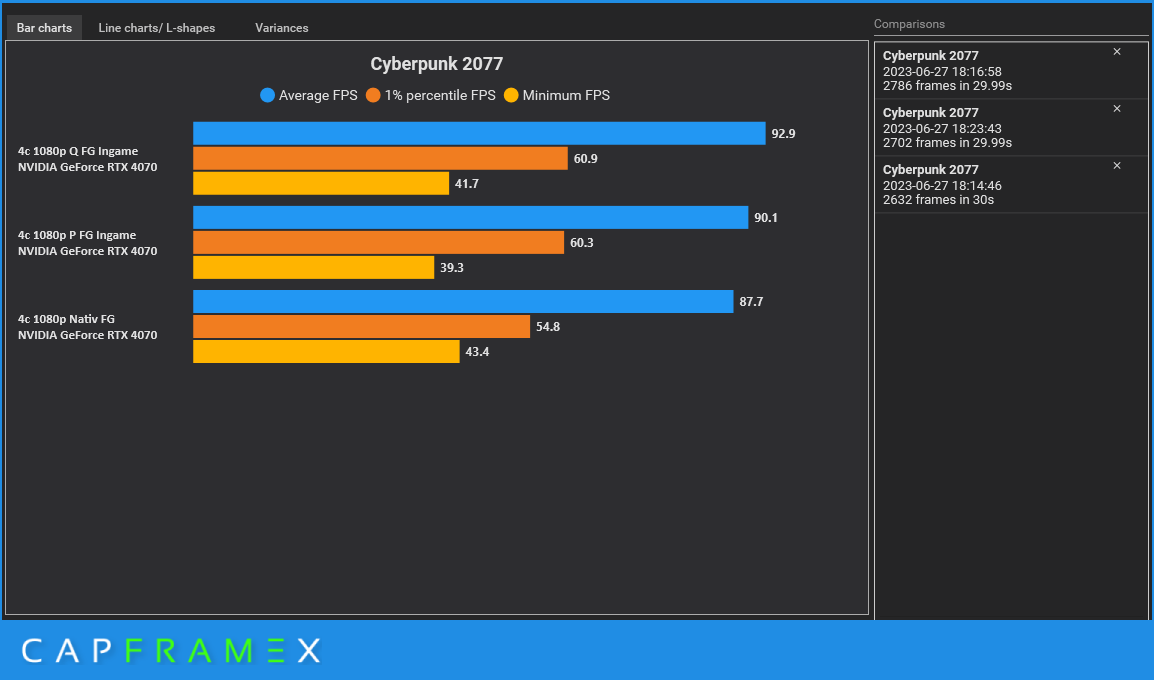

Als Erstes schauen wir uns die Performance mit 4/8 an im integrierten Benchmark an.

Wie zu erwarten Nativ weit abgeschlagen am Ende, aber der Unterschied zwischen DLSS Quality (Q) und Performance (P) ist fast marginal. Woran liegt es ?

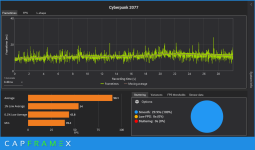

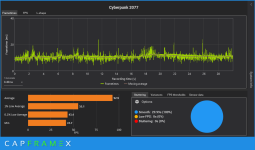

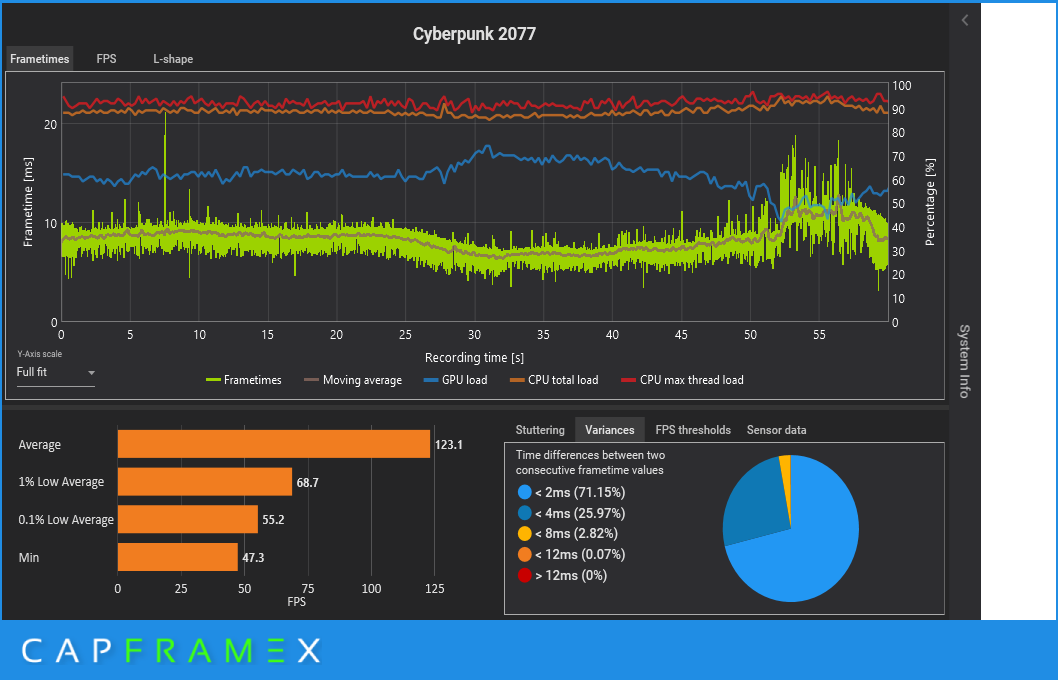

Schauen wir dann auf die einzelnen Ergebnisse und lassen uns dazu die CPU und GPU Auslastung anzeigen wird das Bild klarer:

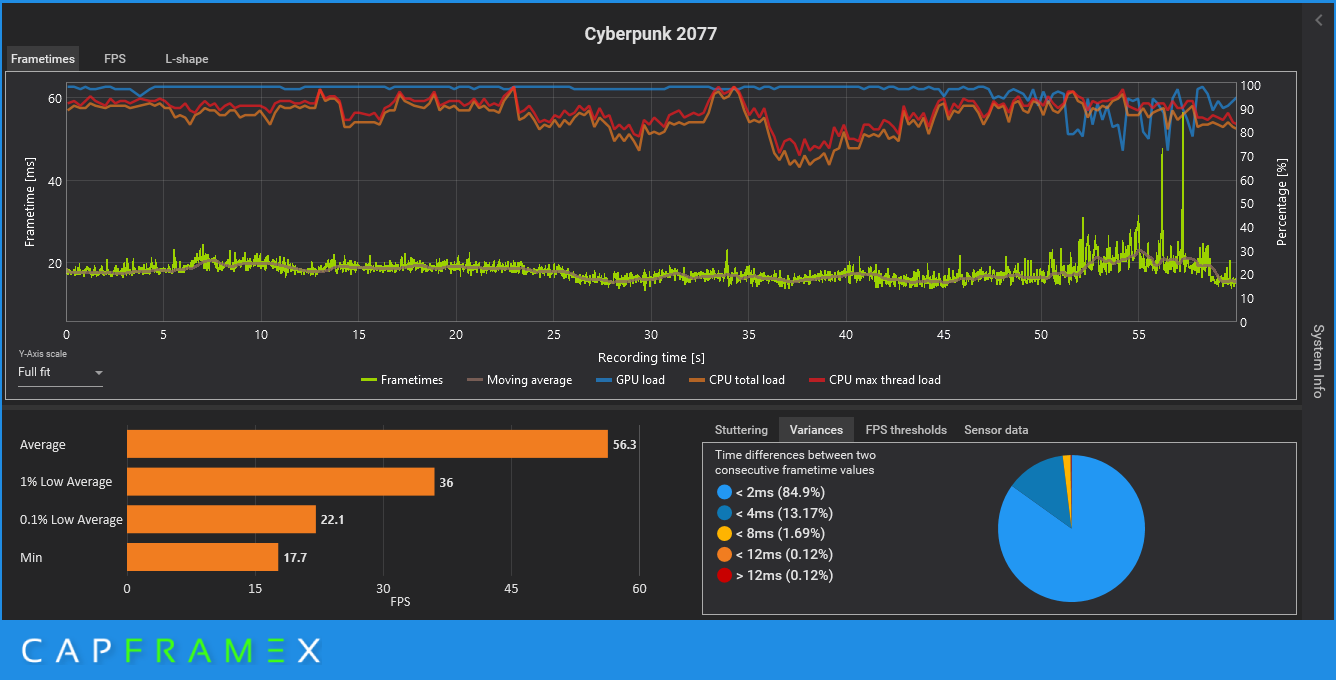

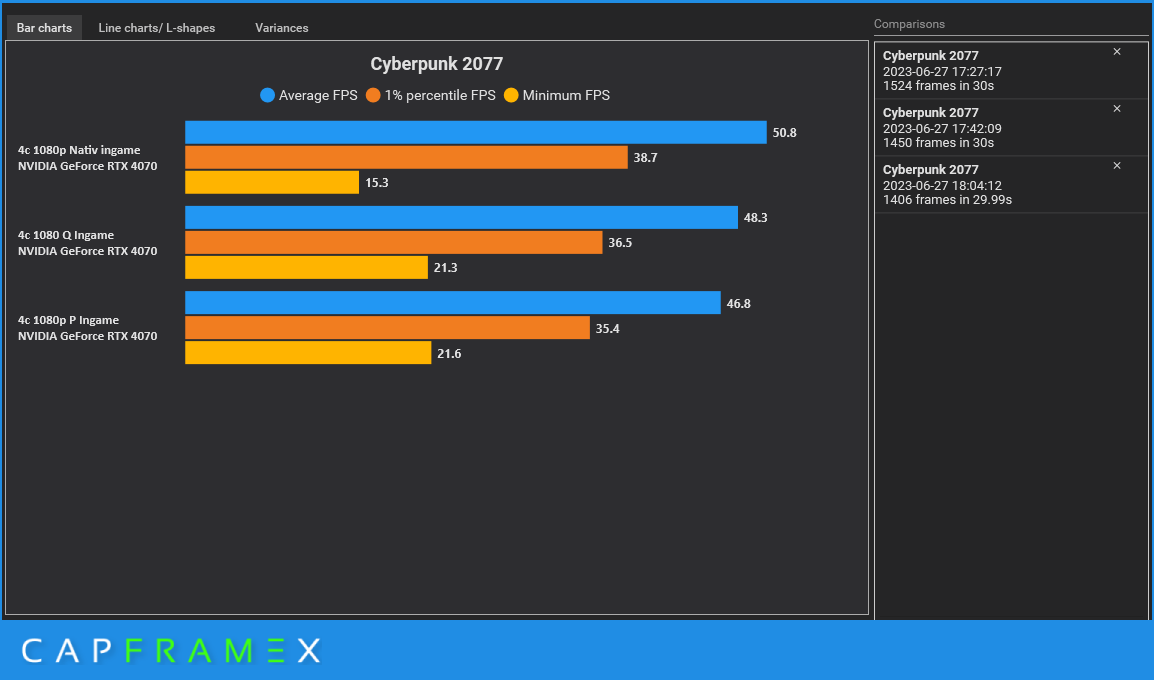

Nativ (Ohne DLSS)

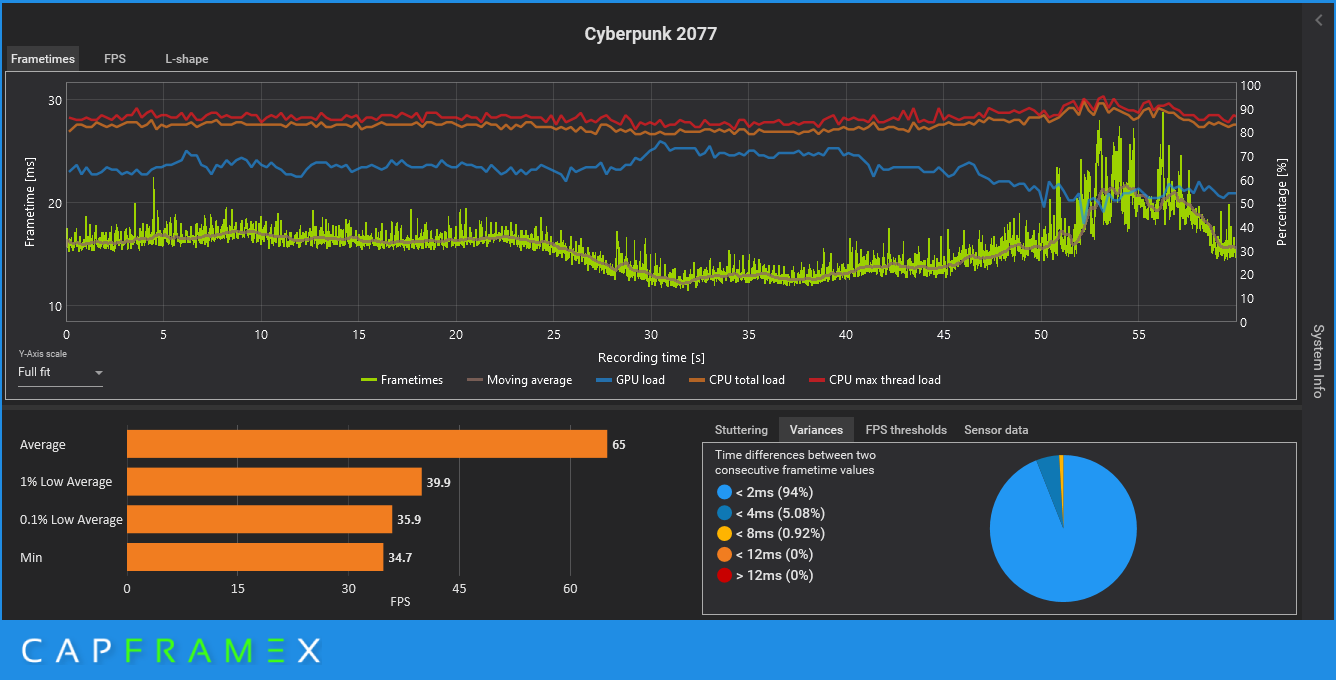

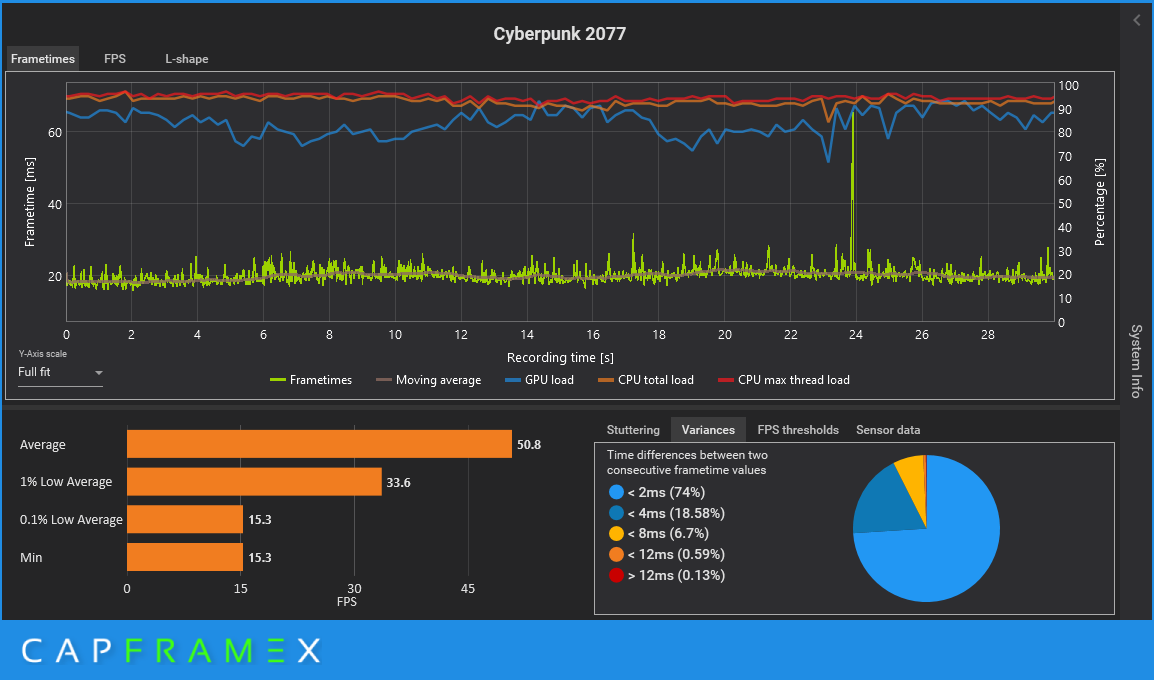

Quality

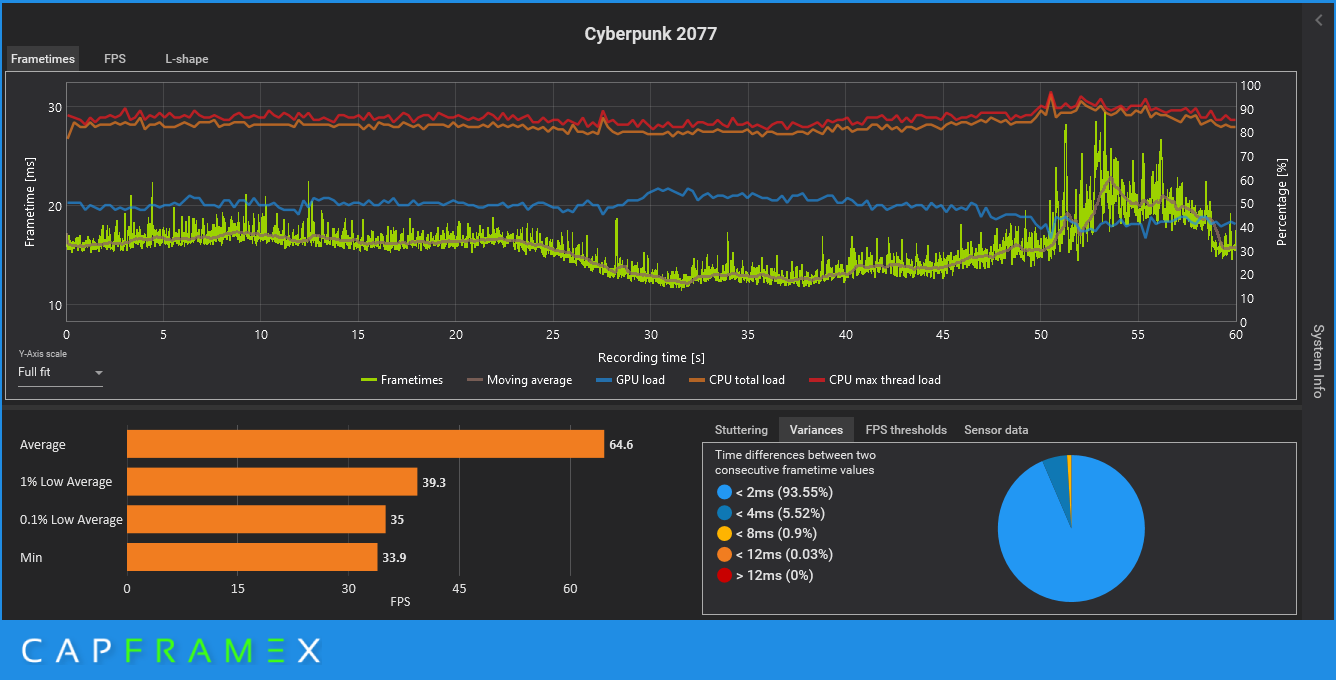

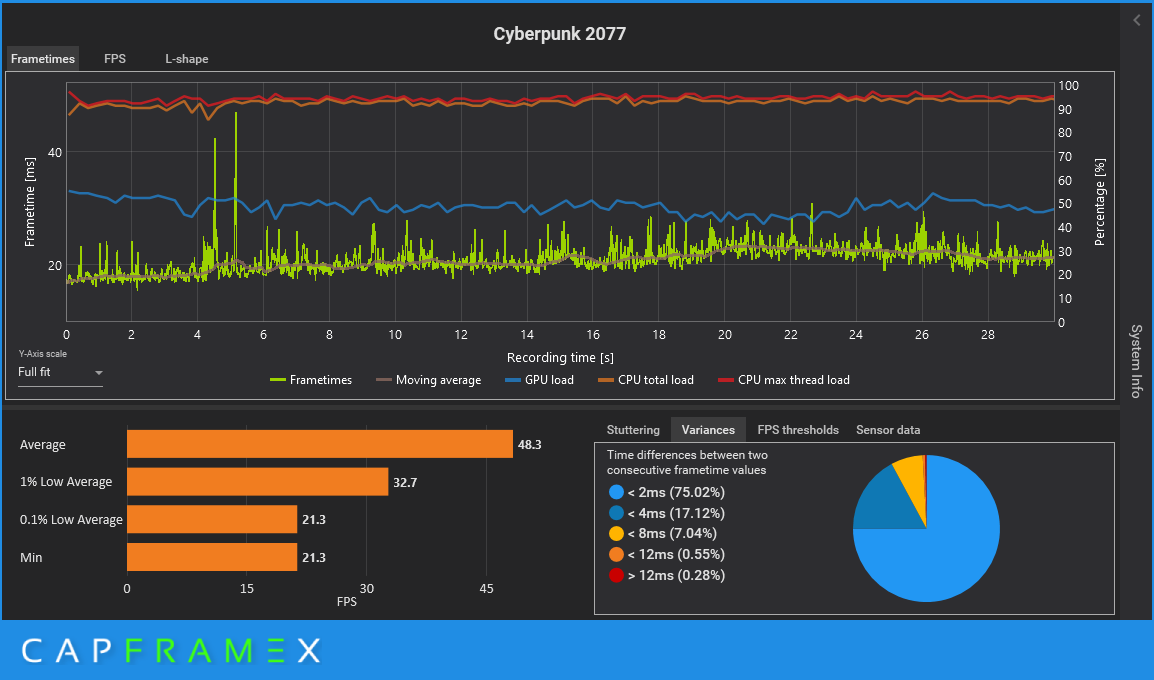

Performance

Unsere 4 Kerne mit 8 Threads sind trotz einem Takt von 4,1 GHz zu langsam! DLSS schafft es nicht, die Performance zu verbessern, weil die CPU einfach nicht hinterher kommt. DIe Auslastung der GPU sinkt immer weiter und Pendelt sich zuletzt bei Performance bei Ca 50% ein.

Aber es gibt ja noch Frame Generation.. Ja, es sieht besser aus, aber Quality ist besser als Performance

Wir hängen einfach zu sehr im CPU-Limit, als das da noch was geht…

Performance

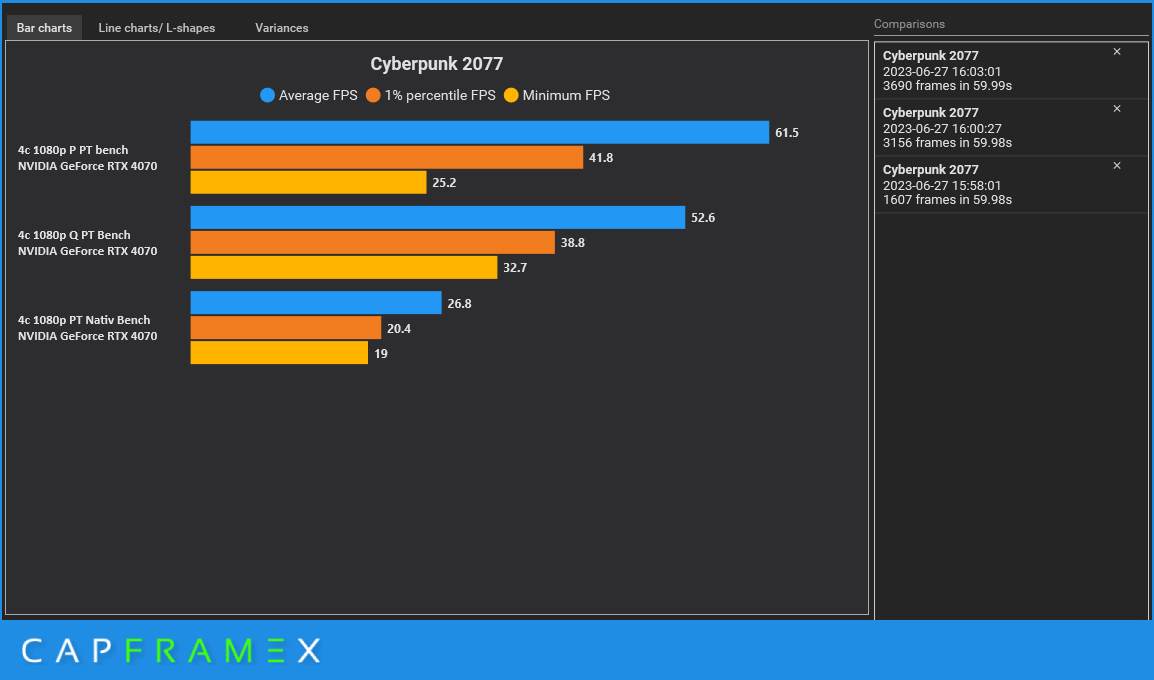

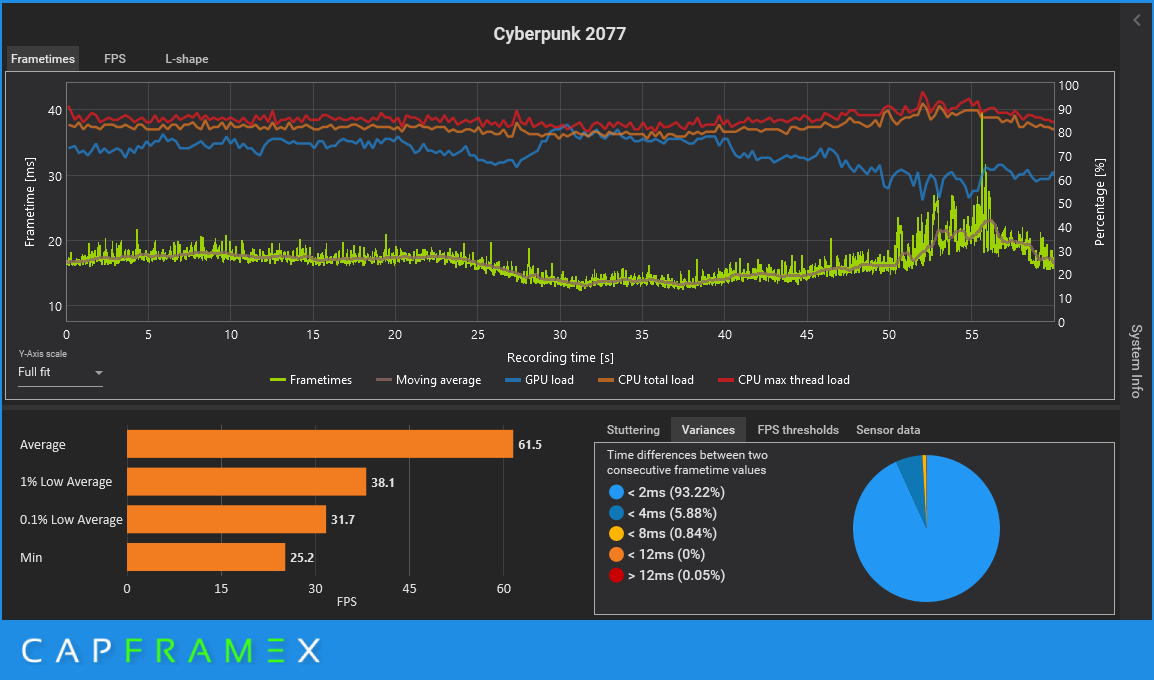

Mit Path Tracing wird es besser aber wir sehen trotzdem einen massiven Einbruch der GPU-Auslastung mit DLSS Performance

Performance / Quality

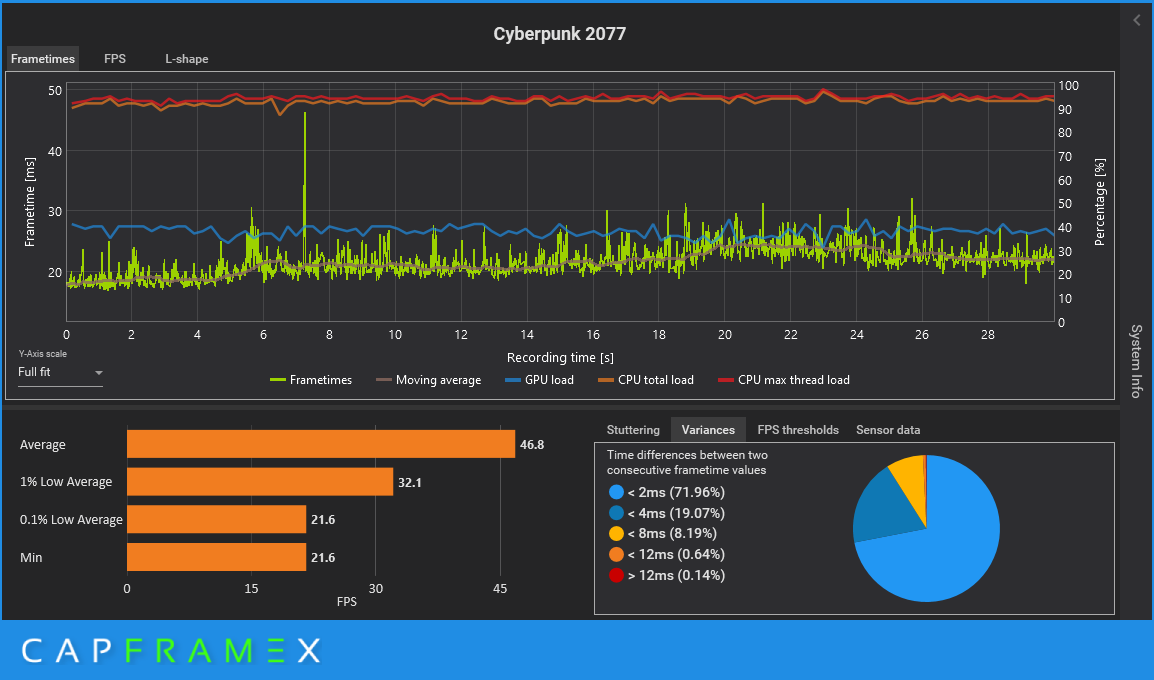

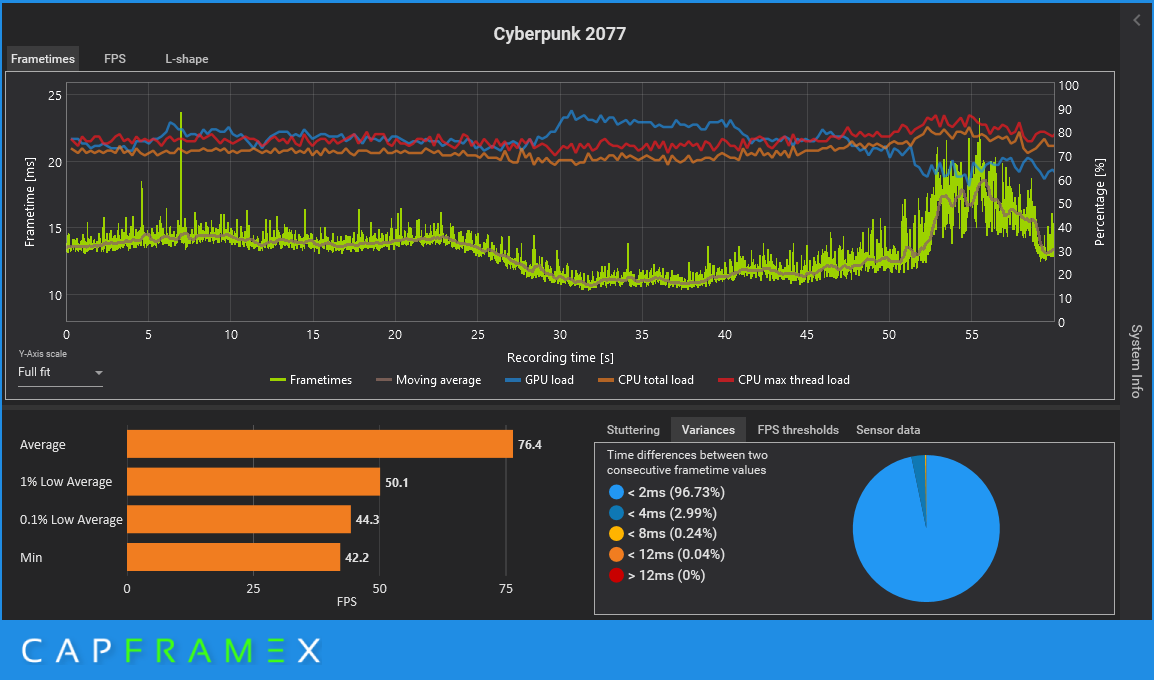

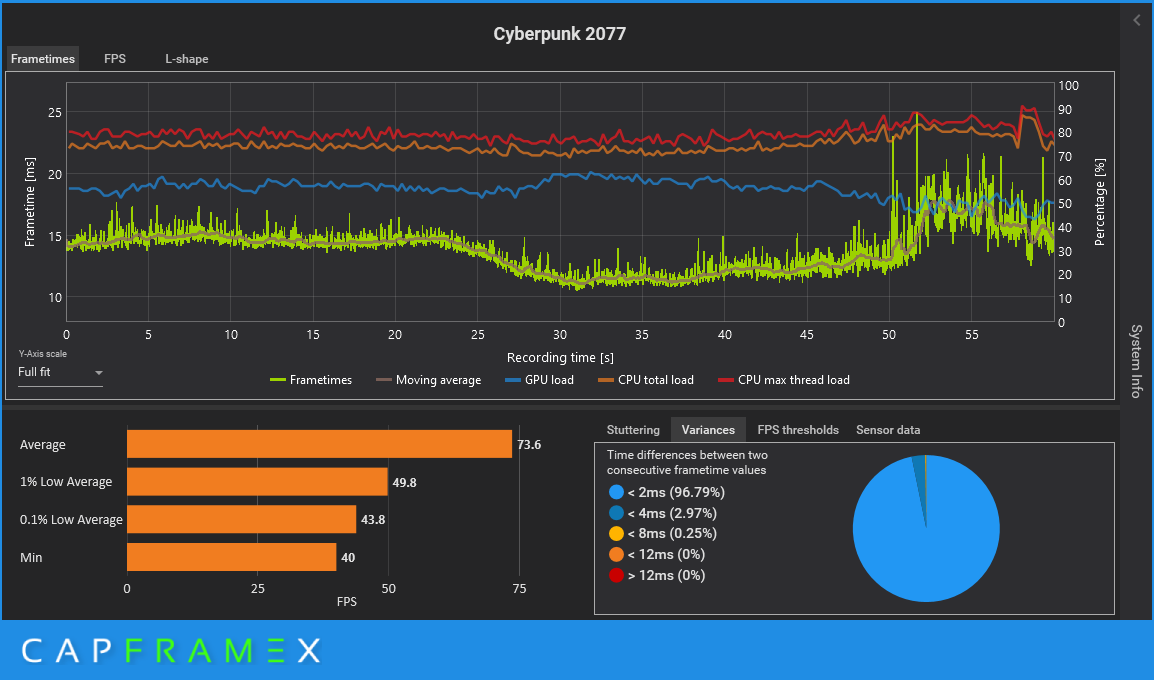

Den Aufmerksamen ist aber sicher schon aufgefallen, wie im letzten Drittel beim Aussenbereich vom Benchmark die CPU Last steigt. Die Darstellung von bewegten NPCs kostet CPU Leistung, also wie verhält sich das jetzt nun ingame? Einmal ein Savegame geladen und ein kurzer 30 Sekunden Rundgang um Corpo Plaza..

Was soll man da sagen:

Hartes CPU-Limit Quality und Performance nehmen sich fast nichts. Die minimalen FPS sind nur gegenüber Nativ Besser.

Die GPU-Auslastung fällt ins bodenlose. Mit DLSS-Performance liegt die Auslastung bei ca 40%, Selbst Ohne DLSS reichen 4 Kerne und 8 Threads einfach nicht aus.

Und Frame Generation? Besser aber Performance hat es nicht so mit der Performance … ( und ja ich hab das 3 mal getestet… )

Die GPU-Auslastung steigt um ca 10% mehr aber auch nicht.

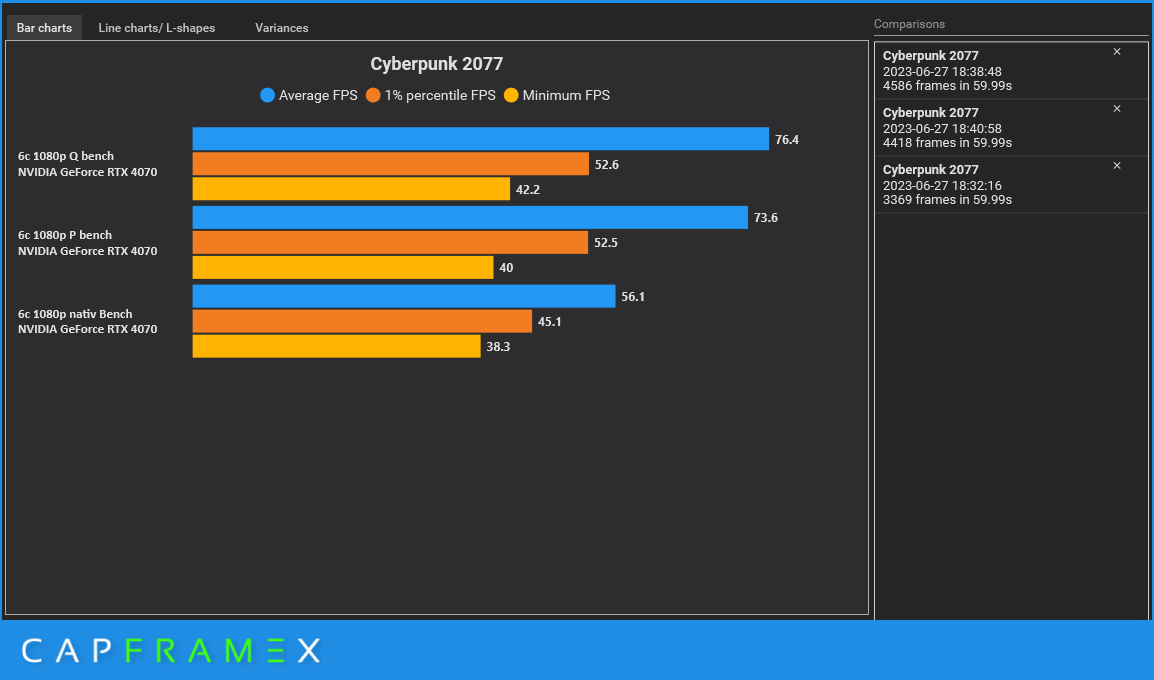

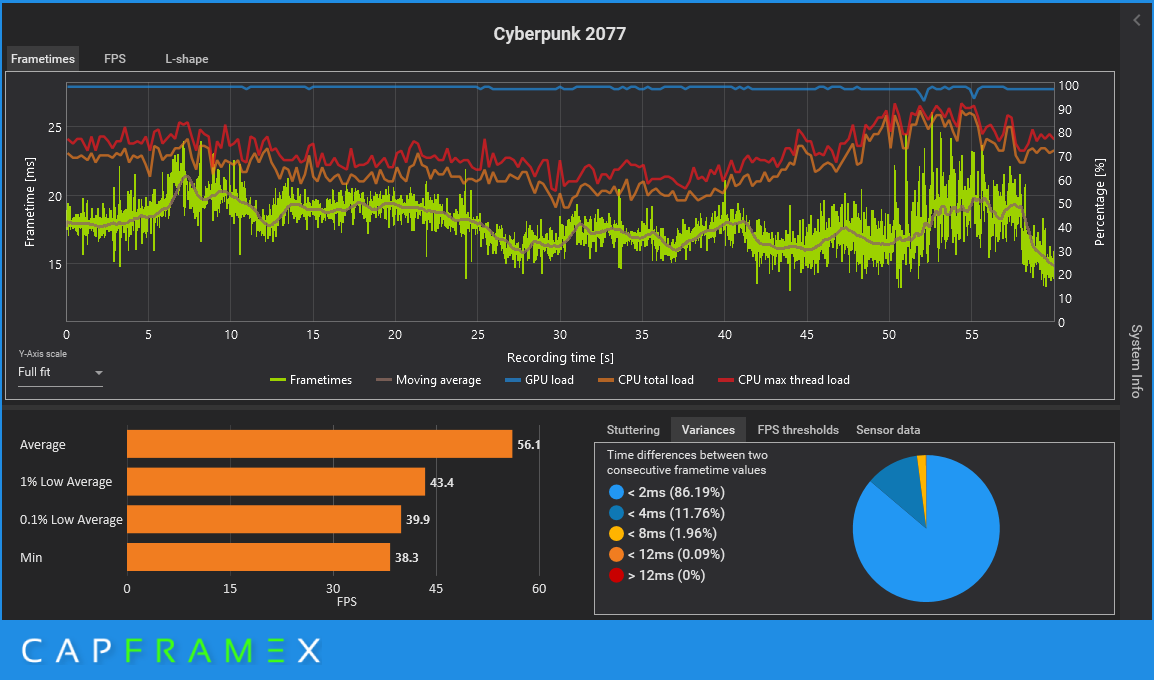

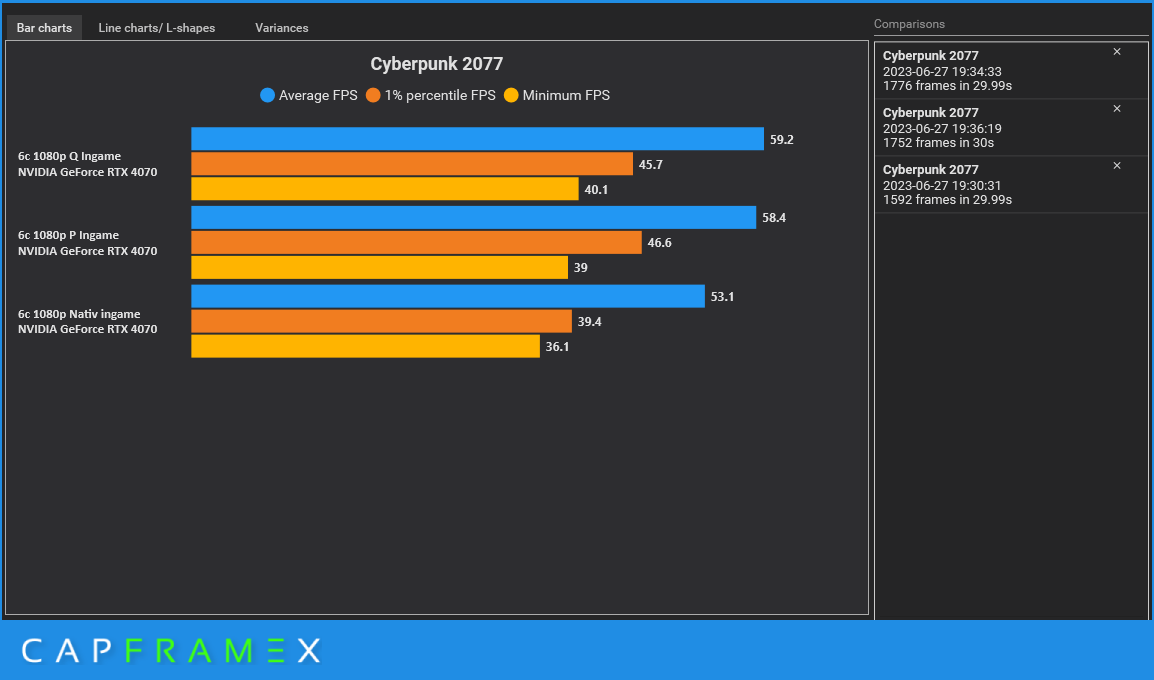

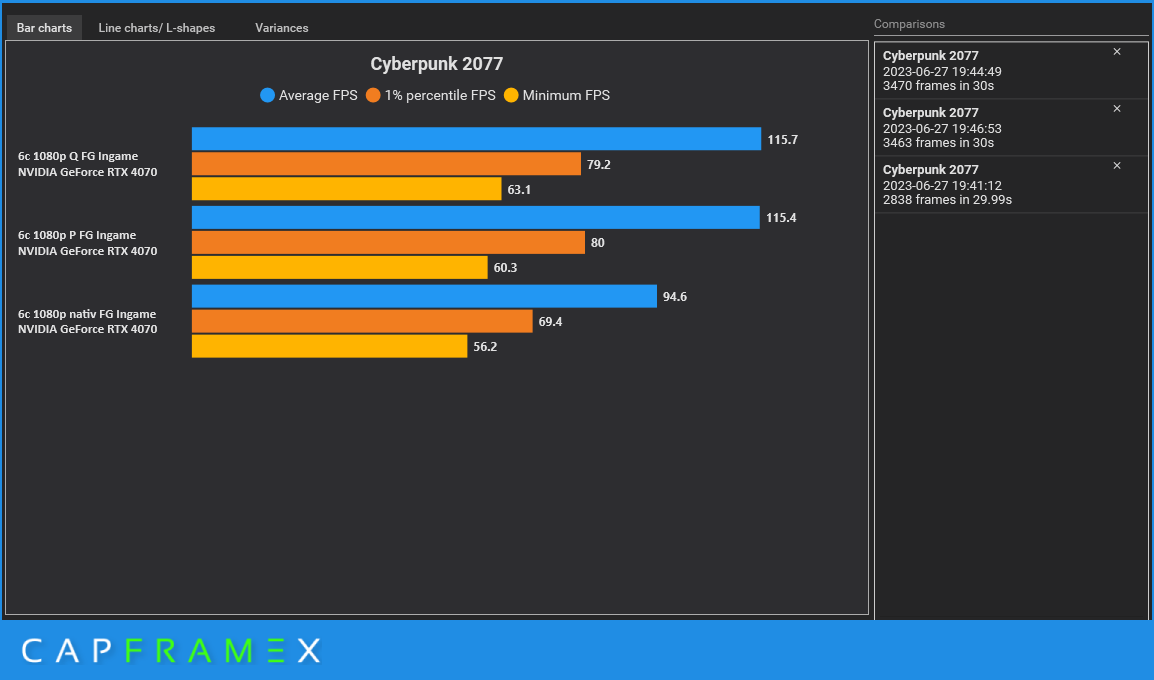

4 Kerne sind dann wohl doch etwas wenig, wie sieht es mit 6 Kernen aus? Die CPU ist ja nicht so alt sollte doch reichen, oder?

Ehm: Nein, Gleiches Bild wie bei 4 Kernen, mit DLSS, schlägt das CPU-Limit wieder voll zu.

Nativ / Quality / Performance

Vor allem Ingame macht es sich wieder stark bemerkbar, wo Quality ähnlich wie Performance abliefert, das "Wundermittel" Framegeneration lässt die Zahlen auch nur größer werden aber ändert nichts am CPU Limit.

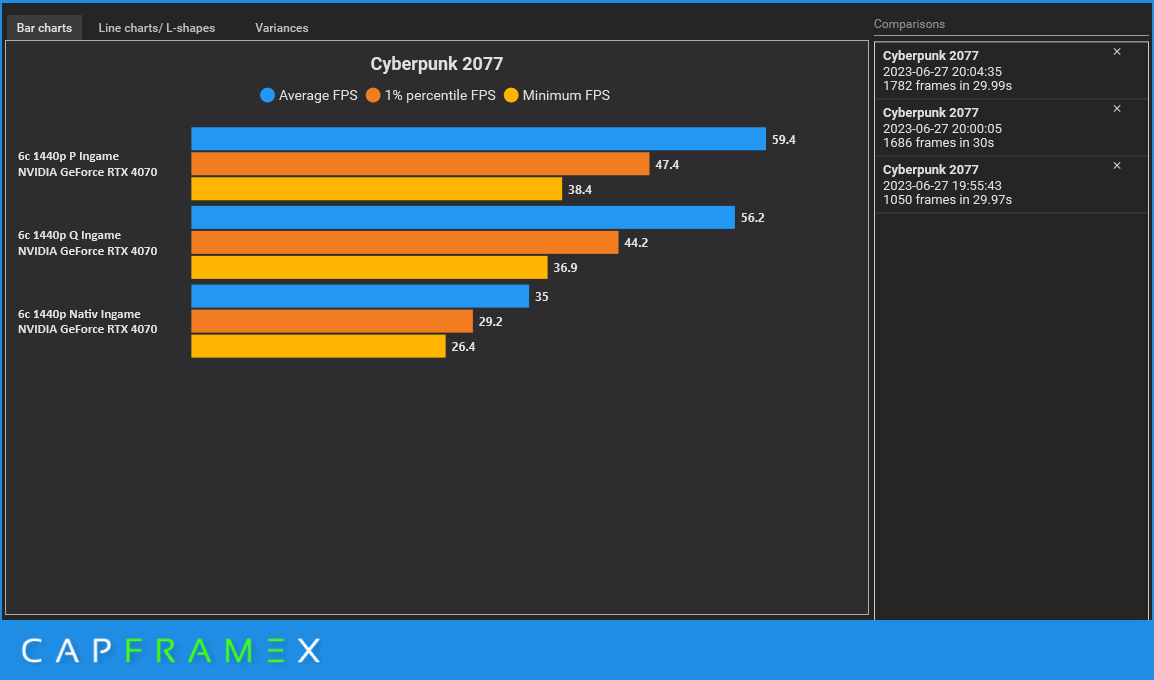

und selbst wenn wir Ingame die Auflösung auf 2560 x 1440 erhöhen, ändert es so gut wie nichts am CPU-Limit aber Performance Liefert diesmal die meisten FPS.

Fazit:

Im CPU Limit vermag es DLSS die Min-Frames anzuheben und aus einer unschönen Ruckelpartie ein halbwegs angenehmes Spielerlebnis abzuliefern, aber es ändert nichts daran dass DLSS der CPU deutlich mehr abverlangt. Gleichzeitig kann aber DLSS Ruckler, bedingt durch das CPU-Limit nicht ausgeglichen, ebenso wie Frame Generation. Mit DLSS fällt die CPU viel mehr ins Gewicht als ohne. In Spielen, welche entweder schlecht Optimiert sind, oder von Anfang an ein CPU-Limit besitzen, wird DLSS noch weit mehr zusetzen als es ohne der Fall wäre. DLSS ist nicht das besagte Allheilmittel für mehr FPS, ebenso wie Frame Generation, vor allem da beide Technologien im Zusammenspiel den Inputlag vergrößern.

Die CPU ist mit steigenden Auflösungen immer weiter in den Hintergrund gerückt, aber mit dem Aufkommen von DLSS hat die CPU wieder eine deutlich größere Relevanz. Zusätzlich verhält sich DLSS ( und auch Framegeneration) im CPU-Limit sehr komisch. Das ist mir weniger im integriertem Benchmark aufgefallen, dafür deutlicher beim Rundgang um Corpo Plaza. Inputlag ist bei DLSS und Framgeneration bekannt, aber im CPU-Limit hatten mache Inputs einen wahrnehmbaren Mikroruckler zur Folge. Es war nicht zu 100% reproduzierbar aber beim ausweichen von Passanten kam es häufiger vor, Obwohl Nvidia Refelex aktiviert war.

Die Annahme, CPU später aufrüsten, kann also auch nach hinten losgegehen. DLSS vermittelt den Eindruck, dass man spielbare Frames hat, aber Mikrorucker in Zusammenspiel mit Inputlag das Erlebnis zur Qual machen als zur Freude.

Ich hoffe, liebe Boardies, ihr nehmt mich nicht zu sehr auseinander. Im Anhang finden sich alle Ergebnisse ( Captures.rar) zur genauen Analyse in CapFrameX ( mit Erklärung meiner Kürzel) , sowie mein verwendetes Save Game für den Rundgang um Corpo Plaza.

In vielen Tests wird dann auch oft eine relativ aktuelle CPU genutzt, welche mehr als genug Leistung für alle Lebenslagen bereitstellt.

Im CB-Funk folge #16

Ab 11:50 wurde das Thema ja schon von @Jan und @Vitche angeschnitten, aber es kam nie so wirklich ein Follow Up.

Das Folgt jetzt:

Mithilfe einer 4070 einem etwas betagten i5 10400F auf einem Asrock H510M-ITX/ac mit 32Gb 2666mhz Ram: wird Cyberpunk 2077 in Insgesamt 39 Testdurchläufen, Nativ, mit DLSS ( Quality und Performance) sowie Framegeneration mit dem Max RT Preset und Path Tracing Preset Durchgescheucht.

Im Bios wurde die CPU einmal auf 4 Kerne und 8 Threads begrenzt und einmal komplett von der Leine gelassen als 6 Kerne mit 12 Threads.

Als Auflösung wurde 1920x1080 gewählt.

Bei den Graphen und Ansichten achten wir nur auf die Minimum, 1% percentile und den Durchschnitt. ( Ergebnisse finden sich dann nochmal im Anhang )

Als Erstes schauen wir uns die Performance mit 4/8 an im integrierten Benchmark an.

Wie zu erwarten Nativ weit abgeschlagen am Ende, aber der Unterschied zwischen DLSS Quality (Q) und Performance (P) ist fast marginal. Woran liegt es ?

Schauen wir dann auf die einzelnen Ergebnisse und lassen uns dazu die CPU und GPU Auslastung anzeigen wird das Bild klarer:

Nativ (Ohne DLSS)

Quality

Performance

Unsere 4 Kerne mit 8 Threads sind trotz einem Takt von 4,1 GHz zu langsam! DLSS schafft es nicht, die Performance zu verbessern, weil die CPU einfach nicht hinterher kommt. DIe Auslastung der GPU sinkt immer weiter und Pendelt sich zuletzt bei Performance bei Ca 50% ein.

Aber es gibt ja noch Frame Generation.. Ja, es sieht besser aus, aber Quality ist besser als Performance

Wir hängen einfach zu sehr im CPU-Limit, als das da noch was geht…

Performance

Mit Path Tracing wird es besser aber wir sehen trotzdem einen massiven Einbruch der GPU-Auslastung mit DLSS Performance

Performance / Quality

Den Aufmerksamen ist aber sicher schon aufgefallen, wie im letzten Drittel beim Aussenbereich vom Benchmark die CPU Last steigt. Die Darstellung von bewegten NPCs kostet CPU Leistung, also wie verhält sich das jetzt nun ingame? Einmal ein Savegame geladen und ein kurzer 30 Sekunden Rundgang um Corpo Plaza..

Was soll man da sagen:

Hartes CPU-Limit Quality und Performance nehmen sich fast nichts. Die minimalen FPS sind nur gegenüber Nativ Besser.

Die GPU-Auslastung fällt ins bodenlose. Mit DLSS-Performance liegt die Auslastung bei ca 40%, Selbst Ohne DLSS reichen 4 Kerne und 8 Threads einfach nicht aus.

Und Frame Generation? Besser aber Performance hat es nicht so mit der Performance … ( und ja ich hab das 3 mal getestet… )

Die GPU-Auslastung steigt um ca 10% mehr aber auch nicht.

4 Kerne sind dann wohl doch etwas wenig, wie sieht es mit 6 Kernen aus? Die CPU ist ja nicht so alt sollte doch reichen, oder?

Ehm: Nein, Gleiches Bild wie bei 4 Kernen, mit DLSS, schlägt das CPU-Limit wieder voll zu.

Nativ / Quality / Performance

Vor allem Ingame macht es sich wieder stark bemerkbar, wo Quality ähnlich wie Performance abliefert, das "Wundermittel" Framegeneration lässt die Zahlen auch nur größer werden aber ändert nichts am CPU Limit.

und selbst wenn wir Ingame die Auflösung auf 2560 x 1440 erhöhen, ändert es so gut wie nichts am CPU-Limit aber Performance Liefert diesmal die meisten FPS.

Fazit:

Im CPU Limit vermag es DLSS die Min-Frames anzuheben und aus einer unschönen Ruckelpartie ein halbwegs angenehmes Spielerlebnis abzuliefern, aber es ändert nichts daran dass DLSS der CPU deutlich mehr abverlangt. Gleichzeitig kann aber DLSS Ruckler, bedingt durch das CPU-Limit nicht ausgeglichen, ebenso wie Frame Generation. Mit DLSS fällt die CPU viel mehr ins Gewicht als ohne. In Spielen, welche entweder schlecht Optimiert sind, oder von Anfang an ein CPU-Limit besitzen, wird DLSS noch weit mehr zusetzen als es ohne der Fall wäre. DLSS ist nicht das besagte Allheilmittel für mehr FPS, ebenso wie Frame Generation, vor allem da beide Technologien im Zusammenspiel den Inputlag vergrößern.

Die CPU ist mit steigenden Auflösungen immer weiter in den Hintergrund gerückt, aber mit dem Aufkommen von DLSS hat die CPU wieder eine deutlich größere Relevanz. Zusätzlich verhält sich DLSS ( und auch Framegeneration) im CPU-Limit sehr komisch. Das ist mir weniger im integriertem Benchmark aufgefallen, dafür deutlicher beim Rundgang um Corpo Plaza. Inputlag ist bei DLSS und Framgeneration bekannt, aber im CPU-Limit hatten mache Inputs einen wahrnehmbaren Mikroruckler zur Folge. Es war nicht zu 100% reproduzierbar aber beim ausweichen von Passanten kam es häufiger vor, Obwohl Nvidia Refelex aktiviert war.

Die Annahme, CPU später aufrüsten, kann also auch nach hinten losgegehen. DLSS vermittelt den Eindruck, dass man spielbare Frames hat, aber Mikrorucker in Zusammenspiel mit Inputlag das Erlebnis zur Qual machen als zur Freude.

Ich hoffe, liebe Boardies, ihr nehmt mich nicht zu sehr auseinander. Im Anhang finden sich alle Ergebnisse ( Captures.rar) zur genauen Analyse in CapFrameX ( mit Erklärung meiner Kürzel) , sowie mein verwendetes Save Game für den Rundgang um Corpo Plaza.

Anhänge

Zuletzt bearbeitet:

(Testsystem ergänzt)