CDLABSRadonP... schrieb:

Unterm Strich wird eher anders herum ein Schuh draus: Wer acht Stunden am Tag zockt, sollte auf jeden Fall sicherstellen, dass die Hardware in jederlei Hinsicht (und eben auch in Punkto Effizienz --- sowohl von der Ausgangslage als auch in der Kalibrierung) über alle Zweifel erhaben ist.

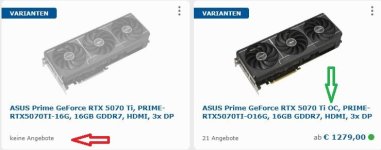

Aktuell - und bereits da ist ein weitere Fehler der Ursprungsrechnung - steht für dier 5070 Ti im Schnitt im Test von Wolfgang 265 W - die RX 9070 XT soll 304 W TBP haben, also sind es "nur" 39 W und damit reduziert sich bei 8 Stunden Spielen pro Tag die "Kostenersparnis" auf 11 Cent, macht pro Monat 3,28 € und pro jahr 39,32 €. Die "Kostenersparnis" nach 5 Jahren sind das dann 196,56 €.

Der Punkt "Effizienz" ist an dieser Stelle weitgehend einfach nur eine Nebelkerze, denn wenn es wirklich um Effizienz geht und man will die Kosten für das eigene Hobby gering halten, stehen hier am Anfang ganz andere Fragen, die sich nach 5 Jahren weitgehend deutlich bemerkbarer machen. Der Eingangspost zu dem Thema hat es schon sehr geschickt gemacht, in dem man einen entsprechenden Zeitraum von 5 Jahren gewählt hat und die Gesamtkosten dann nennt, weil sich 255,- € "dratischer" ließt, als eben 50 € pro Jahr oder 4,20 € pro Monat oder 14 Cent pro Tag.

Dazu kommt ein entscheidender aber wichtiger Faktor, der immer und immer wieder vergessen wird, und der solche Aussagen wie 255 € in 5 Jahren, oder eben 14 Cent pro Tag, vollkommen jeden Boden entzieht:

Wir reden einmal von laufenden Kosten, die in der Regel - zumindest bei uns in Deutschland - über monatliche Abschläge gezahlt werden und im anderen Fall von Einmalzahlungen, die entsprechend auch ins Gewicht fallen können.

Wenn ich pro Monat, weil eine RX 9070 XT 50 Watt mehr verbraucht, 4 € mehr an Stromkosten habe, dann ist das ein überschaubarer Betrag, der mir in der Regel nicht wehtut, weil ich ihn planen kann. Wenn eine Grafikkarte am Ende aber - als Beispiel - 200 € mehr kostet, dann tut das in der Regel wesentlich mehr weh, weil der absolute Betrag hier um den Faktor 50 höher ist.

Genau das ist in weiten Teilen aber auch eine psychologische Masche, mit der viele Menschen für "Dumm" verkauft werden. Händler brechen einem gerne den Einmalpreis auf ein monatlichen oder täglichen Preis runter, damit ein teurer Betrag nicht so groß wirkt und man ja dann sich die "monatlichen" Ausgaben halt um den Betrag senkt, dann ist das ja wieder locker drin.

Und umgekerht genauso, wenn man ja die monatlichen kosten gegen den große Gesamtbetrag stellt und was man ja dann auch "gespart" hat.

CDLABSRadonP... schrieb:

Kenne selbst jemanden, für den lange das Motto 24h bedeutet 8h Arbeiten + 8h Zocken + 8h Rest galt...

Joar, kenne ich auch, nur das von den keiner am Ende Arm geworden ist, weil er am Tag 0,14 Cent mehr für Strom einplanen musste.