Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Test Cyberpunk 2077 1.2: Die Community testet GPUs und CPUs in Night City

- Ersteller Jan

- Erstellt am

- Zum Test: Cyberpunk 2077 1.2: Die Community testet GPUs und CPUs in Night City

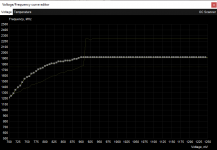

System: RTX 3090 CD UV, R7 3800X,3733CL14,AMDfix

3440x1440 Preset Mittel: 92,9

3440x1440 Preset Ultra: 68,0

3440x1440 Preset RT Mittel: 43,7

3440x1440 Preset RT Mittel + DLSS Qualität: 63,4

Custom loop 420rad, RTX 3090 Frostbite UV (OC) 340~350W @ 47°C 11K Mem, stock R7 3800X EKWB Velocity, Asus Crosshair VI X370, 4x8GB Gskill Flare-X @3733CL14.

3440x1440 Preset Mittel: 92,9

3440x1440 Preset Ultra: 68,0

3440x1440 Preset RT Mittel: 43,7

3440x1440 Preset RT Mittel + DLSS Qualität: 63,4

Custom loop 420rad, RTX 3090 Frostbite UV (OC) 340~350W @ 47°C 11K Mem, stock R7 3800X EKWB Velocity, Asus Crosshair VI X370, 4x8GB Gskill Flare-X @3733CL14.

Anhänge

-

CX_2020-12-18_19-43-34_Cyberpunk2077_.png90,4 KB · Aufrufe: 326

CX_2020-12-18_19-43-34_Cyberpunk2077_.png90,4 KB · Aufrufe: 326 -

CX_2020-12-18_19-44-28_Cyberpunk2077_.png87,1 KB · Aufrufe: 314

CX_2020-12-18_19-44-28_Cyberpunk2077_.png87,1 KB · Aufrufe: 314 -

CX_2020-12-18_19-44-35_Cyberpunk2077_.png96,8 KB · Aufrufe: 298

CX_2020-12-18_19-44-35_Cyberpunk2077_.png96,8 KB · Aufrufe: 298 -

CX_2020-12-18_19-44-50_Cyberpunk2077_.png95,7 KB · Aufrufe: 314

CX_2020-12-18_19-44-50_Cyberpunk2077_.png95,7 KB · Aufrufe: 314 -

3090_frostbite_UV.png21,4 KB · Aufrufe: 315

3090_frostbite_UV.png21,4 KB · Aufrufe: 315

Zuletzt bearbeitet:

- Registriert

- Mai 2011

- Beiträge

- 21.401

Z

ZeroStrat

Gast

Ist GitHub immer noch so lahm??

Perfekt, danke dirTaxxor schrieb:

@ZeroStrat ja Github ist irgendwie ein bisschen down

Z

ZeroStrat

Gast

Hab gerade mal ein paar Downloads gemacht, das rennt wie Schmidts Katze bei mir?!

System: RTX 3070 CD OC, R5 1600, 3000CL16

1920x1080 Preset Mittel: 38,6

1920x1080 Preset Ultra: 38,6

1920x1080 Preset RT Mittel: 28,2

1920x1080 Preset RT Mittel + DLSS Qualität: 28,3

2560x1440 Preset Mittel: 37,4

2560x1440 Preset Ultra: 39,1

2560x1440 Preset RT Mittel: 27,4

2560x1440 Preset RT Mittel + DLSS Qualität: 30,2

1920x1080 Preset Mittel: 38,6

1920x1080 Preset Ultra: 38,6

1920x1080 Preset RT Mittel: 28,2

1920x1080 Preset RT Mittel + DLSS Qualität: 28,3

2560x1440 Preset Mittel: 37,4

2560x1440 Preset Ultra: 39,1

2560x1440 Preset RT Mittel: 27,4

2560x1440 Preset RT Mittel + DLSS Qualität: 30,2

nic0tin

Cadet 4th Year

- Registriert

- Okt. 2008

- Beiträge

- 99

Die r9 290 würde mich schwer interessieren! Mein Prozessor ist zwar deutlich besser, aber die Graka macht mir doch ein "bißchen" Kopfschmerzen. Ich befürchte, jetzt ist die Zeit wohl auch da mal reif.Marcel55 schrieb:@Stirrling

Mit welchen Settings spielst du es?

Kommt man irgendwie über 30fps evtl. mit niedrigen Settings ohne Skalierung, oder notfalls mit?

Auch mal interessant so eine alte Karte zu sehen.

Vielleicht sollte ich es mal auf dem 2. Rechner im Haushalt ausprobieren (i5-2500K, R9 290)

dr_nickel

Cadet 1st Year

- Registriert

- Feb. 2009

- Beiträge

- 14

System: RTX2070S CD OC, i7 7700K, 3200 CL16

1920x1080 Preset Mittel: 82,5

1920x1080 Preset Ultra: 67,9

1920x1080 Preset RT Mittel: 54,2

1920x1080 Preset RT Mittel + DLSS Qualität: 57,3

2560x1440 Preset Mittel: 61,5

2560x1440 Preset Ultra: 43,7

2560x1440 Preset RT Mittel: 50,9

2560x1440 Preset RT Mittel + DLSS Qualität: 42,4

1920x1080 Preset Mittel: 82,5

1920x1080 Preset Ultra: 67,9

1920x1080 Preset RT Mittel: 54,2

1920x1080 Preset RT Mittel + DLSS Qualität: 57,3

2560x1440 Preset Mittel: 61,5

2560x1440 Preset Ultra: 43,7

2560x1440 Preset RT Mittel: 50,9

2560x1440 Preset RT Mittel + DLSS Qualität: 42,4

System: RTX 3060Ti FE OC, i7-4790k OC, 2666CL11

1920x1080 Preset Mittel: 60,1

1920x1080 Preset Ultra: 59,3

1920x1080 Preset RT Mittel: 43,3

1920x1080 Preset RT Mittel + DLSS Qualität: 44,5

2560x1440 Preset Mittel: 64,2

2560x1440 Preset Ultra: 49,3

2560x1440 Preset RT Mittel: 33,3

2560x1440 Preset RT Mittel + DLSS Qualität: 43,7

1920x1080 Preset Mittel: 60,1

1920x1080 Preset Ultra: 59,3

1920x1080 Preset RT Mittel: 43,3

1920x1080 Preset RT Mittel + DLSS Qualität: 44,5

2560x1440 Preset Mittel: 64,2

2560x1440 Preset Ultra: 49,3

2560x1440 Preset RT Mittel: 33,3

2560x1440 Preset RT Mittel + DLSS Qualität: 43,7

Zuletzt bearbeitet:

(1080p Benchmarks eingefügt)

T

Tutanchamun2008

Gast

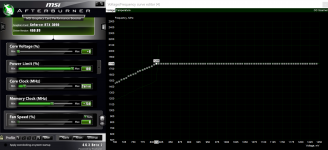

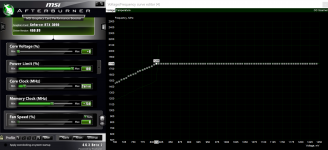

System: RTX 3090 FE UV, i9 9900K OC, 3800CL16

1920x1080 Preset Mittel: 106,4

1920x1080 Preset Ultra: 95,5

1920x1080 Preset RT Mittel: 67,6

2560x1440 Preset Mittel: 103,6

2560x1440 Preset Ultra: 73,2

2560x1440 Preset RT Mittel: 48,8

3840x2160 Preset Mittel: 62,8

3840x2160 Preset RT Mittel: 27,4

3840x2160 Preset RT Mittel + DLSS Qualität: 43,0

Die RTX 3090 läuft übertaktet/untervoltet durch den Curve-Editor im MSI-Afterburner. I9 9900K @ 4900 MHz (1.154 V unter Prime95 Last). 16GB (2x8 GB G.skill TridentZ) Samsung B-Die @ 1.35 V mit 3800 MHz CL 16-16-16-32 tRFC 304.

Das Spiel ist voller kleiner Fehler, selbst während des kurzen Benchmarkruns. Ich habe CD project wegen The Witcher 3 (welches überragend ist und aussieht) und der guten Qualität der Spiel auf GOG vertraut. Das war das erste Mal seit 10 Jahren, dass ich eine Spiel zum Vollpreis zum release kaufe...und das letzte Mal. Das Spiel muss 6-12 Monate reifen, dann kann man es spielen.

Raytracing ist ein Witz, der optische Mehrwert steht in KEINEM Verhältnis zum Leistungseinbruch. Der Platz auf meinem RTX 3090-Chip der von den nutzlosen!! Tensorkernen verbraucht wird, fehlt für mehr Shadereinheiten mit denen das Spiel jetzt locker auf über 60 FPS bei 4k rennen würde.

DLSS ist ebenfalls nichts, ich sehe sofort den Unterschied zu 4k (spiele auf einem 55 Zoll OLED), es ist deutlich unschärfer und das Bild unruhiger. Braucht kein Mensch.

Ich würde mir wünschen, dass ComputerBase deutlich kritischer mit Nvidia UND AMD umgeht. DLSS und Raytracing sind in ihrer jetzigen Form nutzlos beim spielen, eher Techdemo. Warum wird nicht Ultra @ 4k gebencht? Weil AMD dann schlecht dasteht? Wer 900 Euro und mehr für eine Grafikkarte ausgibt spielt auf WQHD @ 120 Hz oder wie ich bei 4k @ 120 Hz.

1920x1080 Preset Mittel: 106,4

1920x1080 Preset Ultra: 95,5

1920x1080 Preset RT Mittel: 67,6

2560x1440 Preset Mittel: 103,6

2560x1440 Preset Ultra: 73,2

2560x1440 Preset RT Mittel: 48,8

3840x2160 Preset Mittel: 62,8

3840x2160 Preset RT Mittel: 27,4

3840x2160 Preset RT Mittel + DLSS Qualität: 43,0

Die RTX 3090 läuft übertaktet/untervoltet durch den Curve-Editor im MSI-Afterburner. I9 9900K @ 4900 MHz (1.154 V unter Prime95 Last). 16GB (2x8 GB G.skill TridentZ) Samsung B-Die @ 1.35 V mit 3800 MHz CL 16-16-16-32 tRFC 304.

Das Spiel ist voller kleiner Fehler, selbst während des kurzen Benchmarkruns. Ich habe CD project wegen The Witcher 3 (welches überragend ist und aussieht) und der guten Qualität der Spiel auf GOG vertraut. Das war das erste Mal seit 10 Jahren, dass ich eine Spiel zum Vollpreis zum release kaufe...und das letzte Mal. Das Spiel muss 6-12 Monate reifen, dann kann man es spielen.

Raytracing ist ein Witz, der optische Mehrwert steht in KEINEM Verhältnis zum Leistungseinbruch. Der Platz auf meinem RTX 3090-Chip der von den nutzlosen!! Tensorkernen verbraucht wird, fehlt für mehr Shadereinheiten mit denen das Spiel jetzt locker auf über 60 FPS bei 4k rennen würde.

DLSS ist ebenfalls nichts, ich sehe sofort den Unterschied zu 4k (spiele auf einem 55 Zoll OLED), es ist deutlich unschärfer und das Bild unruhiger. Braucht kein Mensch.

Ich würde mir wünschen, dass ComputerBase deutlich kritischer mit Nvidia UND AMD umgeht. DLSS und Raytracing sind in ihrer jetzigen Form nutzlos beim spielen, eher Techdemo. Warum wird nicht Ultra @ 4k gebencht? Weil AMD dann schlecht dasteht? Wer 900 Euro und mehr für eine Grafikkarte ausgibt spielt auf WQHD @ 120 Hz oder wie ich bei 4k @ 120 Hz.

- Registriert

- Juni 2017

- Beiträge

- 4.125

funkflix schrieb:System: RTX 3090 CD OC, R9 5900X OC, 3800CL14

2560x1440 Preset Ultra: 88,1

5900X @ 4750MHz Allcore

3090 TUF OC @ 2055/10838MHz

2x16GB 1900MHz 14-14-14-28 1T

Anhang anzeigen 1011877

Wie viel Watt darf deine GPU ziehn?

Dein Ergebnis geht sich unter 550-600W nicht ganz auf

Esenel schrieb:Wie viel Watt darf deine GPU ziehn?

Dein Ergebnis geht sich unter 550-600W nicht ganz auf

Die Karte hat einen Shuntmod an den 8-Pins, ab 2070MHz ist dann leider Ende wegen den 75W am PCI-E, den

muss ich erst noch modden. Die karte zieht um die 450 - 500W.

Der komplette PC hat im Peak 602W bei dem Benchmark gezogen.

Und ja, da sind WHEA-Errors, der 5900X ist @ 4750MHz leider nicht stabil.. Bin grad noch am austesten,

mit 4700MHz läufts.

Schnils911

Cadet 3rd Year

- Registriert

- Nov. 2007

- Beiträge

- 61

System: RTX 2060 CD, R5 2600, 3600CL18

1920x1080 Preset Mittel: 56,7

1920x1080 Preset Ultra: 47,3

1920x1080 Preset RT Mittel: 16,7

1920x1080 Preset RT Mittel + DLSS Qualität: 29,4

2560x1440 Preset Mittel: 42,4

2560x1440 Preset Ultra: 28,7

2560x1440 Preset RT Mittel: 12,3

2560x1440 Preset RT Mittel + DLSS Qualität: 18,2

1920x1080 Preset Mittel: 56,7

1920x1080 Preset Ultra: 47,3

1920x1080 Preset RT Mittel: 16,7

1920x1080 Preset RT Mittel + DLSS Qualität: 29,4

2560x1440 Preset Mittel: 42,4

2560x1440 Preset Ultra: 28,7

2560x1440 Preset RT Mittel: 12,3

2560x1440 Preset RT Mittel + DLSS Qualität: 18,2

- Registriert

- Juni 2017

- Beiträge

- 4.125

funkflix schrieb:Die Karte hat einen Shuntmod an den 8-Pins, ab 2070MHz ist dann leider Ende wegen den 75W am PCI-E, den

muss ich erst noch modden. Die karte zieht um die 450 - 500W.

Der komplette PC hat im Peak 602W bei dem Benchmark gezogen.

Dann wunderts mich fast umso mehr denn meine darf 520W ziehn.

Und die von nem Kollegen 520W Bios + Shunts und er hat weniger Punkte also du 🙃

Hast du HAGS aktiviert?

Ähnliche Themen

- Antworten

- 910

- Aufrufe

- 88.434

- Antworten

- 275

- Aufrufe

- 22.514

- Antworten

- 1.423

- Aufrufe

- 143.859

- Antworten

- 730

- Aufrufe

- 149.324

- Antworten

- 162

- Aufrufe

- 18.071