Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Notiz Doom Eternal: Nvidia vergleicht GeForce RTX 3080 mit RTX 2080 Ti in 4K

- Ersteller Wolfgang

- Erstellt am

- Zur Notiz: Doom Eternal: Nvidia vergleicht GeForce RTX 3080 mit RTX 2080 Ti in 4K

Wäre da nicht der mickrige Speicher. Die 3070 mit 16 GB und ich hätte mir die sofort zu Release geholt.t3chn0 schrieb:Es werden je nach Usecase zwischen 40-100% Mehrleistung ggü. einer 2080Ti sein. Das ist für den Preis schon ein extremer Sprung.

[wege]mini

Banned

- Registriert

- Juli 2018

- Beiträge

- 8.357

t3chn0 schrieb:Es werden je nach Usecase zwischen 40-100% Mehrleistung ggü. einer 2080Ti sein.

Egal was Nvidia für Zahlen verspricht.

Die doppelte Anzahl der Shader entspricht nicht der doppelten Leistung. Sie haben eine schöne Lösung gefunden, die mehr oder weniger mit HT oder SMT vergleichbar ist. Besser, aber nicht perfekt.

Bei wirklich guter Software, kann die 3090 100% schneller sein, als die 2080Ti in FPS bei Games. Möglicher weise.

Die neuen Karten sind wirklich gut. Die 3070 wäre ohne AMD wohl die neue 3080 geworden und die 3090 wäre für das upgrade als "super" nächstes Jahr gekommen.

Warum aber immer meckern? Der Preis von 499 ist mehr als lecker und hier darf man bei den kleinen Babys auch mal danke sagen.

20 Nvidia Marketing TFlop für 500 bucks.....geil. Nehm ich².

mfg

MeisterOek

Commander

- Registriert

- Nov. 2014

- Beiträge

- 3.071

TorgardGraufell schrieb:Bin noch auf einer 1080 oc unterwegs....die kommt dann in Wohnzimmer Pc

.Sentinel. schrieb:Da muss man ein wenig aufpassen. Es ist ja meines Wissens noch nichtmal bekannt, ob da z.B. DLSS zum Einsatz kam oder auch nicht.

Dadurch dass DLSS ein festes Budget in der Frametime hat, könnte eine 3080 prozentual bei dessen Nutzen noch einmal zusätzlich Abstand zur 2080 TI gewinnen.

Die Tensor- Einheiten sind auf der 3080 gut doppelt so stark....

Wobei es bei den bisherigen Benchmarks (die ICH gesehen habe), völlig egal ist, ob die Spiele "nativ" oder mit Raytracing bzw. DLSS sind. Es wurden 2000er mit 3000er verglichen und beide Kartenserien haben in der Hinsicht die gleichen Features. Also Chancengleichheit auf beiden Seiten.

.Sentinel.

Admiral

- Registriert

- Okt. 2007

- Beiträge

- 8.650

McFritte schrieb:Es wurden 2000er mit 3000er verglichen und beide Kartenserien haben in der Hinsicht die gleichen Features. Also Chancengleichheit auf beiden Seiten.

Da DLSS ein Verfahren ist, welches fest auf ein Zeitbudget geht, besteht da schon ein Unterschied. Je höher die Auflösung, umso höher wird auch prozentual eine 3080 eine 2080 in die Schranken weisen.

.Sentinel. schrieb:Da DLSS ein Verfahren ist, welches fest auf ein Zeitbudget geht, besteht da schon ein Unterschied. Je höher die Auflösung, umso höher wird auch prozentual eine 3080 eine 2080 in die Schranken weisen.

Das mag sein, ich weiß nur in Grundzügen was DLSS ist. Das ändert aber nichts an der Tatsache, das es beide Karten nutzen können. Wie die das intern handhaben, ist mir als Anwender völlig egal. Da zählt doch was an Leistung am Ende rauskommt.

Etwas unfair wird es natürlich, wenn man eine AMD mit 4K-Auflösung arbeiten läßt, während die NVidia mit 2K und DLSS (was AMD verwehrt bleibt) arbeitet. Aber selbst da wäre es mir (!) ziemlich egal, wenn die Bildqualität vergleichbar ist. Ob die das Ergebnis jetzt mit 4K, 2K+DLSS, Feenstaub oder einer täglichen Opfergabe erreichen

McFritte schrieb:Das mag sein, ich weiß nur in Grundzügen was DLSS ist. Das ändert aber nichts an der Tatsache, das es beide Karten nutzen können. Wie die das intern handhaben, ist mir als Anwender völlig egal. Da zählt doch was an Leistung am Ende rauskommt.

Aber das ändert schon viel an der Tatsache...

Die neuen Karten haben nicht nur an der Shaderleistung zugelegt, die haben auch bei der RT und AI Leistung einen drauf gelegt. Spiele die RT und DLSS nutzen profitieren noch stärker von den neuen Chips, als Spiele die nur Rasterisierung verwenden.

cruse

Fleet Admiral

- Registriert

- Sep. 2013

- Beiträge

- 13.933

oder umrahmt mit lenden vom schwein in pfeffersoße..lolololol schrieb:Ihr meint wahrscheinlich eingeblendetem

und die gpu haben sie geklaut?Inxession schrieb:Haben die damals das NDA unterschrieben?

das braucht man nicht extra ausrechnen, das sieht man schon anhand einer vergleichtabelle, wenn man nur rein die shader und die fp32-tflops vergleicht und den preis links und rechts davon sieht.Vendetta schrieb:irgendjemand hat mal die Value per Cores ausgerechnet und kam dann zum Schluss, dass die 3080 von der Preisleistung vorrauslichtlich besser ist als die 3070 bei 500 Euro.

| Karte | RTX 3090 | RTX 3080 | RTX 3070 | RTX 2080 Ti |

| Shader | 10.496 | 8.704 | 5.888 | 4.352 |

| FP32-Leistung | 35,7 TFLOPS | 29,8 TFLOPS | 20,4 TFLOPS | 13,4 TFLOPS |

| Preis | 1499 | 699 | 499 | 1200 |

Zuletzt bearbeitet:

xexex schrieb:Aber das ändert schon viel an der Tatsache...

Die neuen Karten haben nicht nur an der Shaderleistung zugelegt, die haben auch bei der RT und AI Leistung einen drauf gelegt. Spiele die RT und DLSS nutzen profitieren noch stärker von den neuen Chips, als Spiele die nur Rasterisierung verwenden.

Ich glaube, wir reden hier gerade aneinander vorbei :-)

Die technische Seite ist natürlich höchst interessant für die zukünftige Entwicklung. Aber für mich (!) als dummen Anwender ist im Moment nur interessant was am Ende rauskommt.

Ich sehe mir die aktuellen Benchmarks der Spiele an die mich interessieren und die eine Karte hat mit Raytracing und DLSS 100% und die andere Karte 150% der FPS. Ob das nun an mehr Shadern, mehr RT-Kernen, höherem Takt oder frommen Gebeten liegt mag für die Zukunft entscheidend sein. Die aktuell getesteten Spiele/Benchmarks sind halt vergleichbar, da beide Serien Raytracing und DLSS nutzen können.

Ansonsten wird NVidia ganz sicher auch cherrypicking bei der Auswahl betrieben haben, so ganz traue ich der Sache noch nicht. In spätestens zwei Wochen sind wir alle schlauer, wenn die echten Tests erscheinen.

thepusher90

Lt. Commander

- Registriert

- Nov. 2011

- Beiträge

- 1.595

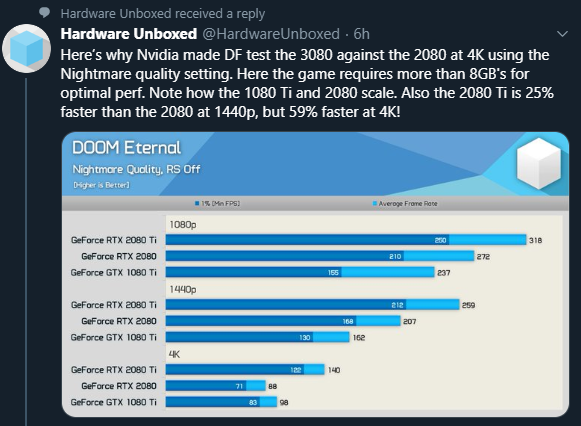

Hier auch noch ein sehr interessantes Video was Denkanstöße zu dem gezeigten geben kann. Besonders am Anfang des Videos, wo 2080 Ti und 1080 Ti nochmal verglichen werden. Interessant wie die Wahrnehmung von Jensen und seinen Slides des Performance Unterschiedes zwischen 2080 Ti und 1080 Ti von denen von Hardwareunboxed abweicht:

Und hier noch ein sehr valider Punkt:

Und hier noch ein sehr valider Punkt:

YouTube

An dieser Stelle steht ein externer Inhalt von YouTube, der den Forumbeitrag ergänzt. Er kann mit einem Klick geladen und auch wieder ausgeblendet werden.

Ich bin damit einverstanden, dass YouTube-Embeds geladen werden. Dabei können personenbezogene Daten an YouTube übermittelt werden. Mehr dazu in der Datenschutzerklärung.

Zuletzt bearbeitet:

Fred_VIE

Lt. Commander

- Registriert

- Sep. 2006

- Beiträge

- 1.367

4k endlich flüssig spielbar. Wobei Doom imho ein schlechtes Beispiel ist, so hässlich wie das aussieht. Abgesehn davon ist ja nicht bekannt, ob es in 4k rechnet oder eine kleinere Auflösung rauf rechnet. Somit ist 4k relativ.

Faszinierend finde ich wie zielgenau die alle schießen, wenn man bedenkt wie schnell die unterwegs sind und dann hupfen sie noch herum wie ein Flummi. Da komm ich schon lang nicht mehr mit hehe

Faszinierend finde ich wie zielgenau die alle schießen, wenn man bedenkt wie schnell die unterwegs sind und dann hupfen sie noch herum wie ein Flummi. Da komm ich schon lang nicht mehr mit hehe

Apocalypse

Vice Admiral

- Registriert

- Okt. 2012

- Beiträge

- 6.861

Doch, es war komplett falsch, weil wenn die 3090 2x so schnell wie die 2080ti ist, dann ist die 2080ti immer noch nur 50% langsamer. Das ist ein himmelweiter Unterschied zu dem was du gesagt hattest, weil du die Basis halt massiv verschiebst, gerade WEIL die neuen Karten so massiv viel schneller sind. 400% schneller sind übrigens 80% langsamer und 500% der Leistung, 1000% der alten FPS und die Karte ist 10x so schnell, aber die alte Karte nur 90% langsamer. Jetzt ist die 2080ti halt so 33 bis 50% langsamer als eine 3080 die auch noch weniger kostet. ;-)m.Kobold schrieb:Also war es dann doch nicht so falsch. Sondern es kommt nur drauf an wie man Argumentiert...

Ergo die 2080Ti war in Doom nur 33% langsamer... darauf wollte ich eigentlich auch hinaus.

Aber gut das wir das geklärt haben.. Klar, 50% weniger Leistung oder auch 30% klingt erst mal nach gar nicht soviel., ist aber doch mehr als Solide für eine neue Generation. Mehr hatten selbst Karten wie die legendäre 8800 nicht.

Zuletzt bearbeitet:

- Registriert

- Mai 2011

- Beiträge

- 21.554

xexex schrieb:Die neuen Karten haben nicht nur an der Shaderleistung zugelegt, die haben auch bei der RT und AI Leistung einen drauf gelegt. Spiele die RT und DLSS nutzen profitieren noch stärker von den neuen Chips, als Spiele die nur Rasterisierung verwenden.

Mich hat beim DF Video etwas gewundert, warum die durchschnittlichen 75% Unterschied sowohl bei den Spielen ohne RT+DLSS als auch bei Spielen mit RT+DLSS vorhanden waren.

Ich hätte erwartet, wenn man die Shader Performance erhöht, hat man die 75% Unterschied in non-RT Spielen.

Wenn man jetzt dazu die exakt gleiche RT Performance beibehalten hätte, müsste der Performanceverlust bei Nutzung von RT ja gleich stark bleiben und da man die RT Performance aber erhöht hat, sollte der Unterschied doch bei RT Nutzung nochmal größer ausfallen, was aber nicht der Fall war.

Aber nochmal drüber nachgedacht macht es doch irgendwo Sinn:

Wenn ich mehr Shaderleistung habe, dann habe ich mehr FPS, sagen wir statt 100 nun 160.

Wenn ich jetzt RT zuschalte, dann muss eine 2080 das mit 100FPS als Basis stemmen, eine 3080 aber mit 160.

Folglich braucht die 3080 auch ca gleich viel mehr RT Leistung um nicht prozentual stärker einzubrechen als die 2080. Hätte sie nur soviel RT Leistung wie die 2080 würde sie vmtl in die FPS Region der 2080 abstürzen.

Somit bleibt der Unterschied am Ende gleich

Apocalypse

Vice Admiral

- Registriert

- Okt. 2012

- Beiträge

- 6.861

Bis du sicher das du die 3070 für sowas 549€ oder auch 599€ genommen hättest? Nur wegen den 8GB mehr? Ich frag nur, weil der Speicher ja nicht umsonst ist, nicht mal für Nvidia. Bei 599 … ich muss zugeben, da hätte ich dann doch lieber die 11GB 3080 für 699 genommen.Vitali.Metzger schrieb:Wäre da nicht der mickrige Speicher. Die 3070 mit 16 GB und ich hätte mir die sofort zu Release geholt.

Dabei verstehe ich die Gier nach dem Speicher durchaus, haben ist bekanntlich besser als brauchen.

t3chn0 schrieb:

Rocket Lake mit der neuen Core Architektur und eine 3090...das wäre doch eigentlich genau das richtige für dich.

@Volker schaut doch dieses mal, ob ihr euch mit @Esenel und @KlaraElfer kurzschliessen könnt. Bei dem Leistungssprung bei den GPUs braucht es dringend einen Nachtest der CPUs mit Core/Ram OC.

Zuletzt bearbeitet von einem Moderator:

(Komplettzitat entfernt)

Cyberbernd

Lt. Commander

- Registriert

- Sep. 2002

- Beiträge

- 1.250

LegeinEi schrieb:

Hi

lol... Hallo alter Mann....

Mal so vom alten Sack zu altem Sack: für eher ruhigeres Gaming wäre da Horizon Zero Down auf jeden Fall etwas.

Da kann "man" problemlos durch die Landschaft schleichen und Kämpfe auch umgehen wenn "man" will.

DAS liebe ich so an dem Game.

Sooo...und jetzt weiter meinen Rollator polieren...ist schließlich Wochenende.

Gruß Bernd

Zuletzt bearbeitet:

(Komplettzitat entfernt)

.Sentinel.

Admiral

- Registriert

- Okt. 2007

- Beiträge

- 8.650

Im Q&A auf Reddit haben sie das relativ gut erklärt.Taxxor schrieb:Wenn man jetzt dazu die exakt gleiche RT Performance beibehalten hätte, müsste der Performanceverlust bei Nutzung von RT ja gleich stark bleiben und da man die RT Performance aber erhöht hat, sollte der Unterschied doch bei RT Nutzung nochmal größer ausfallen, was aber nicht der Fall war.

Es gibt da schon unterschiede. Mit der Neuorganisation der SMs haben sie tatsächlich je nach Szenario die einzeln ansprechbaren CUDA- Cores verdoppelt. Mit der Abhängigkeit, dass rein rasterbasiert immernoch ein guter Anteil Int reingemischt ist und man sich für eine reine doppelte oder einfache gemischt- Nutzung entscheiden muss.

Das heisst, dass einige SMs per Rasterizer zwar im verdoppelten Modus arbeiten können, jedoch andere auf dem klassischen Modell bleiben. Damit steigt die Leistung zwar spürbar an, aber nicht so weit, wie man es bei einer Verdoppelung der Einheiten inkl Effizienzsteigerungen im I/O System im Hintergrund vielleicht erwarten könnte. Das war bei der Präse aber eine DER großen Überraschungen.

Für RTRT ist die neue Organisation wiederum optimal, da dort vorhin das Problem bestand, dass die FP32 Ressourcen der SMs deutlich zu knapp waren. Da hat man nun im Hybrid Szenario erheblich mehr Ressourcen für die kleinteiligen und schwer koherent zu bekommenden Rayshader zur Verfügung.

Soll heissen, wo Du vorher tatsächlich die RT Engine auf 5000 Shader losgelassen hast, lässt Du sie jetzt auf im schlechtesten Fall auf dediziert rund 2500 extra cores los, hättest aber noch die vollen 5000 FP/Int32 auf Lager.

Rein theoretisch führt das dazu, dass bei zugeschaltetem RT die Leistung anteilig weit weniger einbrechen sollte, als zuvor...

Ich bin ziemlich gespannt, ob sich das dann bei meinen Tests im Visual Studio dann in der Praxis genau so nachstellen lässt und was da tatsächlich dann an Performance rauszuholen ist.

Zuletzt bearbeitet:

Apocalypse

Vice Admiral

- Registriert

- Okt. 2012

- Beiträge

- 6.861

Was mir gerade einfällt … Doom Eternal, 4k max Textures … da ist eine 2080 doch langsamer als eine 1080ti. Schneller Speicher hilft halt nicht, wenn der VRAM einfach nicht groß genug ist. Und in dem Fall sind die 8GB der 2080 nicht genug.

Das relativiert dann zumindest den Digital Foundry Benchmark ziemlich? Was haben sie sonst noch drin wo die 8GB voll laufen?

Das relativiert dann zumindest den Digital Foundry Benchmark ziemlich? Was haben sie sonst noch drin wo die 8GB voll laufen?

Ähnliche Themen

- Antworten

- 51

- Aufrufe

- 5.930

- Antworten

- 23

- Aufrufe

- 7.080

- Antworten

- 39

- Aufrufe

- 8.083

- Antworten

- 90

- Aufrufe

- 10.799

- Antworten

- 22

- Aufrufe

- 4.914

Bei den mit Info-Icon markierten Links handelt es sich um Affiliate-Links. Im Fall einer Bestellung über einen solchen Link wird ComputerBase am Verkaufserlös beteiligt, ohne dass der Preis für den Kunden steigt.