@xStram Ich will Grundsätzlich nicht nie sagen (daher der Cern Verweis) aber einen instabilen Zustand(Quarks) kann man dann wohl auch nur über eine instabile Leiterbahn schicken, was ich mir schwer vorstelle (aber klar die Problematik des vorstellen könnens)

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

News Intel blickt in die Zukunft: 15-nm-Fertigung

- Ersteller Volker

- Erstellt am

- Zur News: Intel blickt in die Zukunft: 15-nm-Fertigung

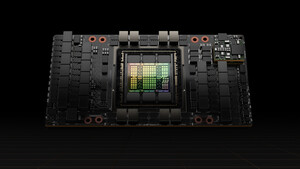

Sind Leiterbahnen in einer CPU nicht aus Gold?, Das Silizium wird doch nur entsprechend PNP etc dotiert um zu schalten. Die eigentlichen Leiterbahnen um von Mosfet ausgang A zum eingang E eiens anderen zu gelangen aus was besteht dies eigentlich? Das müsste doch mit Thermo-Sonic-Bonden geschehen also mit Golddrähten oder?

Leiterbahnen auf einer Leiterplatte sind aus ganz normalem Kupfer überzogen mit Lack. Wie sieht das in einer CPU aus? Würde sowas gern mal sehen

/Dev

Leiterbahnen auf einer Leiterplatte sind aus ganz normalem Kupfer überzogen mit Lack. Wie sieht das in einer CPU aus? Würde sowas gern mal sehen

/Dev

192.168.1.1

Lieutenant

- Registriert

- Okt. 2005

- Beiträge

- 785

Naja, es war klar dass man kleine Teams schon mit der Technologie von übermorgen experimentieren lässt. Allerdings ist der Prozess ja noch etliche Jahre von der Marktreife entfernt. Kein Grund jetzt auf die 15nm-CPUs zu warten

Und zu den Aussagen bezüglich des immer weitergehenden Fortschritts: Ja, natürlich gibt es keine Grenzen für den Fortschritt, wäre doch auch echt blöd wenn das so wäre, nicht wahr?

Schonmal was von Physik gehört? Die gibt nämlich vor wie groß (oder besser gesagt wie klein) ein Teilchen sein kann und was wie leiten kann. Und wer glaubt man könne alles mit ein bißchen mehr Forschung durch ein bißchen mehr Investitionen lösen, hat sich in eine ziemlich naive Weltanschauung verrannt. Auch Chiphersteller kochen nur mit Wasser (das sind tatsächlich auch nur Menschen!), einige scheinen zu glauben dass die über eine gottgleiche Allmacht verfügen. Dem ist aber nicht so. Eines Tages wird der Fortschritt in diesem Bereich praktisch zum Erliegen kommen.

Es artet hier in Philosophie aus, aber: Warum glauben einige Leute dass die Menschheit jegliche Grenzen überwinden kann? Das ist doch völlig irrational zu glauben, alles müsste machbar sein weil es dem Menschen Vorteile bringt. Warum sollte das so sein?

Und zu den Aussagen bezüglich des immer weitergehenden Fortschritts: Ja, natürlich gibt es keine Grenzen für den Fortschritt, wäre doch auch echt blöd wenn das so wäre, nicht wahr?

Schonmal was von Physik gehört? Die gibt nämlich vor wie groß (oder besser gesagt wie klein) ein Teilchen sein kann und was wie leiten kann. Und wer glaubt man könne alles mit ein bißchen mehr Forschung durch ein bißchen mehr Investitionen lösen, hat sich in eine ziemlich naive Weltanschauung verrannt. Auch Chiphersteller kochen nur mit Wasser (das sind tatsächlich auch nur Menschen!), einige scheinen zu glauben dass die über eine gottgleiche Allmacht verfügen. Dem ist aber nicht so. Eines Tages wird der Fortschritt in diesem Bereich praktisch zum Erliegen kommen.

Es artet hier in Philosophie aus, aber: Warum glauben einige Leute dass die Menschheit jegliche Grenzen überwinden kann? Das ist doch völlig irrational zu glauben, alles müsste machbar sein weil es dem Menschen Vorteile bringt. Warum sollte das so sein?

20462046

Lieutenant

- Registriert

- März 2008

- Beiträge

- 534

Weil man den Menschen nicht zufrieden stellen kann. Es geht immer weiter. Einen Stillstand kann ich mir einfach nicht vorstellen.

Ich erinnere gerne an Bill Gates, dass wir alle ja niemals mehr als 640 KB Ram benötigen werden.

Ich erinnere gerne an Bill Gates, dass wir alle ja niemals mehr als 640 KB Ram benötigen werden.

Zuletzt bearbeitet:

Bl4ckbeard

Lt. Junior Grade

- Registriert

- März 2009

- Beiträge

- 352

@ 192.168.1.1 die Physik stellt den aktuellen Wissenstand der Menschheit da, wobei die Forschung den zukünftigen Wissenstand darstellt.

Wenn ich die aktuelle Entwicklungsgeschwindigkeit der Computer ansehe wird es wohl kaum 20 jahre dauern bis die 1 nm Fertigung gebrochen wird.

An alle Zweifler vor 10 Jahren dachte auch keiner das man 32 nm große Computerchips bauen kann und jetzt ist es zur Normalität gewurden.

Momentan entwickelt sich die Menschheit so schnell das man es kaum noch mitverfolgen kann und das nicht nur wissenschaftlich sondern auch ideologisch.

Ich weis noch vor ca. 20 Jahren als ich die ersten Startrekfolgen gesehen habe da dachte ich mir immer, wau sowas wäre toll wenn das Ginge, und jetzt sind einige Sachen von denen schon fast veraltet.

Wenn ich die aktuelle Entwicklungsgeschwindigkeit der Computer ansehe wird es wohl kaum 20 jahre dauern bis die 1 nm Fertigung gebrochen wird.

An alle Zweifler vor 10 Jahren dachte auch keiner das man 32 nm große Computerchips bauen kann und jetzt ist es zur Normalität gewurden.

Momentan entwickelt sich die Menschheit so schnell das man es kaum noch mitverfolgen kann und das nicht nur wissenschaftlich sondern auch ideologisch.

Ich weis noch vor ca. 20 Jahren als ich die ersten Startrekfolgen gesehen habe da dachte ich mir immer, wau sowas wäre toll wenn das Ginge, und jetzt sind einige Sachen von denen schon fast veraltet.

M

Mr. Snoot

Gast

Alles Kupferverdrahtung, nur der erste Kontakt zum Silicium erfolgt mit Wolfram. Gebondet wird zu diesem Zeitpunkt noch gar nichts, das Kupfer wird in strukturierte Schichten abgeschieden. Bonddrähte kommen zum Schluss aber wegen des Platzbedearfs auch nicht überall zum Einsatz.devvi schrieb:Sind Leiterbahnen in einer CPU nicht aus Gold?

Hier gibts ein nettes Video von AMD/GlobalFoundries, wie ein Chip entsteht: http://globalfoundries.com/ (rechts am Rand)

Canyonero

Ensign

- Registriert

- Juni 2009

- Beiträge

- 160

@grandechef:

Ja, der nächste Krieg wirds schon richten. Höhö, Spaß beiseite.

Silizium nicht mehr, da wirds wohl eher Carbon-Valley geben und nicht mehr Silicon-Valley. Aber die Strukturbreite wirds wohl immer geben solange man die CPUs traditionell fertigt.

Quantencomputer bekommen wir sowieso erst mit, wenn wir schon am Krückstock laufen.

Ja, der nächste Krieg wirds schon richten. Höhö, Spaß beiseite.

Silizium nicht mehr, da wirds wohl eher Carbon-Valley geben und nicht mehr Silicon-Valley. Aber die Strukturbreite wirds wohl immer geben solange man die CPUs traditionell fertigt.

Quantencomputer bekommen wir sowieso erst mit, wenn wir schon am Krückstock laufen.

Euphoria

Admiral

- Registriert

- Apr. 2007

- Beiträge

- 9.152

Graphit wird wohl Selizium ersetzen, da bei 15nm die Grenze eigentlich schon fast erreicht wird, bei der es zu Störungen durch den Strom kommt.

Wie meint ihr das mit 3D O.o

Es ist doch nicht flach, also schon 3D nur halt in mehreren Schichten und fürs Auge sind die Unterschiede zu klein.

@grandechef

Der meinte 640kb sind mehr als genug, dass man nie mehr brauchen wird hat er niemals gesagt.

@Mr. Snoot

Danke für den Hinweis.

Das Video ist faszinierend

Wie meint ihr das mit 3D O.o

Es ist doch nicht flach, also schon 3D nur halt in mehreren Schichten und fürs Auge sind die Unterschiede zu klein.

@grandechef

Der meinte 640kb sind mehr als genug, dass man nie mehr brauchen wird hat er niemals gesagt.

@Mr. Snoot

Danke für den Hinweis.

Das Video ist faszinierend

Zuletzt bearbeitet:

yurij

Lt. Commander

- Registriert

- Jan. 2008

- Beiträge

- 1.058

An der GHz Grenze scheint die Entwicklung im moment nicht wirklich weiter zu kommen. Seit wann tummmeln sich die Prozessoren um um die 3GHz Marke? 5 Jahre oder? Paar GHz mehr wären noch drin, dann dürfte schluss sein. nm-Grenze scheint nun auch in Sicht zu sein. Eine Frage von nur wenigen Jahren, zumindest mit dem aktuellen elektrischen Konzept.

Ich denke optimierungswege Wege gibt es sicherlich, wenn aber auch nur begrenzt.:

die dritte Dimension zu nutzen (mehrlagige oder vollständig 3-dimensionale Processoren).

Hochparallelisierung: Quadcores -> Hunderte von (vereinfahten) Cores. GPGU ähnlich.

Raum im Prozessorgehäuse wäre im gewissen Umfang noch vorhanden, die nötige Kühlung dürfte dann aber in beiden Fällen zu einem nichttrivialen Disaster werden.

Ich bin gespannt ob ich in den nächsten 30-40 Jahren ein völlig neues Konzept in einem Desktop erlebe, sei es Quanten-, Licht-, Organic- oder was-auch-immer-Computer.

Da gibt es noch eine Dimension - die Zeit. Klingt erstmal irrational (für unser Wissensstand). Aber angenommen wir könnten diese nutzen (wie auch immer). Wärend wir dem Prozessor ein komplexes Problem übergeben und bei uns eine Sekunde vergeht, könnten für den Prozessor in seiner Zeitrechnung Jahrhunderte vergehen - Zeit, in der es das Problem lösen könnte. Wäre gespannt wie hoch die TDP wäre abgesehen von Garantiebestimmungen. Also quasi eine zeitmaschine. Eventuell könnte man das Ergebnis wissen, schon bevor das Problem (Algorithmus) überhaupt formuliert wurde.

abgesehen von Garantiebestimmungen. Also quasi eine zeitmaschine. Eventuell könnte man das Ergebnis wissen, schon bevor das Problem (Algorithmus) überhaupt formuliert wurde.  Bitte verschont mitch vor kritischen Kommentaren. Das ist Computer-Bellitristik, ich ließ der Fantasie nur freien Lauf

Bitte verschont mitch vor kritischen Kommentaren. Das ist Computer-Bellitristik, ich ließ der Fantasie nur freien Lauf

Ich denke optimierungswege Wege gibt es sicherlich, wenn aber auch nur begrenzt.:

die dritte Dimension zu nutzen (mehrlagige oder vollständig 3-dimensionale Processoren).

Hochparallelisierung: Quadcores -> Hunderte von (vereinfahten) Cores. GPGU ähnlich.

Raum im Prozessorgehäuse wäre im gewissen Umfang noch vorhanden, die nötige Kühlung dürfte dann aber in beiden Fällen zu einem nichttrivialen Disaster werden.

Ich bin gespannt ob ich in den nächsten 30-40 Jahren ein völlig neues Konzept in einem Desktop erlebe, sei es Quanten-, Licht-, Organic- oder was-auch-immer-Computer.

Da gibt es noch eine Dimension - die Zeit. Klingt erstmal irrational (für unser Wissensstand). Aber angenommen wir könnten diese nutzen (wie auch immer). Wärend wir dem Prozessor ein komplexes Problem übergeben und bei uns eine Sekunde vergeht, könnten für den Prozessor in seiner Zeitrechnung Jahrhunderte vergehen - Zeit, in der es das Problem lösen könnte. Wäre gespannt wie hoch die TDP wäre

Euphoria

Admiral

- Registriert

- Apr. 2007

- Beiträge

- 9.152

Naja an sich sind das reine Spekulationen, dass er das gesagt hat.

Aber wenn man dem glaubt, dann gibt es viele Seiten wo sowas steht.

Auch bei heise.de wird es so zitiert.

Letzter Absatz sagt eigentlich alles zu diesem Zitat

Aber wenn man dem glaubt, dann gibt es viele Seiten wo sowas steht.

"640 kB sollten eigentlich genug für jeden sein." - angeblich 1981. Bill Gates dementiert

(Original engl.: "640 kB ought to be enough for anybody.")

Auch bei heise.de wird es so zitiert.

Letzter Absatz sagt eigentlich alles zu diesem Zitat

"640K should be enough for anyone"

Zuletzt bearbeitet:

@yurij

Ein Problem mit deinem Ansatz wäre die Strahlung, die so ein Prozessor erzeugt. Wenn für den Prozessor die Zeit hundert mal so schnell vergeht, dann hat die IR Strahlung die er aussendet in unserer Zeit eine hundert mal so hohe Frequenz, heißt es ist bereits UV Strahlung geworden, sobald es die Zeitblase verlässt. Mit größerem Unterschied in der Zeit, die vergeht wird daraus irgendwann Röntgen und Gammastrahlung. Ganz abgesehen davon, gibt es soweit ich weiß keine Möglichkeit, Zeit zu beschleunigen, sondern nur zu verlangsamen. Wir könnten uns also nur unser Zeitempfinden verlangsamen, wodurch wir wieder das Strahlungsproblem haben. Dann aber auch von anderen Quellen, wie der Höhenstrahlung, die dann noch intensiver wird.

Trotzdem eine schöne Möglichkeit.

Hier gibt es auch einen Artikel über die Grenzen von Moores Law, unabhängig von der Art der Rechnerarchtektur: http://www.kf6nvr.net/blog/archives/000201.html

Ein Problem mit deinem Ansatz wäre die Strahlung, die so ein Prozessor erzeugt. Wenn für den Prozessor die Zeit hundert mal so schnell vergeht, dann hat die IR Strahlung die er aussendet in unserer Zeit eine hundert mal so hohe Frequenz, heißt es ist bereits UV Strahlung geworden, sobald es die Zeitblase verlässt. Mit größerem Unterschied in der Zeit, die vergeht wird daraus irgendwann Röntgen und Gammastrahlung. Ganz abgesehen davon, gibt es soweit ich weiß keine Möglichkeit, Zeit zu beschleunigen, sondern nur zu verlangsamen. Wir könnten uns also nur unser Zeitempfinden verlangsamen, wodurch wir wieder das Strahlungsproblem haben. Dann aber auch von anderen Quellen, wie der Höhenstrahlung, die dann noch intensiver wird.

Trotzdem eine schöne Möglichkeit.

Hier gibt es auch einen Artikel über die Grenzen von Moores Law, unabhängig von der Art der Rechnerarchtektur: http://www.kf6nvr.net/blog/archives/000201.html

Zuletzt bearbeitet:

yurij schrieb:Ich denke optimierungswege Wege gibt es sicherlich, wenn aber auch nur begrenzt.:

die dritte Dimension zu nutzen (mehrlagige oder vollständig 3-dimensionale Processoren).

Was haben hier eigentlich hier immer alle mit 3D?! Ein Chip ist doch heute auch schon nicht 1D oder 2D ..... sondern eben in vielen Schichten. (hat hier zwar schon jemand andres angemerkt, scheint ja aber keinen zu interessieren...)

Ähnliche Themen

- Antworten

- 84

- Aufrufe

- 6.633

- Antworten

- 48

- Aufrufe

- 6.518

- Antworten

- 28

- Aufrufe

- 4.811

T

- Antworten

- 164

- Aufrufe

- 17.227

- Antworten

- 111

- Aufrufe

- 23.400

Bei den mit Info-Icon markierten Links handelt es sich um Affiliate-Links. Im Fall einer Bestellung über einen solchen Link wird ComputerBase am Verkaufserlös beteiligt, ohne dass der Preis für den Kunden steigt.