Vielen Dank für so einen ausführlichen Artikel, hatte bisher nur Zeit den zu überfliegen, aber ein genaueres Durchschauen ist zum WE geplant.

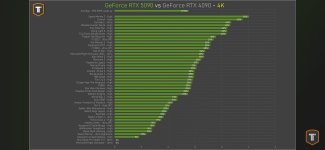

Die 5090 liefert ja genau das, was auch erwartet war nach den Leaks an Gaming Performance.

Danke auch für die 3DMark Ergebnisse, da schneidet sie ja doch deutlich stärker ab, also vielleicht ist der 9800X3D einfach nicht schnell genug für die Karte, in 4K wollen ja auch mehr Strahlen verfolgt werden, was CPU Last erzeugt. Wird noch spannend wie Blackwell dann nach unten skaliert, lt. 3DMark könnten ja knapp 10% mehrleistung pro SM Performance sein, was auch zu den ~15% Mehrleistung einer 5080 ggü. der 4080 passen würde.

Der IDLE Verbrauch der 5090 ist dann doch erschreckend, da sind die kleineren Karten hoffentlich besser.

DLSS 4 sieht sehr vielversprechend aus und Multiframegeneration schein auch gut zu funktionieren. Dass die Änderungen auch für die alten Gens komme ist sehr erfreulich, gerade für alle mit 4000er Karte, womit DLSS FG wohl den GAP zu FSR3 FG schließen kann. Bleibt noch zu hoffen, dass FSR4 die optische Qualität ggü. FSR3 verbessert um an DLSS SR ranzukommen und im besten Fall noch eine Konkurrenz für Ray Reconstruction in petto hat (oder zumindest nachgeliefert bekommt).

Die 5090 liefert ja genau das, was auch erwartet war nach den Leaks an Gaming Performance.

Danke auch für die 3DMark Ergebnisse, da schneidet sie ja doch deutlich stärker ab, also vielleicht ist der 9800X3D einfach nicht schnell genug für die Karte, in 4K wollen ja auch mehr Strahlen verfolgt werden, was CPU Last erzeugt. Wird noch spannend wie Blackwell dann nach unten skaliert, lt. 3DMark könnten ja knapp 10% mehrleistung pro SM Performance sein, was auch zu den ~15% Mehrleistung einer 5080 ggü. der 4080 passen würde.

Der IDLE Verbrauch der 5090 ist dann doch erschreckend, da sind die kleineren Karten hoffentlich besser.

DLSS 4 sieht sehr vielversprechend aus und Multiframegeneration schein auch gut zu funktionieren. Dass die Änderungen auch für die alten Gens komme ist sehr erfreulich, gerade für alle mit 4000er Karte, womit DLSS FG wohl den GAP zu FSR3 FG schließen kann. Bleibt noch zu hoffen, dass FSR4 die optische Qualität ggü. FSR3 verbessert um an DLSS SR ranzukommen und im besten Fall noch eine Konkurrenz für Ray Reconstruction in petto hat (oder zumindest nachgeliefert bekommt).