Chismon

Admiral

- Registriert

- Mai 2015

- Beiträge

- 8.873

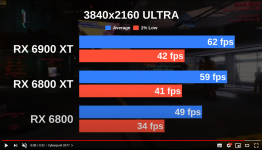

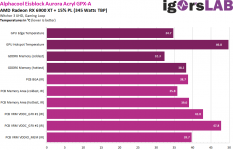

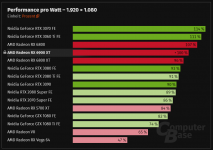

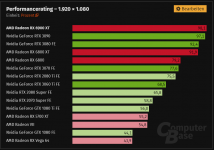

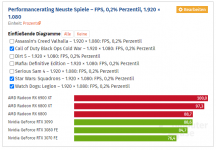

Aufgebrezelt (mit Wasserkuehler, somit immer noch deutlich guenstiger als eine RTX 3090) schafft eine RX 6900XT auch eine (Rasterisierungs-)Leistung auf Augenhoehe mit einer RTX 3090, siehe nachfolgendes Video von Igor'sLab:

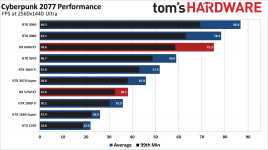

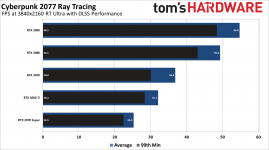

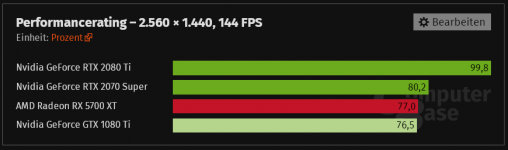

Tja, damit verliert eine RTX 3090 fast die Daseinsberechtigung (angesichts der nVidia Preisvorstellungen fuer diese), wenn man nicht in gerade einmal einem halben Dutzend gehypten Titeln RT-Raytracing und/oder DLSS nutzen will oder aber professionelle Software mit Hilfe der verbauten 24GB Speicher und fuer eine Gaming-GPU staerkere Compute-Leistung nutzen moechte.

So gesehen ist diese RX 6900XT gar nicht so schlecht/teuer fuer ein Halo-Produkt (im Vergleich zu dem RTX 3090 Halo-Produkt der Konkurrenz). Kaufen wuerde ich mir eine solche aber auch nicht und schliesslich will man sich noch (kuenstlich) mit einer kolportierten RTX 3080Ti seitens nVidia in den Benchmarks vor eine RX 6900XT schieben, aber natuerlich ohne Beruecksichtigung von OC bzw. schlechter Effizienz (auf RTX Ampere Niveau) .

.

JayzTwoCents schaue ich mir auch gerne an, da i.d.R. sehr unterhaltsam, aber wirklich unvoreingenommen ist er (leider) auch nicht (da ist Steve Burke von Gamer's Nexus m.M.n. objektiver), das gibt er auch (in diesem Video) offen zu, dass er tendenziell ein nVidia Fan ist und zudem sammelt er seit der GTX 780Ti die Kingpin EVGA GPUs.

JayzTwoCents ist m.M.n. noch ein groesserer EVGA als nVidia Fan (auch wenn einige boese Zungen ihn als nVidia TechTuber titulieren), was ja auch okay ist, aber angesichts dessen sollte man einige seiner geaeusserten Ansichten eher mit Vorsicht geniessen und ich denke Igor's Rezension und auch die von @Wolfgang hier sind da um Klassen objektiver und besser gelungen.

Um noch einmal auf JayzTwoCents zurueck zu kommen, ich teile aber seine Meinung, dass eine RX 6800(XT) da deutlich attraktiver und sinnvoller ist vom Preis-Leistungsverhaeltnis her als die vor kurzem vorgestellte RX 6900XT .

.

YouTube

An dieser Stelle steht ein externer Inhalt von YouTube, der den Forumbeitrag ergänzt. Er kann mit einem Klick geladen und auch wieder ausgeblendet werden.

Ich bin damit einverstanden, dass YouTube-Embeds geladen werden. Dabei können personenbezogene Daten an YouTube übermittelt werden. Mehr dazu in der Datenschutzerklärung.

Tja, damit verliert eine RTX 3090 fast die Daseinsberechtigung (angesichts der nVidia Preisvorstellungen fuer diese), wenn man nicht in gerade einmal einem halben Dutzend gehypten Titeln RT-Raytracing und/oder DLSS nutzen will oder aber professionelle Software mit Hilfe der verbauten 24GB Speicher und fuer eine Gaming-GPU staerkere Compute-Leistung nutzen moechte.

So gesehen ist diese RX 6900XT gar nicht so schlecht/teuer fuer ein Halo-Produkt (im Vergleich zu dem RTX 3090 Halo-Produkt der Konkurrenz). Kaufen wuerde ich mir eine solche aber auch nicht und schliesslich will man sich noch (kuenstlich) mit einer kolportierten RTX 3080Ti seitens nVidia in den Benchmarks vor eine RX 6900XT schieben, aber natuerlich ohne Beruecksichtigung von OC bzw. schlechter Effizienz (auf RTX Ampere Niveau)

Ergänzung ()

thepate94227 schrieb:... das Review von JayzTwoCents gesehen: YouTube

YouTubeAn dieser Stelle steht ein externer Inhalt von YouTube, der den Forumbeitrag ergänzt. Er kann mit einem Klick geladen und auch wieder ausgeblendet werden.

Ich bin damit einverstanden, dass YouTube-Embeds geladen werden. Dabei können personenbezogene Daten an YouTube übermittelt werden. Mehr dazu in der Datenschutzerklärung.Der würde die 6900XT aus mmn nachvollziehbaren Gründen nicht empfehlen. Schade, bei den GPUs ist wohl idr Nvidia die bessere Wahl. Ich bin gespannt, was es alles an Hardware 2022 geben wird.

JayzTwoCents schaue ich mir auch gerne an, da i.d.R. sehr unterhaltsam, aber wirklich unvoreingenommen ist er (leider) auch nicht (da ist Steve Burke von Gamer's Nexus m.M.n. objektiver), das gibt er auch (in diesem Video) offen zu, dass er tendenziell ein nVidia Fan ist und zudem sammelt er seit der GTX 780Ti die Kingpin EVGA GPUs.

JayzTwoCents ist m.M.n. noch ein groesserer EVGA als nVidia Fan (auch wenn einige boese Zungen ihn als nVidia TechTuber titulieren), was ja auch okay ist, aber angesichts dessen sollte man einige seiner geaeusserten Ansichten eher mit Vorsicht geniessen und ich denke Igor's Rezension und auch die von @Wolfgang hier sind da um Klassen objektiver und besser gelungen.

YouTube

An dieser Stelle steht ein externer Inhalt von YouTube, der den Forumbeitrag ergänzt. Er kann mit einem Klick geladen und auch wieder ausgeblendet werden.

Ich bin damit einverstanden, dass YouTube-Embeds geladen werden. Dabei können personenbezogene Daten an YouTube übermittelt werden. Mehr dazu in der Datenschutzerklärung.

Um noch einmal auf JayzTwoCents zurueck zu kommen, ich teile aber seine Meinung, dass eine RX 6800(XT) da deutlich attraktiver und sinnvoller ist vom Preis-Leistungsverhaeltnis her als die vor kurzem vorgestellte RX 6900XT

Zuletzt bearbeitet: