ZeroStrat schrieb:

Verwunderlich in dem Fall wäre dann allerdings, dass bisher noch nichts dergleichen passiert ist, weil Nvidia zum einen sehr schnell mit Treiberupdates ist und zum anderen ältere AC Teile noch nicht angefasst wurden in der Hinsicht.

Es ginge hier tatsächlich um Anspassungen im größeren Stil. Die Architekturen haben sich doch inzwischen stark gewandelt. Wenn Du Dir allerdings den Treiber anschaust, versucht der mit aller Gewalt quasi noch "einen Weg für alle Karten" auf einem relativ niedrigen gemeinsamen Nenner verfügbar zu halten.

Die Organisation bzw. die Stärken und die Schwächen der Generationen sind inzwischen ziemlich ausgeprägt. Noch schleppt man den alten Mist mit, weil sonst wieder die Schreihälse kommen, die von einer künstlich generierten Obsoleszenz der alten Karten sprechen, wenn die neuen dann auf einmal unverhältnismäßig davonziehen.

Eine Gratwanderung, die auch mit viel Know- How, Testing und Loslassen von großen, bewährten Teilen des Codes einhergehen inkl. der Gefahr von Bugs, Instabilitäten und Inkompatibilitäten mit den zehntausenden von Spielen auf dem Markt usw. usf.

Das gabs ja immer mal wieder, dass nvidia alte Zöpfe abgeschnitten hat... mit entsprechendem Shitstorm von leuten mit alten Grafikkarten, die von der Umstellung nicht profitieren konnten:

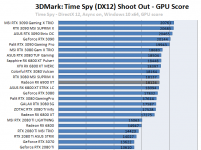

Ab dem Zeitpunkt ist es für Fermi unangenehm geworden. Und selbst innerhalb der selben Familie hat man in den oberen Rängen Steigerungen von teils 13% und mehr erhalten.

Die Lücke wurde mit den nachfolgenden Treibergenerationen weiter ausgebaut (mit entsprechenden Problemen, dass es Shitstorms gab, dass man absichtlich alte Karten ausbremsen würde).

ZeroStrat schrieb:

Nvidias bescheidene Performance in Verbindung mit Anvil ist ja fast schon ein alter Hut.

Auch hier werden die halt den Renderpfad maximal uniform gestalten und eine Spreizung erst spät stattfinden lassen.

Zudem ist Valhalla der erste DX12 Titel und wenn irgendwas kein Spaß ist, dann dort mit bestehenden Engines, die überhaupt nicht dafür geschaffen wurden, ins manuelle Micromanagement überzugehen. Auch da muss man alte Zöpfe abschneiden.

Rentiert sich aber derzeit nicht, weil durch RTRT und co. so viel Bewegung reingekommen ist, dass man in der Übergangszeit mit Übergangslösungen arbeitet.

So hat AMD mit einer explizit auf Inline- Raytracing ausgelegten Hardware darauf gesetzt, dass demnächst die Titel nur auf wenig komplexe bzw. auf einen Effekt beschränkte Raytracing- Effekte zum Einsatz kommen werden.

Jetzt gibt es aber Minecraft RTX &co. und auch z.B. ein Cyberpunk mit multi- RT Effekten, teils Pathtracing und komplexen Shadern (3x darf man raten, warum CDPR beim Launch keine AMD Unterstützung anbietet...).

Die kriegen das (erst recht ohne DLSS) derzeit schlichtweg auf der AMD Hardware im Standard nicht akzeptabel lauffähig.

Die Umgestaltung der Shaderbatterie bzw. die Reorganisation der Renderengine um das zumindest im Ansatz zu ermöglichen ist sehr aufwändig und das Ergebnis wird trotz Upscale- Notlösungen auf mehreren Ebenen spürbar unterlegen sein.