BlackRain85 schrieb:

Frau Su sagte, RDNA is a Journey like Zen. Zen hat nun 4 Updates bekommen und ist wohl die beste CPU im Augenblick. Sie hat damit klar gemacht wo die Reise hingeht. Und RDNA2 ist wie Zen2. RDNA3 ist dann sicherlich vergleichbar mit ZEN 3.

Die Basis für die kommende RDNA3 ist klasse.

- 5nm (für vielleicht 20 - 40 CU mehr?) und dann trotzdem 300W - 320W TBP

- einfache Aufstockung von Infinity Cache

- vorbehaltlich immer noch Platz für ein größeres Speicherinterface

- GDDR6X

Als Unternehmen glaube ich, dass AMD an einem Verkauf so einer GPU mehr Verdient als NVIDIA bei Ampere trotz geringeren Preisen. Das sichert zukünftig den Wettbewerb und uns darf es alle freuen.

EFFIZIENZ scheint das Lieblingswort von AMD geworden zu sein.

YES in weiten Teilen

Ob RDNA3 so einfach ala Zen3 agieren kann, glaub ich net. (liegt ja speziell an der Fertigung-Probs bei Intel)

Was aber für ne weitere gute Entwicklung spricht: man braucht noch net mal 5nm für nen einfachen Refresh

Raff-pcgh:

"Bemerkenswert ist, dass all das bei offiziell gleicher respektive nur optimierter Fertigungstechnologie passiert. AMD spricht wörtlich von "Optimized libraries" der von TSMC bereitgestellten 7-nm-Fertigung. Von DUV-Layern ist nirgends die Rede, was die Effizienzgewinne in hellem Licht erstrahlen lässt und außerdem einen Shrink im Jahr 2021 naheliegend macht."

5nm könnte man sich also noch für MCM aufheben, wobei ich gar net weiss Was man mit 4 Chips dann

anstellen würde. 8k ist irgendwie too much für den normalen Gamer.

Zu Effizienz:

3090@300W ist noch net der Rage-Mode, der auch etwas kosten sollte.

Vom Grundsatz aber sehr vernünftig, ohne Rage die 300W anzupeilen.

Damit sollten die meisten 2080Ti-User ohne NT-Wechsel auskommen.

btw.

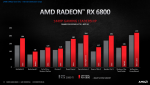

RX6800 scheint mir net nach der 3070 ausgerichtet sondern eher nach GA102-150=3080Salvage(3070Ti)

Da passt dann auch der Preis.

(das vermutlich die 3070-Customs schon so teuer wie die RX6800 sind ist ein Bonus für AMD)

Abgerechnet wird vermutlich in 1440p bei diesen Salvage-Modellen: