Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

News AMD Radeon RX 9070 (XT): Frank Azor verspricht RDNA-4-Event und attraktive Preise

SweetOhm

Commander

- Registriert

- Juli 2023

- Beiträge

- 2.561

Vermutlich eher mit einer 7900XT (für ca. 100 € mehr).Tornavida schrieb:Naja, eine vermutlich von der Wertigkeit vergleichbare 7900 GRE gabs auch schon vor einem Jahr zu diesem Preis und es gab auch günstigere.

Ergänzung ()

Freud´scher Versprecher ?? meintest wohl obsoletmartin_m schrieb:Die 5070 ohne Ti ist dank der 12GB absolut interessant.

Anhänge

Zuletzt bearbeitet:

SweetOhm

Commander

- Registriert

- Juli 2023

- Beiträge

- 2.561

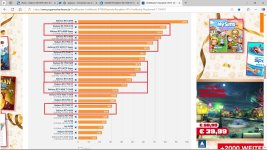

RDNA3 vs. ADA und ihre (Preis) "Gegner" (siehe Anhang)Chismon schrieb:Das waren sie (auch zu Recht, wenn man sich RDNA2 gegeben Ampere dGPU-Generationen mittlerweile anschaut, sieht letztere Generation eher schlecht aus,

Ergänzung ()

Und 95 % wollen den Weltfrieden ...Fighter1993 schrieb:Naja Lauf der Sonntagsumfrage wollen aktuell 15,1% der Befragten eine 5090 erwerben.

Das ist keine Randgruppe mehr.

Anhänge

Zuletzt bearbeitet:

Knobi Wahn

Lt. Commander

- Registriert

- Okt. 2013

- Beiträge

- 2.040

Die sollen in die Pötte kommen.

Heute Nachmittag hat sich meine 5700XT verabschiedet.🤮

Dieses mal muss ich wohl zu den Erstkäufern zählen, die 7950 macht nicht wirklich Spaß.

Heute Nachmittag hat sich meine 5700XT verabschiedet.🤮

Dieses mal muss ich wohl zu den Erstkäufern zählen, die 7950 macht nicht wirklich Spaß.

Aber er hat recht, ohne die Konsolen sähe es bei AMD was das Gaming anbelangt ziemlich düster aus.LamaMitHut schrieb:@bensen

https://www.golem.de/news/grosskund...trag-fuer-playstation-6-chip-2409-189009.html

Jedenfalls reichen die Konsolen-APUs um Intel dahin zu treten, wo es weh tut.

AMD konnte bisher im PC Gaming GPU Markt kaum von den Konsolen-Wins profitieren.LamaMitHut schrieb:Mal ganz davon abgesehen das man mit Sony gemeinsam an RDNA5/UDNA arbeitet, in Handheld PCs und gaming Notebooks ne Menge Wachstumspotenzial hat, und das ganze z.B. an Samsung lizenziert (exynos).

Wenn AMD Fidelity FX ein grundlegender Bestandteil des Softwarestacks der Konsolen gewesen wäre, dann hätte es IMO AMD ganz sicher auch im PC Gaming Markt geholfen. Aber Sony und Microsoft haben bei der Software ihr eigenes Ding gemacht.

Und je weniger Marktanteil AMD im GPU Markt hat, desto mehr Entwickler ignorieren AMD GPUs. Desto schlechter laufen die Games dieser Entwickler auf AMD GPUs.

AMD holt sich im ganzen PC Gaming GPU Markt eine blutige Nase. Und das hat Gründe.LamaMitHut schrieb:Ne, soll man lieber in eine andere Richtung gehen als sich ständig ne blutige Nase zu holen.

Diese Gründe verschwinden nicht, weil AMD das Produktportfolio noch mehr einschränkt.

Wenn AMD keinen Konkurrenten für die 5080 bringen sollte, weil AMD es sich nicht mehr leisten kann, dann wäre es ein Alarmsignal und kein Grund zum Jubeln.*)

AMD kann keinen Konkurrenten zur 5090 bringen und konnte auch keinen zur 4090 bringen. Selbst nach den geschönten Zahlen zum Navi 31 Launch lag die 4090 ca. 15 % vorne. Bei den unabhängiger Tests waren es dann ca. 30 %. Nvidia kann den AD102 locker refinanzieren, da er nur als Gaming GPU verwendet wird sondern in semiprofessionellen und professionellen Anwendungen eingesetzt wird.

*) Es sind auch andere Gründe denkbar, warum RDNA 4 Line up nur aus 2 Dies besteht. Über einen habe ich hier spekuliert.

Wie vielen Dank dass Du mich ins "Penner Quartett" steckst,SweetOhm schrieb:Meiner einer und das "Penner" Quartett haben allerdings "günstig" eingekauft und sindglücklich damit !

Ich weiß, Du und der Rest der Welt können (dürfen/wollen) das nicht glauben/wahr haben ...

Auch ich bin einer der 5 Hanseln. Meine aktuelle GPU ist eine RX 5500 XT. Davor hatte ich eine APU. Aber es gehört nun Mal auch dazu, zu erkennen und zu akzeptieren, dass die eigenen Ansichten von anderen nicht geteilt werden.

Danke für den Hinweis, ich sollte so spät keine Post mehr schreiben,SweetOhm schrieb:Lass mich raten, Du hattest den Prototypen vom VM Golf GTI ?!?

Bei mir hat es nur zum Polo gereicht. 75 PS war das höchste.

IIRC steht steht 4N für "for Nvidia".bensen schrieb:Ob der jetzt N4 oder 4N heißt ist reine Semantik.

Nvidia wird von TSMC so oder so eine Spezialsoße bekommen haben und keinen Standardprozess verwenden.

ArrakisSand

Lieutenant

- Registriert

- Dez. 2019

- Beiträge

- 984

Das größte Mysterium für mich, sind noch immer die +45% die anscheinend eine RX 9070XT

bei Raytracing in Resident Evil 4 verglichen mit einer RX 7900XTX erreichen soll.

Irgendwelche Ideen?

Da würde man gar vor einer RTX4090 liegen.

bei Raytracing in Resident Evil 4 verglichen mit einer RX 7900XTX erreichen soll.

Irgendwelche Ideen?

Da würde man gar vor einer RTX4090 liegen.

- Registriert

- Juli 2021

- Beiträge

- 1.272

Frank Azor hat gegenüber PCWorld auf die Frage, ob die Performance besser oder schlechter als die der Leaks ist, gesagt, sie wäre besser als [ kurzes Zögern] die meisten der Leaks von vor der CES die er kennt.ArrakisSand schrieb:Das größte Mysterium für mich, sind noch immer die +45% die anscheinend eine RX 9070XT

bei Raytracing in Resident Evil 4 verglichen mit einer RX 7900XTX erreichen soll.

Irgendwelche Ideen?

Den Post den Du zeigst ist vom November und schlug hohe Wellen. Gibt es Leaks die behaupten die RX 9070 XT wäre noch schneller? Meine Interpretation: Besser als die meisten, schlechter als dieses.

Zhang Zhong Hao postet normalerweise Infos über die Konfiguration zukünftiger Produkte. Da ist die Trefferquote Ok. D. h., aber nicht, dass Angaben von Zhang Zhong Hao zur Performance ebenso gut sind. Ich glaube nicht, dass jemand mit einem "Engineering" Treiber solche Werte gemessen hat. Bestenfalls hat jemand die Messwerte "hochgerechnet", schlimmstenfalls sich aus den Fingern gesaugt

Alle Angaben besagen, dass Navi 48 über 64 CUs hat. Die Fläche die David Huang aus den Fotos ermittelt hat, ist ca 390 mm². Das sind ca 20 % mehr als es aufgrund der Werte von Navi 32 + 4 CUs zu erwarten wäre. Und 60 % mehr als die "Leaks" vom April behauptet haben.

Die Frage ist, was hat AMD mit diese 20 % zusätzlicher Fläche gemacht?

Frank Azor hat zur PCWorld folgendes gesagt:

Die Raytracing Performance ist immer mehr Leuten wichtig. Also bekommt die Raytracing Performance als Auswahlkriterium das gleiche Gewicht wie die Rasterization Performance. AMD muss die Lücke zu Nvidia schließen. Wir werden sehen in wie weit das funktioniert.you're gonna see a little bit improvement in rasterization, as you would expect. You're going to see a lot of improvement in ray tracing, and you're going to see an enormous amount of improvement in AI compute capability.

Die AI Compute Performance wird für FSR 4 benötigt. Hier bin ich darauf gespannt was AMD genau gemacht hat.

Caramelito

Admiral

- Registriert

- Juni 2016

- Beiträge

- 9.100

Das ist vollkommen OK, aber +45% in RE? Dann wäre man bei ca. 193 fps aus dem Screenshot vs 173 einer 4090. Das kann ich mir halt bei bestem Willen nicht vorstellen.ETI1120 schrieb:Frank Azor hat gegenüber PCWorld auf die Frage, ob die Performance besser oder schlechter als die der Leaks ist, gesagt, sie wäre besser als [ kurzes Zögern] die meisten der Leaks von vor der CES die er kennt.

Muss auch so eine AI Geschichte sein.. 9070xt + FSR 4 vs. Rest oder so.. dann natürlich 45% ggü XTX

Ergänzung ()

ArrakisSand schrieb:Da würde man gar vor einer RTX4090 liegen.

Anhang anzeigen 1569048

^

Ich mir auch nicht, siehe bitte den 2. und 3. Absatz meines Posts den Du zitierst.Caramelito schrieb:Das ist vollkommen OK, aber +45% in RE? Dann wäre man bei ca. 193 fps aus dem Screenshot vs 173 einer 4090. Das kann ich mir halt bei bestem Willen nicht vorstellen.

Ich habe eine ganze Weile gebraucht, bis ich kapiert habe, dass es der Leak von Ende November ist, den ich beschlossen hatte zu ignorieren.

Was auch immer, es ist zu schön um wahr zu sein.Caramelito schrieb:Muss auch so eine AI Geschichte sein.. 9070xt + FSR 4 vs. Rest oder so.. dann natürlich 45% ggü XTX

Inxession

Captain

- Registriert

- Sep. 2008

- Beiträge

- 3.681

Vigilant schrieb:Na ja, Nvidia ist primär groß durch ihre Server-KI-Hardware.

Groß geworden durch GPUs.

Mittlerweile ist AI/KI die CashCow.

Vigilant schrieb:Dann waren sie anscheinend auch nicht wirklich konkurrenzfähig, oder?

Mittelklasse - Blindtest.

Bin mir sicher dass niemand einen Unterschied feststellen würde, wenn man die nVidia GPU in der Gaming Pause durch eine AMD Karte ersetzt.

Klar gibts Nischen - RT, etc.

Aber rein im gleichen Leistungsspektrum sind AMD Karten absolut solide, konkurrenzfähig und immer eine Alternative. Wenn nicht sogar die bessere (P/L).

Hier greift aber das Marketing von nV und im Media Markt bekommt man nur Team Grün empfohlen.

Lumi25 schrieb:Generell sind die Aussagen ja richtig aber ich Frage mich immer noch welchen Mehrwert die RX 9070 (ich meine nicht die XT-Variante) gegenüber der RX 7800 XT bietet?

Es gab ja mal die Vermutung dass bei RDNA3 ein Hardwarefehler vorliegt und höhere Takte dadurch nicht möglich waren. RDNA4 taktet vermutlich höher.

Daher auch die Leistungssteigerung bei nahezu identischer Konfiguration.

Was allerdings auch erhöhten Energieverbrauch nach sich zieht.

ETI1120 schrieb:Mal eine Frage, wie hat AMD Intel im CPU Markt gepackt?

In dem sie im High End angegriffen haben.

Ja, aber auch nur weil Intel geschlafen hat.

Intel hat jahrelang mit minimalen Schritten, den Kunden gemolken und war, komischerweise, nicht mal vorbereitet auf ein wieder erstarktes AMD.

nVidia schläft nicht wie Intel damals.

nVidia treibt sich jederzeit selbst an.

Vermutlich wird nVidia aber auch bei fehlender High End Konkurrenz, hier und da mal etwas "schläfriger" agieren in ferner Zukunft.

Und/Oder die HighEnd Preise werden irgendwann noch teuerer und die Kunden sind nicht mehr bereit die Preise mit zu gehen (bei mir jetzt schon der Fall - > 1000 € ... nie im Leben für eine GPU)

ETI1120 schrieb:Eigentlich ist das Problem ganz einfach: Nvidia hat den Grafikkartenmarkt komplett im Griff.

Aber auch NUR, so lange die Kundschaft fleißig nVidia kauft.

Alleine auf den GPU Sektor bezogen könnten viele in der Mittelklasse auch mit einer AMD Karte "ihren" Spaß haben. Ohne nennenswerte Einbußen/Unterschiede.

nVidia verdient mittlerweile im AI/KI Markt.

Aber GeForce hat das Unternehmen groß gemacht.

Mit nahezu perfektem Marketing. Sehr guter Hardware.

Aber auch mit umstrittenen NDA Richtlinen die "schlechte Bewertungen" für nVidia Produkte nahezu auf NULL gebracht haben.

So in der Art ... bewertet Ihr uns schlecht, bekommt ihr beim nächsten Mal kein Testmuster.

Machenschaften die grenzwertig sind, sicherlich nicht nur nV so handhabt, aber die Hardware stellenweise auch in besserem Licht dastehen lassen gegenüber der meist günstigeren und genau so guten Konkurrenz.

Absolut, bin ich bei dir.Inxession schrieb:Mittelklasse - Blindtest.

Bin mir sicher dass niemand einen Unterschied feststellen würde, wenn man die nVidia GPU in der Gaming Pause durch eine AMD Karte ersetzt.

Klar gibts Nischen - RT, etc.

Aber rein im gleichen Leistungsspektrum sind AMD Karten absolut solide, konkurrenzfähig und immer eine Alternative. Wenn nicht sogar die bessere (P/L).

Allerdings, und das lässt sich meiner bescheidenen Meinung nach nicht ausblenden, ist RT nicht mehr Nische. Hinzu kommt die Leistungsfähigkeit bei AI-Anwendungen, bessere Effizienz und das bisher bessere DLSS gegenüber FSR.

In allen Punkten wird AMD mit RDNA4 hoffentlich aufholen, um zumindest in den entsprechenden Leistungsklassen zu Nvidia aufzuschließen.

Zuletzt bearbeitet:

N1truX

Lt. Junior Grade

- Registriert

- Mai 2012

- Beiträge

- 264

Ganz ehrlich: Ich finde AMDs Weg symphytisch und werde ihn auch gerne unterstützen, sollten da gute Mittelklasse-Karten bei herumkommen.

Weder werde ich über 1.000 Euro für eine High-End-GPU ausgeben, noch sehe ich es ein 300+ Watt beim Zocken zu verbraten - nur für die GPU. Einfach mal wieder 150-200 W bei ab Werk hoher Effizienz, nicht erst durch reduzierte Power-Targets, weil AMD und Nvidia der Meinung sind, 7 % mehr Leistung mit 35 % mehr Verbrauch zu erkaufen.

Weder werde ich über 1.000 Euro für eine High-End-GPU ausgeben, noch sehe ich es ein 300+ Watt beim Zocken zu verbraten - nur für die GPU. Einfach mal wieder 150-200 W bei ab Werk hoher Effizienz, nicht erst durch reduzierte Power-Targets, weil AMD und Nvidia der Meinung sind, 7 % mehr Leistung mit 35 % mehr Verbrauch zu erkaufen.

Tornavida

Banned

- Registriert

- Okt. 2020

- Beiträge

- 6.298

Ich glaub es zwar nicht, also wenn AMD so eine Leistung hin bekommt, dass sie es dann für die Hälfte anbieten würden, aber ich will dir die Illusion nicht nehmen und gönne dir.SweetOhm schrieb:Yup, mit 4080/Super Leistung zum "halben" Preis.

Der NV 60´er "Krüppel" wird in der selben Preisliga spielen ...

Limonadenmann

Cadet 4th Year

- Registriert

- Jan. 2025

- Beiträge

- 92

- Registriert

- Okt. 2012

- Beiträge

- 7.456

Das ist dann noch ohne PT wenn ich das richtig sehe.Edelgamer schrieb:

Slowz

Lt. Commander

- Registriert

- Nov. 2011

- Beiträge

- 1.216

Für mich persönlich ist es sehr schade, dass AMD aus dem High-End Bereich aussteigt. Dadurch hat Nvidia hier im Grunde kaum ein Limit bzgl. Preisgestaltung. Aber grundsätzlich wird das wohl der richtige Weg für AMD sein. In einer der Grafiken aus der CB-Umfrage ist ja klar ersichtlich, dass der Marktanteil von AMD stetig steigt. Mal schauen ob und wie Nvidia in Zukunft wieder im Mittelfeld aktiver wird.

Ähnliche Themen

- Antworten

- 105

- Aufrufe

- 12.316

- Antworten

- 176

- Aufrufe

- 18.659

- Antworten

- 141

- Aufrufe

- 12.856

- Antworten

- 1.241

- Aufrufe

- 113.400

- Antworten

- 246

- Aufrufe

- 26.110