Dr.Pawel

Lt. Commander

- Registriert

- Nov. 2007

- Beiträge

- 1.769

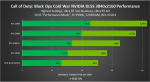

Was glaube viele verstehen nicht warum hier so "niedrige" CPU Anforderungen gestellt werden. Natürlich reichen die genannten CPUs auch um eine 3080 in 1080p zu befeuern, halt für (geraten) 45-60 FPS! Ohne irgendeine Aussage zur Bildrate völlig unsinnig!

MMn sind die Angaben weniger Wert als das Papier auf dem sie stehen und wurden wahrscheinlich ganz bewusst so gestellt um die Anforderungen möglichst niedrig aussehen zu lassen. Sry aber ich glaube einfach noch nicht dass das am Ende so stehen bleibt für halbwegs stimmige FPS. Natürlich lasse ich mich da gerne eines besseren belehren.

MMn sind die Angaben weniger Wert als das Papier auf dem sie stehen und wurden wahrscheinlich ganz bewusst so gestellt um die Anforderungen möglichst niedrig aussehen zu lassen. Sry aber ich glaube einfach noch nicht dass das am Ende so stehen bleibt für halbwegs stimmige FPS. Natürlich lasse ich mich da gerne eines besseren belehren.