Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Test Intel Core Ultra 200S im Test: Core Ultra 9 285K, 7 265K & 5 245K enttäuschen effizient

boika

Lt. Junior Grade

- Registriert

- Okt. 2019

- Beiträge

- 385

Die Gamer schalten die ganzen Intel E-Kerne im Bios aus, weil diese Freezes verursachen

oder wurde das schon gefixt ? Bitte klärt mich auf

AMD wurde hier schon so oft beerdigt und nun hat AMD die Nase vorne,

ich kaufe mir momentan keine neue CPU,s weil ich ständig im GPU Limit bin RTX 3090

Ich will aber Intel, weil ich AMD noch nie gekauft habe

oder wurde das schon gefixt ? Bitte klärt mich auf

AMD wurde hier schon so oft beerdigt und nun hat AMD die Nase vorne,

ich kaufe mir momentan keine neue CPU,s weil ich ständig im GPU Limit bin RTX 3090

Ich will aber Intel, weil ich AMD noch nie gekauft habe

K3ks

Fleet Admiral

- Registriert

- Nov. 2007

- Beiträge

- 10.526

Ahhja, wir hamn 2024, da hab ich fast verdrängt dass Desktops mindestens. privat, vermutlich generell fast überall, am sterben sind.cruscz schrieb:Leute, die das nicht wissen, kaufen heute keinen Desktopcomputer mehr, bzw. nur ein Bruchteil dieser.

daknoll schrieb:Mister Offtopic

Wie dem auch sei, die Preise, Stromverbrauch, Leistung, Tests usw. sind bestimmt im Netz zu finden.

Balikon schrieb:Nur, weil der Bulldozer DIR gereicht hat, war es noch lange kein guter Prozessor.

E:

Lese ich das erste mal von, klingt also nach einer Ente. 🤷boika schrieb:Die Gamer schalten die ganzen Intel E-Kerne im Bios aus, weil diese Freezes verursachen

oder wurde das schon gefixt ? Bitte klärt mich auf

Naru

Lt. Commander

- Registriert

- Juli 2010

- Beiträge

- 2.030

Mich irritieren die Temperaturangaben bei den AMD-CPUs? Hat ComputerBase berücksichtigt, dass Tdie nicht gleich Tcore entspricht?

Die ähnliche bzw. gleiche Leistung in Relation zur vorherigen Iteration auf den Niveau von AMDs Power-Consumption zu bekommen, ist jedenfalls eine nicht zu verachtende Leistungssteigerung. Aber der Großteil der Anwender zieht einzig die teils zu niedrige Gaming-Performance zurate.

Doch selbst dann, wenn ich mir heutig ein neues System zusammenstelle, würde ich mir für wenig Geld ein gebrauchtes Matisse-System zusammenstellen wollen; wie gut diese Iteration performt, zeigt das entsprechende 3D-Derivat in diesem Test.

Die ähnliche bzw. gleiche Leistung in Relation zur vorherigen Iteration auf den Niveau von AMDs Power-Consumption zu bekommen, ist jedenfalls eine nicht zu verachtende Leistungssteigerung. Aber der Großteil der Anwender zieht einzig die teils zu niedrige Gaming-Performance zurate.

Doch selbst dann, wenn ich mir heutig ein neues System zusammenstelle, würde ich mir für wenig Geld ein gebrauchtes Matisse-System zusammenstellen wollen; wie gut diese Iteration performt, zeigt das entsprechende 3D-Derivat in diesem Test.

Zuletzt bearbeitet:

Kalsarikännit

Commander Pro

- Registriert

- Aug. 2012

- Beiträge

- 2.297

Mit Verlaub, da ist die Aussage eines jeden einzelnen der Sätze absolut gewagt.Dome87 schrieb:Einfach alles. Beim Tippen z.B. ist ein moderner PC quasi im IDLE. Abgesehen davon zeigt der IDLE-Verbrauch auch die Effizienz im niedrigen Teillastbereich an. Also das Öffnen von Apps, bei Downloads, beim Installieren von Spiele-Updates und und und.

Zuletzt bearbeitet:

Ruff_Ryders88

Rear Admiral

- Registriert

- Jan. 2008

- Beiträge

- 5.475

War irgendwie auch meine erste Assoziation. Aber ich glaub Bulldozer war nochmal ein ganz anderer Fail.Sherman789 schrieb:Intels Bulldozer-Moment.

Sehr sehr schade. ☹️ Danke für den Test.

Tharan

Lieutenant

- Registriert

- Sep. 2007

- Beiträge

- 997

ElliotAlderson schrieb:Und? Hat auch niemanden gejuckt, als AMD dank TSMC die Nase vorn hatte. Die Lorbeeren dafür bekam AMD.

Bei RDNA2 gegen Ampere war auch nichts wichtiger als die Effizienz und jetzt will man davon nichts mehr wissen. Hier wird sich gewindet wie ein Aal.

Hier wird sich nirgends gewindet. Der Sprung von Intel ist halt nur nich so groß, wie du ihn machst. Und er ist eben nicht auf die Leistung von Intels Architektur zuzuschreiben. Aber er ist trotzdem da und das Produkt ist eben auch immer durch die Fertigung beeinflusst, was weiterhin die Stellung von TSMC festigt.

Weder deine Darstellung stellt das ins richtige Licht, noch ist es richig das nun klein zu schreiben was trotzdem da ist.

Und der letzte Punkt lässt mich eigentlich schon zweifeln: Lässt du mit einem neuen PC nur Cinebench im Kreis laufen oder lässt du ihn auch auf "echte" Aufgaben los? Und da sieht man eben wie zuvor angesprochen das Potenzial was noch fehlt: Auf die Straße muss es Intel halt bringen und nicht instabil hier und da mal Leistung bringen oder nicht.

Pisaro

Fleet Admiral

- Registriert

- Aug. 2007

- Beiträge

- 15.668

Ändert halt dennoch nichts an der Tatsache das Bulldozer im Vergleich zur Konkurrenz Müll war.daknoll schrieb:Dieser Abfall hat mich fast 5 Jahre treu begleitet und alle meine Games für mich absolut zufriedenstellend dargestellt.

Es gibt auch positive Ausreißer. Der8auer hat zwar mit RAM OC getesetet, aber dort ist der 285K in mehreren Games schneller als ein 7800X3D.matmartin schrieb:Diese negativen Ausreißer sind schon bemerkenswert.

Die Ausreißer sind allgemein groß, legt zumindest den Verdacht nahe, dass die CPU in manchen Szenarien noch nicht so arbeitet wie vorgesehen.

Die Idle Effizienz ist schlechter als vorher, 13. Gen und 14. Gen kamen noch ein paar Watt niedriger.RushSyks schrieb:Leistungsmäßig kein Kracher, aber die Idle Effizienz ist eine Ansage.

Schuldig ist wahrscheinlich der komplexe Aufbau aus den verschiedenen Tiles.

Trotzdem weiterhin besser als AMD.

Wurde vor allem früher oft erwähnt:scotch.ofp schrieb:Wer braucht idle Effizienz?

Intel Fans denen es wichtiger ist beim nix tun wenig zu verbrauchen.

Unter Last ist der Verbrauch dann plötzlich wieder unwichtig gewesen.

Nur im groben Gamingdurchschnitt. Man sollte so fair sein, dass der 5800X3D nur einen Teil des Gamingbereichs gut bedienen kann.Holzinternet schrieb:Mein 5800X3D ist nicht schlechter als die neuste Intel CPU.

In allen anderen Situationen ist der 285K massiv stärker. Leistung pro Kern, MultiCore "Arbeit", Verbrauch bei keine bzw. geringer Last, RAM OC und auch ein paar Games.

Naja Office, Videos/Filme, Streaming und andere Kleinigkeiten belasten die CPU so wenig, dass man sehr nahe am nix tun ist. Ein Punkt in dem Intel es besser schafft mit dem Verbrauch niedrig zu bleiben und zu halten.Kalsarikännit schrieb:was hat das mit IDLE zu tun?

Mein eigener Senf:

Sehr gut bis sehr schlecht. Es ist alles dabei.

Gaming ist out of the Box leider nur guter Durchschnitt. Ein paar Tests zeigen aber was möglich ist.

Mit dieser CPU kann man alles ohne Probleme zocken, aber man erwartet von der neuen teuren Top CPU nun mal etwas mehr.

Anwendungen also MultiCore Szenarien sind stark, die CPU schlägt sich gut mit dem 9950X.

Auch wenn es mehr Kerne sind, schafft es Intel mit weniger (24 zu 32) Threads mitzuhalten.

Die stark schwankende Leistung und der "zusätzliche" Strom der über die 24pin 12V läuft und nicht mit gemessen wurde sind ein Problem. Es gibt einige Baustellen die nicht optimal laufen.

Auch Windows scheint für Intel dieses mal eine deutliche Baustelle zu sein.

Auch wenn vieles enttäuscht, finde ich dass Intel eine gute Basis gelegt hat.

Zuletzt bearbeitet:

Pisaro

Fleet Admiral

- Registriert

- Aug. 2007

- Beiträge

- 15.668

Das ergibt mal richtig wenig Sinn. Was ist das für eine Logik?boika schrieb:Ich will aber Intel, weil ich AMD noch nie gekauft habe

- Registriert

- Juli 2021

- Beiträge

- 2.930

Die Aussage ist nicht nur gewagt, diese Aussage ist falsch.Kalsarikännit schrieb:Mit Verlaub, da ist die Aussage jeder einzelner der Sätze absolut gewagt.

Sobald man etwas tippt, scrollt und Co, sieht man bei jeder CPU, wie der Takt noch oben schnellt und man wieder in die Power-Stages kommt.

Bei Idle, ist es in der Regel so, dass die Kerne bereits in die ersten C-Stages wechseln, was sich auch gerne mal dadurch bemerkbar macht, dass das System etwas "länger" braucht, um zu reagieren, auch wenn es fast nicht zu merken ist.

CadillacFan77

Lt. Commander

- Registriert

- Feb. 2005

- Beiträge

- 1.073

Korrekt, Idle gibts eigentlich so nicht in der Realität. Schliesslich hat man seltenst ein frisch installiertes, ohne Hintergrunddienste und aufgeräumtes Windows vor sich.

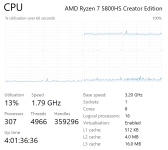

Auch "Office" ist nicht nix, anbei aktuell die Auslastung bei mir (wobei der Peak von 13% wegen dem Screenshot ist - vorher zwischen 3 und 7%). Offen ist nur FF mit 13 Tabs, Outlook, Teams, PDF und RemoteApps. Alle inaktiv sozusagen.

Also viel weniger geht nicht im "Office Betrieb". Wenn ich wirklich "arbeite", d.h. nicht nur im Browser bin sind's schnell mal 15-25% Auslastung. Und das ist ein 8C/16T.

Auch "Office" ist nicht nix, anbei aktuell die Auslastung bei mir (wobei der Peak von 13% wegen dem Screenshot ist - vorher zwischen 3 und 7%). Offen ist nur FF mit 13 Tabs, Outlook, Teams, PDF und RemoteApps. Alle inaktiv sozusagen.

Also viel weniger geht nicht im "Office Betrieb". Wenn ich wirklich "arbeite", d.h. nicht nur im Browser bin sind's schnell mal 15-25% Auslastung. Und das ist ein 8C/16T.

Anhänge

Naru

Lt. Commander

- Registriert

- Juli 2010

- Beiträge

- 2.030

GECKO82 schrieb:Schade

Moment zum Geldsparen. Würdige Games (natürlich allesamt Shooter) kommen sowieso bloß noch für die Konsolen auf den Markt. Und Black Ops, das nun in die nächste Runde gehen soll, ist sowieso der reinste Trash.

Ergänzung ()

CadillacFan77 schrieb:Korrekt, Idle gibts eigentlich so nicht in der Realität. Schliesslich hat man seltenst ein frisch installiertes, ohne Hintergrunddienste und aufgeräumtes Windows vor sich.

Das ist etwas, was viele der Leser und vielleicht auch der Tester/ Reviewer zu selten in Betracht ziehen.

Man brauche nur mal SSD-Benchmarks ausführen zu lassen und die Resultate vergleichen mit denjenigen, die in dem Abgesicherten Modus von Windows erzeugt wurden. Die Diskrepoanz kann enorm ausfallen.

Zuletzt bearbeitet:

Leitwolf22

Lt. Junior Grade

- Registriert

- Juni 2008

- Beiträge

- 269

Sehen wir's doch positiv: wenn das alles ist, was man aus den 3nm von TSMC rausholt, dann kann die Intel Fertigung soooo schlecht gar nicht sein.

Es ging dabei um den Vergleich zu anderen Produkten zu der Zeit. Habe ja nicht behauptet, dass Bulldozer nicht funktionsfähig war. Na klar konnte man damit "alles machen".daknoll schrieb:Gezielt herabwürdigender Unsinn, den du da absonderst. Dieser Abfall hat mich fast 5 Jahre treu begleitet und alle meine Games für mich absolut zufriedenstellend dargestellt. Und für meine Foto RAW Bearbeitung war er auch mehr als schnell genug.

@Kalsarikännit

Du darfst gerne belegen, dass ich Quatsch erzähle. Ich verweise an der Stelle gerne an sämtliche Videos von Cracky (Rawiioli) auf YouTube, der grundsätzlich bei jedem Hardware-Content nebenbei den Stromverbrauch an der Steckdose mißt. Und zwar bei reeller Nutzung eines PCs. Einfach mal die letzen 30 Videos anschauen und selbst vergleichen. Und das ist nur eine Quelle meiner Behauptung.

Zuletzt bearbeitet:

ThirdLife

Captain

- Registriert

- Aug. 2019

- Beiträge

- 3.262

Wenn die CPUs dann bei 64 Kernen sind sollen sie also gratis sein ?ElliotAlderson schrieb:Wenn wir also irgendwann bei 64 Kerne sind, darf die CPU ruhig mehrere tausend Euro kosten?

Was ein Schwachsinn...

Hast du mir nicht gerade Extreme vorgeworfen ?

Fakt ist: obwohl jeder mosert sind die neuen Highend-CPUs die billigsten ever im AMD Lineup, der Preis ging konstant runter.

Woher kommt diese Erwartungshaltung dass man immer mehr für immer weniger bekommen müsse ? Ein VW Golf heute kann mehr und kostet auch mehr als 1980. Müsstest du da nicht immer mehr für immer weniger kriegen ?

Elliot beim Gespräch mit seinem Chef:

E: ich hab grad ne Schulung gemacht und kann viel mehr als noch vor drei Jahren. Ich hätte gerne statt 40k€ Jahreslohn gern 45k€.

Cheffe: UND WENN WIR IRGENDWANN BEI FÜNF SCHULUNGEN SIND WILLST DU MILLIONEN???!!!11elf

Elliot Logic. Gotta love it.

Ja und irgendwann werden Sie aufwachen wie die hardliner hierLosti73 schrieb:Der Mainstream wird sich nicht auskennen,

Keine Tests lesen und sich denken ,

Neuer ist schneller 😁

Ergänzung ()

Es liegt nicht an der Fertigung.Leitwolf22 schrieb:Sehen wir's doch positiv: wenn das alles ist, was man aus den 3nm von TSMC rausholt, dann kann die Intel Fertigung soooo schlecht gar nicht sein.

ElliotAlderson

Lieutenant

- Registriert

- Juni 2024

- Beiträge

- 1.004

Hab ich das gesagt? Wenn ja, zitiere es mal.ThirdLife schrieb:Wenn die CPUs dann bei 64 Kernen sind sollen sie also gratis sein ?

Ja und auch hier argumentierst du wieder mit Extremen (gratis).ThirdLife schrieb:Hast du mir nicht gerade Extreme vorgeworfen ?

Nope, das ist falsch. Der FX 8350 hat z.B. $199 gekostet. Der 2700x kostete $360 und der 1800X lag bei $499.ThirdLife schrieb:Fakt ist: obwohl jeder mosert sind die neuen Highend-CPUs die billigsten ever im AMD Lineup, der Preis ging konstant runter.

Nichts an deiner Aussage stimmt auch nur im entferntesten.

Laut deiner Logik hätte der 2700x auch mehr kosten müssen, den er bot ja mehr, hat er aber nicht. Woran liegt das wohl?

Ich weiß auch nicht, wieso man sich solch einen Cache-Krüppel zulegt, bei dem nur die Hälfte der Kerne vom Cache profitieren. Das mag aktuell noch gut gehen, aber sobald ein Spiel mehr als 8 Kerne auslastet, gehts genau so bergab wie bei dem 7900X3D.

Ich weiß nicht? Könnte es daran liegen, dass mit besseren und optimierten Fertigungstechniken die Preise in der Vergangenheit gesunken sind? Neeeein, das ist es sicher nichtThirdLife schrieb:Woher kommt diese Erwartungshaltung dass man immer mehr für immer weniger bekommen müsse ? Ein VW Golf heute kann mehr und kostet auch mehr als 1980. Müsstest du da nicht immer mehr für immer weniger kriegen ?

Wie kommts, dass der FX 8350 weniger kostete als fast alle Single Core CPUs vor 25 Jahren?

Nach deiner Logik müsste mehr ja auch teurer bedeuten und wenn dem so wäre, würden CPUs heute 5-6 stellig kosten.

Eine CPU wird nicht nach Kernen bepreist, sondern u.a. nach Yield und Fläche. Die Anzahl der Kerne sagt erstmal gar nichts über die Kosten aus. Sowas solltest du als "System Engineer" wissen oder entspricht das etwa nicht der Wahrheit?

Zu diesem hinkenden Vergleich sag ich besser mal nichts.ThirdLife schrieb:E: ich hab grad ne Schulung gemacht und kann viel mehr als noch vor drei Jahren. Ich hätte gerne statt 40k€ Jahreslohn gern 45k€.

Cheffe: UND WENN WIR IRGENDWANN BEI FÜNF SCHULUNGEN SIND WILLST DU MILLIONEN???!!!11elf

Elliot Logic. Gotta love it.

Zuletzt bearbeitet:

Ähnliche Themen

- Antworten

- 45

- Aufrufe

- 3.446

- Antworten

- 23

- Aufrufe

- 2.005

- Antworten

- 11

- Aufrufe

- 1.279

- Antworten

- 94

- Aufrufe

- 10.105

- Antworten

- 358

- Aufrufe

- 30.177