Quidproquo77 schrieb:

Ich greife dich nicht persönlich an,

Naja du hast schon recht oft einen gewissen Unterton, der mitschwingt wenn du meine Beiträge kommentierst.

Quidproquo77 schrieb:

Und ich mache dich auch gerne nochmal darauf aufmerksam, dass dir die V-ram Menge, wenn es um Nvidia Karten geht sehr wichtig ist, bei AMD Karten, wo es schlechter mit der V-ram Verwaltung läuft keine Erwähnung wert ist. Was verrät uns dies? Das lasse ich an dieser Stelle offen.

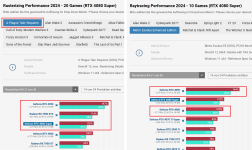

Richtig, ich kritisiere recht oft Nvidias VRAM Geiz in der 700-1000€ Klasse (4070 und 4070ti bei Release), weil es einfach bewusst beschnitten ist und trotzdem so viel Geld dafür genommen wird. Dazu kommt, dass diese Karten auch für WQHD+ und die 70ti auch eher auch mal für 4K gekauft werden und es hier recht übereinstimmend, von vielen HW Techsites bewiesen, zu Einschränkungen kommen kann. Schon quasi bei Neukauf.

Und ja, 12 und 16GB gab es bei AMD eben schon bei der 6700xt und 6800(XT) für 350€ bis 500/600€. Das ist ausgewogen und passt auch für die Zukunft noch recht gut.

Dass AMD mit ihrer Speicherverwaltung nicht ganz an NVs Speicherverwaltung rankommt ist mit sehr gut bewusst, jedoch auch nicht so gravierend besser.

Wenn NV 11GB braucht, braucht AMD eben 12-13GB, wenns viel ist.

Das macht den Kohl aber net fett. Dafür gibt's halt 4GB mehr bei AMD.

Aber wenn ein HUB Test eine damals ähnlich schnelle und preislich ähnlich platzierte 3070 mit 8GB 2 Jahre nach Release gegen eine 16GB RX6800 antreten lässt, und die RTX dann sogar in den RT Parade Settings deutlich gegen die 16GB AMD Karte abstinkt, dann gibt mir meine Kritik eindeutig Recht, dass NV an falscher Stelle spart. Die RTX Karte müsste deutlich vor der RX6800 liegen. Tat sie im Test aber selten.

Die 6800 16GB kannst heute noch empfehlen, eine 3070 8GB nicht mehr.

Und 4GB Vram kosten vll 20-30€ mehr. Dann muss man die Karten eben sinvoller designen. AMD schafft diese Abstufung beim SI und Vram ja auch. Selbst im Notebook Bereich.

Und auch bei dieser Meinung bleibe ich, die 4070S ist mit knapp 600-700€ zu teuer für 12GB. Auch wenn sie sonst eine tolle Karte ist.

Die 4070ti S ist endlich eine Runde Karte mit der man bedenkenlos alles machen kann. Diese Karte hätte zu Release so veröffentlicht werden sollen, NV hat aber erstmal die 12GB Sparvariante für knapp um 1000€ verkauft.

Und sowas kritisiere ich, ja.

So, habe fertig.