pacifico schrieb:

Das was du da ermitteln willst, haben Nvidia und AMD bereits erledigt.

Die Kennzahl nennt sich TDP und wird von beiden Herstellern angegeben.

Easy oder,?

Nein, nicht easy.

Bei deiner "

30 Prozent Mehrleistung mit ca 45 Prozent höherer Stromaufnahme" gehst du seltsamerweise davon aus, dass bei Spielen mit weniger Mehrleistungsunterschied (durch Flaschenhälse wie z.B. CPU) der Stromaufnahmeunterschied gleichbleibt und sich nicht auch verringert.

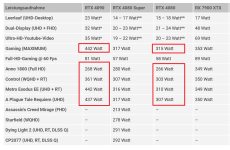

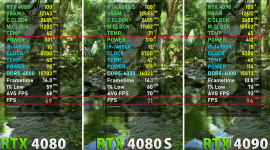

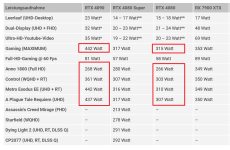

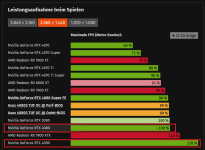

Tatsächlich verringert sich der Stromaufname-Unterschied bei "Gaming-Maximum" von 40,3% (442/315 - 1) bzw. bei "A Plague Tale: Requiem" in UHD von 42,3% (431/307 - 1) und bei Metro Exodus EE in UHD und mit Raytracing von 42,6% (442/310) auf nur noch 19,1% bei Control (WQHD + RT) oder sogar nur noch

0,7% (268/266 -1) bei Anno 1800 in FullHD:

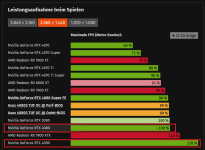

Auch bei den CB-Stromaufname-Tests verringern sich der Stromaufnahme-Unterschied bei "Metro Exodus (ohne EE)" von 37% in UHD auf nur noch 28% in WQHD oder sogar nur noch 10% in FullHD:

Du gehts aber stumpf von 45% in sämtlichen Auflösungen und im kompletten Spieleparcour aus, wenn du die Effizienz von der Durchschnittsperformance des kompletten Spiele-Mixes ableitest und bei den Stromaufnahme-Unterschieden nur die Extremfälle berücksichtigst.

Wir können ja spaßeshalber mal aus diesen 8 Stromaufnahme-Werten den Durchschnitt bilden: 140,3% + 142,3% + 142,6% + 119,1% + 100,7% + 137% + 128% + 110%) / 8 = 127,5%. Und je mehr Stromaufnahme-Werte man ergänzt, um so genauer wäre dann eine Effizienz-Betrachtung.

Ideal wäre natürlich, wenn bei sämtlichen von CB + PCGH getesteten Spielen auch die Stromaufnahme mitgetestet würde, aber das wäre natürlich ein Heidenaufwand.

Immerhin scheint PCGH weitere Titel hinzuzunehmen, um das Gesamtbild abzurunden (AC Mirage, Starfield, Dying Light 2, Cyberpunk 2077).