- Registriert

- Aug. 2010

- Beiträge

- 39.997

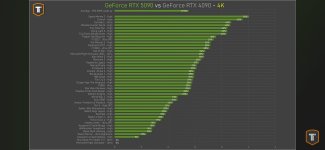

Bisschen ernüchternd ist das ja schon, dass der Zuwachs bei der Rohleistung so gering ist und es keinen Shrink für die Effizienzsteigerung gibt. Aber hat sich ja neulich schon in dem einem Video von Der Bauer angedeutet. Diese Karte sollte besser eine 4090TI sein.

Zudem sind die Speichertemperaturen ein Nogo, vorallem bei diesem aufwändigen Kühler und sie es bei der GPU ja hinbekommen. Im Sommer dann 100°C auf dem Speicher vermutlich überschritten. @Wolfgang: Könnt ihr die Graka mal öffnen und prüfen, ob man das verbessern kann? Also wie bei der 3090 weitere Pads hinzufügen oder evl. minderwertige Pads durch hochwertige oder hochwertiges Putty ersetzen. Andernfalls kann man dann wieder nur Custom kaufen, wenn man keine Angst haben will, dass die Graka schlechend den Speichertod stirbt.

Und auch ziemlich schäbig, dass man kein Multiframegen (MFG) auf der 4000-Serie bekommt. Der mistige DX12-Wrapper von Witcher 3 frisst auch Leistung. Nativ kommen auf meiner 4080 etwa 50-60FPS raus, auf 1440P mit fast allem auf Max, außer Unschärfezeugs und Vignette etc. Mit Framegen sind es 80 bis 100 etwa (und ggf. nun leicht mehr durch die Optimierung) und mit DLSS Qualität 100-150 im Dreh. DLSS Qualität macht das Bild aber schon schlechter. (Bei Demo 401, Titanic HG finde ich DLSS besser umgesetzt. Dies ist ein Unreal-Engine-Programm.) Und Artefakte bei Witcher 3 durch Framegen sind kein Problem mehr für mich, da hilft es, die unnötigen Unschärfesachen abzuschalten. Und wenn Nvidia dann auch mal bei meiner Karte das Multiframegen geben würden, könnte ich dann quasi ohne DLSS-Nutzung wohl nahezu die 260Hz meines Monitors ausnutzen (per Treiber/Nvidia-App hinzugefügt). Und nach meiner Logik wird ggf. schlechtere Latenz wieder bisschen abgemildert, weil der Monitor dann bei 260Hz selbst weniger Inputlag hat als bei geringerer Frequenz.

Der mistige DX12-Wrapper von Witcher 3 frisst auch Leistung. Nativ kommen auf meiner 4080 etwa 50-60FPS raus, auf 1440P mit fast allem auf Max, außer Unschärfezeugs und Vignette etc. Mit Framegen sind es 80 bis 100 etwa (und ggf. nun leicht mehr durch die Optimierung) und mit DLSS Qualität 100-150 im Dreh. DLSS Qualität macht das Bild aber schon schlechter. (Bei Demo 401, Titanic HG finde ich DLSS besser umgesetzt. Dies ist ein Unreal-Engine-Programm.) Und Artefakte bei Witcher 3 durch Framegen sind kein Problem mehr für mich, da hilft es, die unnötigen Unschärfesachen abzuschalten. Und wenn Nvidia dann auch mal bei meiner Karte das Multiframegen geben würden, könnte ich dann quasi ohne DLSS-Nutzung wohl nahezu die 260Hz meines Monitors ausnutzen (per Treiber/Nvidia-App hinzugefügt). Und nach meiner Logik wird ggf. schlechtere Latenz wieder bisschen abgemildert, weil der Monitor dann bei 260Hz selbst weniger Inputlag hat als bei geringerer Frequenz.

Edit:

5090 -> 4090TI

5080 -> 4080TI

5080TI (die Graka mit 24GB, die zwischen 5080 und 5090 fehlt) -> 4080TI Super oder 4085

Zudem sind die Speichertemperaturen ein Nogo, vorallem bei diesem aufwändigen Kühler und sie es bei der GPU ja hinbekommen. Im Sommer dann 100°C auf dem Speicher vermutlich überschritten. @Wolfgang: Könnt ihr die Graka mal öffnen und prüfen, ob man das verbessern kann? Also wie bei der 3090 weitere Pads hinzufügen oder evl. minderwertige Pads durch hochwertige oder hochwertiges Putty ersetzen. Andernfalls kann man dann wieder nur Custom kaufen, wenn man keine Angst haben will, dass die Graka schlechend den Speichertod stirbt.

Und auch ziemlich schäbig, dass man kein Multiframegen (MFG) auf der 4000-Serie bekommt.

Edit:

5090 -> 4090TI

5080 -> 4080TI

5080TI (die Graka mit 24GB, die zwischen 5080 und 5090 fehlt) -> 4080TI Super oder 4085