roterhund07 schrieb:

Das ist eine DRAM less SSD, also eine ohne einen DRAM Cache in dem der Controller seine Verwaltungsdaten halten kann. Die sind lahm und je voller sie sind, umso lahmer werden sie! Das liegt daran das die Controller die Mappingtabelle also den Flash Translation Layer (FTL) und eben nicht Userdaten im DRAM Cache ablegen, also die Information wo die Daten im NAND stehen und wo NAND frei ist um dort schreiben zu können. Die ohne DRAM Cache halten dann immer einen kleinen Teil der Mappingtabelle im interen SRAM des Controller, genug um gut in den Benchmarks abzuschneiden die ja nur über ein oder weniger GB Adressraum benchen und daher tolle Werte ins Datenblatt schreiben zu können. Aber im Alltag muss der Controller dann ständig erstmal wieder den passenden Teil aus dem NAND nachladen, was eben viel länger als ein DRAM Zugriff dauert. Je voller die SSD ist, umso kleiner ist der Teil der Mappingtabelle der ins interne SRAM passt und umso wahrscheinlicher muss der passende Teil aus dem NAND nachgeladen werden.

wille1277 schrieb:

die Ergebnisse kommen mir verdächtig gering vor.

Die sind normal, auf der SSD dürften ja auch schon einige GB gespeichert sein. Fallt nicht immer auf die Werte im Datenblatt rein oder auf die billigen Reviews wo nur einfache Benchmarks auf leere SSD losgelassen werden, da sieht man nämlich nur tolle Werte und daher schicken die Hersteller solche Produkte dann bevorzugt nur an Reviewer die eben nur Tests machen bei denen der Markel nicht auffällt und sie trotzdem noch eine Auszeichnung abbekommen, mit der der Hersteller dann werben kann.

Die Intel 660p ist übrigens eine halbwegs DRAM less SSD, da deren Controller bei allen Kapazitäten nur 256MB DRAM als Cache hat, statt der üblichen und bei der sonst praktisch baugleichen Crucial P1 1GB DRAM pro 1TB Kapazität. Da passt natürlich ein größerer Teil der Mappingtabelle rein, aber eben auch nicht alles, schon gar nicht bei einer 2TB die recht voll ist. Dann ist bei QLC nicht nur die Schreib- sondern auch die Leseperformance im QLC Bereich geringer,

bei 4k QD1 Lesend sind es bei der 860 QVO nur 4.400 IOPS statt 7.500 aus dem Pseudo-SLC Bereich, QD32 werden im QLC sogar weniger als halb so viele IOPS lesend wie aus dem Pseudo-SLC erzielt. Anders als die 860 EVO und bei SSDs mit TLC üblich, hält die Crucial P1 die Daten aber extra lange in ihrem, bei leerem Laufwerk üppig dimensionierten Pseudo-SLC Schreibcache:

Die meisten Benchmarks messen daher nur die Performance des Pseudo-SLC Bereiches, was aber wenig praxisrelevant ist Die Intel 660p hat ja die gleichen NANDs und den gleichen Controller, dürfte es also auch so handhaben. Im

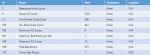

AnandTech Storage Bench - Light schafft die 660p voll nur auf 208,6MB/s, die Crucial P1 aber auf 250,1MB/s. Was immer etwas weniger ist als die MX500 schafft und im

AnandTech Storage Bench - Heavy sind es voll nur noch 158MB/s (die P1 152MB/s), die MX500 hat dann mit 235MB/s deutlich mehr. Seltsamerweise kann die P1 hier den Vorteil des größeren DRAM Caches nicht ausspielen, beide liegen aber deutlich unter dem Wert der MX500, also einer guten SATA SSD!

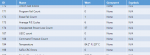

Die Samsung 970 Evo muss sich mit ihren 637,8MB/s im Testfeld hingegen nur der Optane 900P (1136,7MB/s) geschlagen geben und wäre auch der neuen Evo Plus unterlegen. Aber Konkurrenten mit dem SM2262EN, die ebenfalls extrem große dynamische Pseudo-SLC Schreibcaches verwenden, sind trotz TLC NANDs wenn die gut gefüllt sind, nicht wirklich besser als die beiden mit QLC. So schaffen die DATA XPG SX8200 Pro und die HP EX950 (alle jeweils als 1TB) beim

AnandTech Storage Bench - The Destroyer zwar etwa 650MB/s, während die 970 Evo Plus auf über 1100MB/s kommt. Im

AnandTech Storage Bench - Heavy sind es für beide leer etwa 906MB/s, während 970 Evo Plus mit 883MB/s sogar leicht zurückhängt, aber bei voller SSDs dreht sich das Bild komplett, da hat die beiden bei 273 bzw 296MB/s, während die 970 Evo Plus mit 746MB/s auf einen mehr als 2,5 mal so hohen Wert kommt!

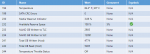

Nun kann man sagen, man haben keine so anspruchsvollen Lasten, aber auch im

AnandTech Storage Bench - Light wird es nur noch schlimmer, da liegt die AData bei 209 und die HP 252MB/s wenn sie voll sind, da ist selbst eine MX500 1TB mit 261MB/s schneller und die 970 Evo Plus ist mit 977MB/s etwa 4x so schnell.

Tweaktown hat im Review der Optane 905P 960GB sehr passend geschrieben, dass man vor allem für die Konsistenz der Performance auch bei anspruchsvolleren Workloads und auch bei voller SSD bezahlt:

Genauso ist es und wer billig kauft, sollte dies nicht vergessen, denn mit dem kleinen SRAM um Controller einer DRAM less SSD und den Pseudo-SLC Schreibcaches (bei QLC auch gerne als Lesecache zu betrachten, wenn der Controller die Daten dort extra lange vorhält), bekommt man bei bei Benchmarks wie CDM oder AS-SSD auf der leeren SSD immer Werte hin die im Datenblatt gut aussehen, bei Phison Controllern gibt es dazu noch wie früher bei Sandforce eine Datenkompression die bei ATTO Wunder wirkt, aber kein Mensch betreibt seine SSD dauerhaft so leer als das diese Mittel die scheinbar tolle Performance aufrecht halten könnten! Da Techniken wie die einen Teil der Mappingtabelle im SRAM zu halten nötig sind bzw. wie der Pseudo-SLC Schreibcache die SSD auch im Alltag schneller machen, wurde ich sie nicht als Tricks und Schummelei abtun, aber Nebeneffekt damit auch gute Benchmarkwerte einzufahren, spielt bei der Auslegung sicher auch eine Rolle und gerade der SM2262EN zeigt im Vergleich zum Vorgänger, dass die einseitige Optimierung auf gute Benchmarkwerte bei leerer SSDs, dann auf Kosten der Performance im vollen Zustand gehen können. Ich möchte auch gar nicht wissen wie viele Leute ihre Meinung wonach NVMe SSDs gegenüber SATA SSDs keinen Vorteil bringen, letztlich aufgrund von Modellen gebildet haben, bei denen die Performance in der untersuchten Situation auch gar nicht besser war.

wille1277 schrieb:

Ist es normal das die alte Samsung 840pro bei 4k und 4k64thrd soviel stärker ist?

Ja, die ist eine tolle Premium SSD mit einem schnellen Controller mit DRAM Cache und schnellen MLC NANDs.

xxMuahdibxx schrieb:

Zugriffszeit ist schon arg hoch ...

Wundert Dich das wirklich? Die Messung der Zugriffszeit ist aber bei AS-SSD sowieso verbuggt, da nicht darauf geachtet wird, ob die gelesenen LBAs auch belegt sind, also in der Mappingtabelle stehen. Der Controller kann aber nur etwas lesen, wenn der LBA auch gültige Daten enthält, sondern steht er nicht in er Mappingtabelle und der Controller liefert irgendwas (meist 00) zurück, ohne überhaupt etwas aus dem NAND zu lesen. Daher wird die Zugriffszeit auch höher, je voller die SSD ist, dann damit steigt die Wahrscheinlichkeit, dass wirklich Daten aus dem NAND gelesen werden und dies dauert eben länger.

Nur haben diese DRAM Less SSD eben das Problem, dass der Controller sobald sie etwas voller sind, erst noch den passenden Teil der Mappingtabelle lesen muss und dann erst wissen kann, ob und wo er ggf. noch etwas aus dem NAND lesen muss, daher sind die Zugriffszeiten lesend bei denen so extrem viel höher, sobald die voller werden, denn dann sind sehr wahrscheinlich immer zwei NAND Zugriffe nötig.