hm eine Frage was heißt Dl denn ausgeschrieben?Laphonso schrieb:Die wird ebenfalls SEHR interessant für "casual" DL und workflow Prozesse.

Und mit 1/3 fps Balken Vorsprung auch jeden Gaming benchmark gewinnen.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

News GeForce RTX 5000: Acer nennt RTX 5090 32 GB & 5080 16 GB, Otto.de erste Preise

- Ersteller Jan

- Erstellt am

- Zur News: GeForce RTX 5000: Acer nennt RTX 5090 32 GB & 5080 16 GB, Otto.de erste Preise

Ich schätze mal, damit ist "Deep Learning" gemeint, also die Karte für KI-Modelle benutzen, was sich bei 32 GB VRAM durchaus anbietet.latiose88 schrieb:hm eine Frage was heißt Dl denn ausgeschrieben?

du bist wohl eher der klugscheisser wenn du das im duden nachguckst , so ein aufwand..shaboo schrieb:Das magst du vielleicht so verstanden haben, war aber nicht so gemeint. Es ging schlicht darum, dass die 7800XT eine falsche bzw. unpassende Bezeichnung hat:

https://www.computerbase.de/artikel...rx-7800-xt-test.85286/seite-4#abschnitt_fazit

Die RX 7800 XT trägt den falschen Namen

AMD hätte die Radeon RX 7800 XT besser Radeon RX 7800 genannt, dann hätte das Bild besser zur Radeon RX 6800 XT und zur Radeon RX 7700 XT gepasst.

Ergänzung ()

Klugscheißer. Laut Duden ist beides richtig. Verlinke ja ungerne zu Computerbild, aber ausnahmsweise:

https://www.computerbild.de/artikel...n-Duden-Wikipedia-und-Microsoft-22814683.html

MfG der Schreiber

darkcrawler

Lt. Commander

- Registriert

- Okt. 2006

- Beiträge

- 1.530

hennich

Banned

- Registriert

- Jan. 2004

- Beiträge

- 1.081

Cohen schrieb:Sorry, bei Peak-Belastung (so wie du geschrieben hast), kann das nicht stimmen.

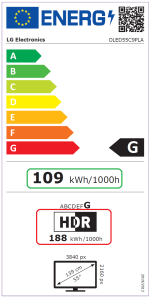

Welchen OLED-Fernseher hast du denn? Da gibt es ja eindeutige Herstellerangaben, die bestimmt nicht schlechter dargestellt werden als die tatsächliche Leistungsaufnahme. Hier ein paar Beispiele von populären Modellen:

Anhang anzeigen 1558808

Bereits bei Launch-Spielen wie Gears 5 hat die Xbox Series X bis zu 180 Watt geschluckt:

https://www.chip.de/test/Xbox-Series-X-im-Test_183093751.html

Und seitdem sind noch deutlich leistungshungrigere Spiele erschienen, z. B. MS Flight Simulator 2024, Indiana Jones und der große Kreis, Alan Wake 2, Black Myth: Wukong, die das obere Limit von 210 Watt vermutlich noch mehr ausreizen.

Und wenn man bei einem Vollverstärker inklusive der angeschlossenen Lautsprecher im Peak insgesamt bei nur 25 Watt Gesamtverbrauch liegt... sorry, dann braucht man keinen Vollverstärker. Das ist mit Kanonen auf Spatzen schießen.

Hab hier den Screenshot vom Actor.

Xbox Series X, LG 65" OLED C9, Denon 1700H

300Watt. 310Watt weil Dect LED Lämple.

Du kannst einfach Fakten nicht wegquatschen.

p.s. die deine Sachen geliked haben, stehen jetzt genauso gelackmeiert da wie du

snickii

- Registriert

- Aug. 2014

- Beiträge

- 16.273

Wenn man die 4080 betrachtet ist ein Preissprung doch realistisch, selbst wenn er gering wäre.. würden die guten 5080 Customs knapp über 1500€ kosten.

Und keine 5090 unter 2000€ kosten, die guten eher um 2400-2600€

Die Super Karten kosten dann wieder 500€ weniger.

Und keine 5090 unter 2000€ kosten, die guten eher um 2400-2600€

Die Super Karten kosten dann wieder 500€ weniger.

Cohen

Commodore

- Registriert

- Aug. 2010

- Beiträge

- 4.895

Wir sind aber nicht gelackmeiert. Dein Screenshot beweist schließlich keine Peak-Auslastung.hennich schrieb:Hab hier den Screenshot vom Actor.

Anhang anzeigen 1560590

p.s. die deine Sachen geliked haben, stehen jetzt genauso gelackmeiert da wie du

- Bildschirm-Helligkeit unbekannt

- HDR-Modus unbekannt

- Lautstärke unbekannt

- Spiel(-szene) unbekannt

Aber netter Versuch. ;-)

Nochmals zu den 25 Watt des Denon im Eco-Modus.

Laut Herstellerangaben sind es bei deinem Denon 1700H bereits im Leerlauf 29 Watt, je nach Lautstärke und angeschlossenen Boxen kann sich das bis zu 430 Watt steigern:

Selbst wenn man nicht mit ohrenbetäubender Lautstärke zockt, kann man wohl von mindestens 50 - 100 Watt für AVR + Lautsprecher ausgehen, wenn man nicht komplett ohne Ton spielt.

Dein 65'' LG OLED C9 begnügt sich zwar im SDR-Modus mit durchschnittlich 137 Watt, im HDR-Modus müssten es aber ca. 250 Watt sein, wenn man das Nachfolgemodell LG OLED CX als Anhaltspunkt nimmt.

Auch andere 2019er OLED-Modelle deuten darauf hin, z. B. mein 55'' C9 derselben Serie mit 188 Watt im HDR-Modus... der 65'' C9 muss 40% mehr Bildfläche beleuchten, was hochgerechnet ca. 260 Watt wären:

Der Vollständigkeit halber sind hier noch die offiziellen Herstellerangaben von Microsoft zur durchschnittlichen Leistungsaufnahme der Xbox Series X:

Und Tests haben ergeben, dass dies eben nur der Durchschnitt ist und dass leistungshungrigere Series-X-Spiele auch bis zu 200 Watt ziehen können.

Zuletzt bearbeitet:

hennich

Banned

- Registriert

- Jan. 2004

- Beiträge

- 1.081

Es ist wirklich Brutal wie arg manche sind. Was soll ich sagen, es sind halt 300 Watt du kannst machen was du willst

Du kannst gerne herkommen und deine Elektronischen Helferlein mitbringen zum Messen.

Btw. ich spiel damit Stalker 2 auf der X.

Frohes Fest Cohen!

Heute abend lass ich dir den ganzen Abend den Actor mitlaufen - nur für dich 😘

😘

btw. Robert Habeck hat auch durchgerechnet - sieht gut aus!

Du kannst gerne herkommen und deine Elektronischen Helferlein mitbringen zum Messen.

Btw. ich spiel damit Stalker 2 auf der X.

Frohes Fest Cohen!

Heute abend lass ich dir den ganzen Abend den Actor mitlaufen - nur für dich

btw. Robert Habeck hat auch durchgerechnet - sieht gut aus!

Zuletzt bearbeitet:

lolekdeluxe

Lt. Junior Grade

- Registriert

- Aug. 2010

- Beiträge

- 337

Da werden mit voller absicht Schatten weggelassen beim standard Shader, um die wieder bei RT auftauchen zu lassen. Das ist ja mal wieder eine echte Innovation von Nvidia.Turrican101 schrieb:https://i.ibb.co/sbDs8H4/cp2077.jpg

Also CP2077 sieht mit PT teilweise aus wie ein komplett neues Spiel. Das Bild unten zeigt die Probleme vom Rasterizer sehr schön. Der ganze Raum ist überall hell ausgeleuchtet, obwohl es nur den TV als Lichtquelle gibt. Der Stuhl wirft keinen Schatten. Der Deckel der Stahlbox ist hell beleuchtet und zeigt Reflektionen, die Wand ist dagegen dunkel.

Sowas stört mich jedenfalls mehr als wenn irgendwo mal ein Flackern ist oder die Texturen weniger Details haben.

Die machen das mit Tricks damit es ein Verkaufsargument gibt. Und es heißt ja nun wo es normalerweise voher auch alles ohne ki funktionierte nun immer nur ki damit man auch da ein Verkaufsargument hat. Aber es geht auch ohne ki alles was es nun angeblich die ki nur kann. Also 2 Verarschungs Sachen nur um das Geld aus der Tasche zu ziehen. Ist echt lächerlich aber da kann man nix machen.

Turrican101

Vice Admiral

- Registriert

- Aug. 2007

- Beiträge

- 6.603

Also ist das nVidias Schuld, dass seit Ewigkeiten in Raster-Spielen irgendwelche Schatten fehlen oder falsch sind? Und das auch bei Grafikkarten anderer Hersteller? Interessant.

q3fuba

Lt. Commander

- Registriert

- Jan. 2009

- Beiträge

- 1.083

Also ich muss hier mal ein "selbst Zitat" einfügen, denn für die 5080 sind Preise "geleaked" und zwar schon bei "normalen" Händlern schon Teurer als ich von Scalpern vermutet hätte...q3fuba schrieb:Also wird die 5080 ~1600€ kosten und die 5090 ~2800€ bei EBay dann, wenn die Händler nichts mehr haben ^^

1700€ für eine Mittelklasse Karte... und JA die XX80 ist nur mehr eine "Mittelklasse Karte" und zwar definitiv, vor allem die 5080 laut Technischen Specs!

Einfach nur lächerlich sowas...

Einfach nur lächerlich...

https://www.notebookcheck.com/Haend...unders-Edition-mit-LED-Streifen.940211.0.html

Ähnliche Themen

- Antworten

- 186

- Aufrufe

- 19.495

- Antworten

- 39

- Aufrufe

- 5.993

- Antworten

- 347

- Aufrufe

- 29.631

- Antworten

- 29

- Aufrufe

- 2.363

- Antworten

- 395

- Aufrufe

- 37.732