Taxxor schrieb:

Und bei gleichem Takt gerade mal 9% schneller als RDNA2, bei RT immerhin 18-20%, bei laut Präsentation "up to 2x IPC" pro CU.

Du sagtest es bereits: Marketingfolien. AMD wird hier zudem ein Szenario gewählt haben, wo die verbesserten "Multithreading" FP32-Einheiten glänzen konnten.

Taxxor schrieb:

Bei RT reicht es auch nicht mal für die runden 50% Steigerung, während die 4090 knapp 70% auf die 3090 draufgelegt hat. Der Abstand in RT ist somit am ende sogar größer geworden, als bei RDNA2 vs Ampere.

3090 vs 6950XT = +47%

4090 vs 7900XTX = +74%

3080 vs 6900XT = +19%

4080 vs 7900XT = +47%

Die Vergleiche mit der Vorgängergeneration hinken etwas.

1. Die Namensgebung einfach 1:1 zwischen den beiden Generationen her zu nehmen, verfälscht das reale Kräfteverhältnis. Die RX 7900 XTX ist AMDs Flaggschiff + Vollausbau zu Beginn und entspricht somit der RX 6900 XT von 2020. Folglich entspricht die RX 7900 XT viel mehr der Leistungsklasse einer RX 6800 XT. Ich persönlich finde AMDs neue Namensgebung derzeit noch etwas irritierend, da man sich eben bereits komplett an die Vorgängergeneration gewöhnt hat.

2. Ganz offensichtlich hat AMD bei RDNA3 noch mit Treiberproblemen zu kämpfen. Nicht schön, aber immerhin handelt es sich hier um das erste Multi-Chiplet-Design bei Gaming-Grafikkarten. Bei der Ryzen 1000 Generation gab es schließlich auch gewisse Anfangsschwierigkeiten. Das heißt es steckt mit Sicherheit noch einiges an Leistungspotential in RX 7000, während es bei Ada erfahrungsgemäß bereits weitestgehend ausgeschöpft sein sollte.

3. Die RTX 4090 ist eine außerordentlich gut gewordene Grafikkarte, dass muss man sagen. Verglichen mit der UVP des Vorgängers ist der Preis diesmal immerhin angemessen. Wenn man aber jetzt die 1599$ der RTX 4090 vs die 999$ der RX 7900 XTX nimmt und meinen 2. Punkt berücksichtigt, sieht die Sache plötzlich gar nicht mehr so schlecht aus für AMD.

4. Ein Multi-Chiplet-Design (MCD) geht immer auch mit Performanceeinbußen einher im Vergleich zu einem monolithischen Aufbau, eben durch die Kommunikation zwischen den einzelnen physisch von einander getrennten Chiplets. Die Vorteile sind hier vordergründig bei der Chipausbeute pro Wafer zu finden, also zum Schluss beim Endpreis. Ob Nvidia mit den Ada-102 GPU-Dies einen großen Spielraum für die Preisgestaltung hat, wird sich zeigen. Vermutlich würden sie bei einem Preiskampf pro Einheit mit AMD wirtschaftlich den kürzeren ziehen, selbst wenn die Herstellungskosten der ersten Generation von MCD-GPUs sicherlich noch etwas teurer sein wird. Das geballte Knowhow mit den Ryzen-CPUs wird hier einiges kompensieren können.

Taxxor schrieb:

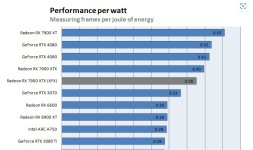

Das schimmste ist, nachdem AMD im Marketing so sehr auf den Faktor Effizienz gesetzt hat, sind beide Modelle deutlich ineffizienter als die 4080 oder die 4090.

Zur 6900XT lediglich ein Sprung von +18% Perf/W. Selbst wenn man die Black Edition nimmt, die mit 375W bereits 40W mehr ziehen darf als eine 6950XT, kommt man gerade mal auf +41%.

In 1440p wird der Perf/W Vorsprung schon fast einstellig.

Wie gesagt: RDNA3 läuft leider noch nicht rund. Wenn man sich ausgewählte Spiele anschaut, wo RX 7000 außerordentlich gut performt, und dies dann auf die Spiele bezieht, wo man bei AMD offensichtlich noch mit Treiberproblemen zu kämpfen hat, sieht die Performance gut aus. Und wer weiß: es wurde hier (bei computerbase) mit einem Intel-System getestet. Vielleicht gibt es bei einem Ryzen-7000-System und einer RX 7000 noch einen zusätzlichen Vorteil gegenüber einer RX 6000 GPU, schließlich kommen die jeweils neuste CPU- und GPU-Generation aus dem gleichen Haus und wurden auf Grund der zeitnahen Entwicklung vermutlich noch einmal besser aufeinander abgestimmt. Außerdem bringt ein reines AMD-System den zusätzlichen Vorteil von SAM, die deutlich beste Resizable-Bar-Lösung am Markt. Hier spielt AMD einen kleinen Joker gegenüber ein Intel-Nvidia-System aus, weil sie nun einmal auch ein führender CPU-Hersteller sind und dadurch Plattform-eigene Optimierungen vornehmen können.

Taxxor schrieb:

Ich erinnere mich noch an das Interview mit einem AMD Vertreter, wo es sinngemäß hieß "Wir werden auch die Leistungsaufnahme erhöhen müssen, aber durch unser Effizientes Design werden wir es nicht so weit erhöhen müssen, wie unsere Konkurrenz"

Und nun? Um die Performance einer ~300W 4080 zu erreichen braucht die 7900XTX ~350W.

Mit 144FPS Limit in 1440p wird es in absoluten Zahlen noch deutlicher: ~250W für die 7900XTX gegen gerade mal ~125W für die 4080 und sogar die 6900XT verbraucht deutlich weniger.

Das wäre genau mein Nutzerszenario(das Limit sogar niedriger als 144) und daher wären die Karten, wenn ich nicht schon vorher bei Nvidia zugeschlagen hätte, spätestens hier komplett raus.

AMD hat die Effizienz (W/FPS) in Spielen gegenüber RDNA2 deutlich verbessert. Sieh dir bitte auch das Effizienz-Ranking bei Igorslab an, das sieht gut aus für AMD. Nvidia hat aber nochmal einen besseren Job gemacht. Jetzt muss man an der Stelle aber wieder sagen, dass dies nur eine Momentaufnahme ist, wegen "Fine Wine" und so. Da werden sich die Ergebnisse mit der Zeit für AMD noch weiter verbessern. Und man sollte auch nicht vergessen, dass Nvidia einen effizienteren monolithischen Aufbau hat und mit N4 noch einmal einen etwas besseren Herstellungsprozess.

Taxxor schrieb:

Das kann doch nur ein Hardware Bug oder einer Treiberproblem sein. Ich hoffe für AMD letzteres, vermute aber fast schon eher ersteres aufgrund der so schnell aufkommenden Gerüchte über einen Refresh.

Hoffentlich handelt es sich nicht um ein Hardware-Bug. Als MCD-Pionier ist die Wahrscheinlichkeit leider von Natur aus höher, dass es zu technischen Problemen kommen kann. Mal sehen, wie sich das Ganze weiter entwickelt.

Taxxor schrieb:

Selbst eine auf 300W limitierte 4090 ist noch deutlich schneller als alles, was der Top Chip von AMD bei 355W liefern kann und die 4090 ist dabei noch nicht mal der Vollausbau des AD102.

Taxxor schrieb:

Nun steht also die ca gleiche Raster Performance, 20-25% weniger RT Performance, 50-60W mehr Verbrauch unter Vollast, nahezu doppelter Verbrauch im FPS Limit und das Fehlen von DLSS2, DLSS 3 FG und Reflex gegen eine Preisersparnis von knapp 200€.

Und das auch nur, wenn man an eine Referenzkarte kommt, was nicht sehr vielen vergönnt sein dürfte, ansonsten dann 0-100€ bei einem Custom Design.

Alles bereits gesagt bis auf das Thema Zusatzfeatures. Wenn ich FSR2 mit meiner AMD-Grafikkarte nutzen kann, brauche ich kein DLSS2. Das Gegenpendant DLSS3 und Reflex werden auf jeden Fall kommen, wenn auch etwas später. Essenziell sind diese Features darüber hinaus nicht.

Nvidia hat RTX 4000 einige Monate eher veröffentlicht. Die RX 7000 muss erst einmal richtig im Markt ankommen. Die Zeit wird es richten.