Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

News Nvidia Blackwell: RTX 5000 mit bis zu 512 Bit zwischen Fantasie und Wirklichkeit

johnieboy

Commodore

- Registriert

- Juni 2007

- Beiträge

- 4.471

Ich finde diese "Leaker" ja nur mittelmäßig unterhaltsam.

Die werfen mit Zahlen um sich und irgendwas davon wird schon richtig sein wenn die GPUs dann veröffentlicht werden.

Meine Glaskugel geht ja von 4090-->5090 +50% Raster Performance aus bei relativ gleich bleibender Leistungsaufnahme.

Ob das mit 256, 384 oder 512 bit Speicherinterface erreicht wird ist komplett egal.

Die werfen mit Zahlen um sich und irgendwas davon wird schon richtig sein wenn die GPUs dann veröffentlicht werden.

Meine Glaskugel geht ja von 4090-->5090 +50% Raster Performance aus bei relativ gleich bleibender Leistungsaufnahme.

Ob das mit 256, 384 oder 512 bit Speicherinterface erreicht wird ist komplett egal.

- Registriert

- Juli 2021

- Beiträge

- 2.984

Gut, alles zu lesen ist jetzt echt zu viel. Testen lenkt gut ab. Ich geh aber dennoch auf ein paar Blüten ein!

Mehr VRAM wird heute primär aus 3 Faktoren benötigt:

1. Höher auflösende Texturen. Es macht einen Unterschied ob man nur 1K, 2K oder jetzt eben durchgängig auf 4K und teilweise schon auf 8K setzt.

2. Immer feinere Modelle. Es macht halt auch einen Unterschied ob ein Modell nur ein paar hundert Tausend oder Millionen Polygone hat oder man jetzt sich teilweise eher den 100.000.000 annähert pro Modell.

3. Immer weniger Wiederverwertung von Assets. Der Anspruch der Entwickler aber auch der Spieler ist gewachsen und entsprechend wird immer häufiger versucht Assets nur einmalig zu verwenden. Auch das kostet Speicher.

All das hat nichts damit zutun, dass die Entwickler zu faul sind zu optimieren, sondern ist alleine technisch bedingt.

Es gibt zwar ein paar Möglichkeiten den VRAM-Bedarf zu senken, nur geht das mit entsprechenden Nachteilen einher, weil man dann an andere Stelle "mehr" braucht. Zu nennen wäre DirectStorage und die Intel Demo mit Sampler Feedback. Nur statt das die Daten im VRAM liegen und dort einfach nur Platz einnehmen, wird die Last auf GPU - Entschlüsselung - und SSD verlagert, was dann in allgemein mehr Energiebedarf resultieren könnte.

Pauschal das immer als Faulheit abzutun, ist einfach nur unfundierter Blödsinn.

Es bringt einer GPU nichts, wenn man mehr Bandbreite hat oder die Latenzen verkürzt beim VRAM, weil die GPU damit in der Regel nicht umgehen kann. Bei einer GPU merkt man nur, wenn es zu wenig Bandbreite gibt, weil die Register-Files und Caches damit leerlaufen. Der VRAM muss nur schnell genug sein.

GPUs arbeiten bis heute weitgehend nach einem In-Order-Prinzip und verzichten weitgehend auf komplexe Kontrollogik, damit man eben viele Recheneinheiten unterbringen kann. Genauso werden die Rechenwerke in Gruppen angesprochen, weil man sich damit weitere Kontrolleinheiten spart, das SIMD/SIMT-Prinzip.

Mit den L0 und L1 sowie L2 Cache Stufen vor dem VRAM, wird dieser entlastet und entsprechend kann man anhand der Cache-Größen und Co die maximale Bandbreite absenken.

Eine RTX 4090 reagiert auf VRAM-Takt sogut wie garnicht. Das sieht man an der Palit und Colorful bei Techpowerup. Beide laufen mit 3000 MHz, einmalk 1500 MHz VRAM und einmal 1585 MHz VRAM. 5 % mehr Takt resultieren in 0,2 % mehr FPS.

Anders als CPUs, verzichten GPUs bewusst auf vieles, was wir von dort kennen, damit viele Rechenwerke untergebracht werden. Out-of-Order und entsprechende Sortierung von Befehlen findet man in GPUs quasi nicht. Sprungvorhersagen gibt es nicht, spekulative Ausführung ebenso wenig. Der Datenfluss und Programmfluss wird weitgehend durch den Treiber vorgeben und dann abgearbeitet.

Shader sind deswegen - bis heute - weitgehend "Spaghetti-Code", weil man auf Kapselung in Funktionen/Methoden/Klassen verzichtet. Selbst if-else-Konstrukte sollte man weitgehend vermeiden.

Der RAM muss nur schnell genug angebunden sein, alles darüberhinaus bringt keinen Mehrwert bei der GPU.

Nein, das ist an der Stelle einfach nur pauschal und weitgehend falsch.LikeAnIrish schrieb:aber mehr Speicher brauchen eben genau die, die zu faul zum optimieren sind ...

Mehr VRAM wird heute primär aus 3 Faktoren benötigt:

1. Höher auflösende Texturen. Es macht einen Unterschied ob man nur 1K, 2K oder jetzt eben durchgängig auf 4K und teilweise schon auf 8K setzt.

2. Immer feinere Modelle. Es macht halt auch einen Unterschied ob ein Modell nur ein paar hundert Tausend oder Millionen Polygone hat oder man jetzt sich teilweise eher den 100.000.000 annähert pro Modell.

3. Immer weniger Wiederverwertung von Assets. Der Anspruch der Entwickler aber auch der Spieler ist gewachsen und entsprechend wird immer häufiger versucht Assets nur einmalig zu verwenden. Auch das kostet Speicher.

All das hat nichts damit zutun, dass die Entwickler zu faul sind zu optimieren, sondern ist alleine technisch bedingt.

Es gibt zwar ein paar Möglichkeiten den VRAM-Bedarf zu senken, nur geht das mit entsprechenden Nachteilen einher, weil man dann an andere Stelle "mehr" braucht. Zu nennen wäre DirectStorage und die Intel Demo mit Sampler Feedback. Nur statt das die Daten im VRAM liegen und dort einfach nur Platz einnehmen, wird die Last auf GPU - Entschlüsselung - und SSD verlagert, was dann in allgemein mehr Energiebedarf resultieren könnte.

Pauschal das immer als Faulheit abzutun, ist einfach nur unfundierter Blödsinn.

Nein, die FPS brechen in 4K nicht so schnell ein, weil der Speicherdurchsatz nicht passt. Eine GPU arbeitet anders als eine CPU.JoeDoe2018 schrieb:dann kommt die 5090 auf 2000GByte/s Speicherdurchsatz das ist doppelt so viel wie die aktuelle Generation hat. Dann brechen die FPS bei 4k nicht immer so schnell ein.

Es bringt einer GPU nichts, wenn man mehr Bandbreite hat oder die Latenzen verkürzt beim VRAM, weil die GPU damit in der Regel nicht umgehen kann. Bei einer GPU merkt man nur, wenn es zu wenig Bandbreite gibt, weil die Register-Files und Caches damit leerlaufen. Der VRAM muss nur schnell genug sein.

GPUs arbeiten bis heute weitgehend nach einem In-Order-Prinzip und verzichten weitgehend auf komplexe Kontrollogik, damit man eben viele Recheneinheiten unterbringen kann. Genauso werden die Rechenwerke in Gruppen angesprochen, weil man sich damit weitere Kontrolleinheiten spart, das SIMD/SIMT-Prinzip.

Mit den L0 und L1 sowie L2 Cache Stufen vor dem VRAM, wird dieser entlastet und entsprechend kann man anhand der Cache-Größen und Co die maximale Bandbreite absenken.

Eine RTX 4090 reagiert auf VRAM-Takt sogut wie garnicht. Das sieht man an der Palit und Colorful bei Techpowerup. Beide laufen mit 3000 MHz, einmalk 1500 MHz VRAM und einmal 1585 MHz VRAM. 5 % mehr Takt resultieren in 0,2 % mehr FPS.

Es ist vollkommen egal ob 128 Bit, 256 Bit, 384 Bit oder 512 Bit. Am Ende muss der Durchsatz stimmen. Wenn man eine GPU mit 128 Bit Interface und GDDR7 ordentlich versorgen kann, dann ist alles in Butter.DiamondDog schrieb:bin auch dafür, dass wir 128Bit Speicherinterface endlich als Standard und nicht als Rückschritt einsehen

Eine breiters SI geht einher mit einer höhren Bandbreite des VRAMs, bedingt aber nicht unbedingt eine höhere Geschwindigkeit der GPU.Silencium schrieb:Dient eine höhere Anbindung nur der Menge an VRAM oder ergibt sich dadurch auch eine Steigerung bei der gesamten Geschwindigkeit einer GPU?

Anders als CPUs, verzichten GPUs bewusst auf vieles, was wir von dort kennen, damit viele Rechenwerke untergebracht werden. Out-of-Order und entsprechende Sortierung von Befehlen findet man in GPUs quasi nicht. Sprungvorhersagen gibt es nicht, spekulative Ausführung ebenso wenig. Der Datenfluss und Programmfluss wird weitgehend durch den Treiber vorgeben und dann abgearbeitet.

Shader sind deswegen - bis heute - weitgehend "Spaghetti-Code", weil man auf Kapselung in Funktionen/Methoden/Klassen verzichtet. Selbst if-else-Konstrukte sollte man weitgehend vermeiden.

Der RAM muss nur schnell genug angebunden sein, alles darüberhinaus bringt keinen Mehrwert bei der GPU.

MrHeisenberg

Lt. Commander

- Registriert

- Okt. 2022

- Beiträge

- 1.713

Eine Bewertung sollte aber objektiv sein. Auf subjektiver Ebene kann man nicht diskutieren. Ich kann dir ja schlecht absprechen, wie du etwas persönlich findest. Es gibt einige Spiele die mir persönlich auch besser gefallen als andere, aber objektiv betrachtet ist das dann oft gar nicht der Fall.OdinHades schrieb:Ich will gar nicht abstreiten, dass die genannten Titel rein technisch besser, toller und beeindruckender sind. Aber für mich sehen sie trotzdem nicht besser aus. Das ist am Ende halt immer noch sehr subjektiv. Selbst Raytracing oder Pathtracing oder was gerade der heiße Shit sein mag, ersetzt für mich kein gutes und stimmiges Artdesign.

Die meisten genannten Spiele bieten kein RT.OdinHades schrieb:Selbst Raytracing oder Pathtracing oder was gerade der heiße Shit sein mag, ersetzt für mich kein gutes und stimmiges Artdesign.

Das hier soll nicht besser aussehen als RDR2? https://s3.amazonaws.com/digitaltre...-ii-performance-terrain-Groundcover-Ultra.jpg

Nehme ich dir nicht ab.

Hier 2 Beispiele, die Fotorealismus grenzen:

YouTube

An dieser Stelle steht ein externer Inhalt von YouTube, der den Forumbeitrag ergänzt. Er kann mit einem Klick geladen und auch wieder ausgeblendet werden.

Ich bin damit einverstanden, dass YouTube-Embeds geladen werden. Dabei können personenbezogene Daten an YouTube übermittelt werden. Mehr dazu in der Datenschutzerklärung.

YouTube

An dieser Stelle steht ein externer Inhalt von YouTube, der den Forumbeitrag ergänzt. Er kann mit einem Klick geladen und auch wieder ausgeblendet werden.

Ich bin damit einverstanden, dass YouTube-Embeds geladen werden. Dabei können personenbezogene Daten an YouTube übermittelt werden. Mehr dazu in der Datenschutzerklärung.

Das mag sein, allerdings wie häufig triffst du denn Charaktere außerhalb von Städten? Die meiste Zeit reitest du durch die Wildnis und hin und wieder kommt dir mal eine Kutsche entgegen. Alles in allem ist das Spiel, abseits von Städten, recht leer.OdinHades schrieb:Hab ich nie nachgemessen, aber das Spiel hat sich vor allem unheimlich lebendig angefühlt. Die Charaktere haben eine starke Mimik und sehr ansehnliche Animationen. Das wirkt alles nicht so "hakelig" und Uncanny Valley-mäßig wie in vielen anderen Spielen, und da muss ich gerade ganz stark an Cyberpunk denken. Letzteres hatte viel mehr diesen typischen Charakter eines Videospiels.

The Last of Us 2 sieht definitiv besser aus.

Ja, aber es sah definitiv nicht so toll aus wie aktuelle Titel. Auf der PS4 lief es mit low-mid Settings.OdinHades schrieb:Also auf meiner Playsi lief es schulterzuck

Zuletzt bearbeitet:

- Registriert

- Okt. 2023

- Beiträge

- 2.634

Die ewige Selbstkasteiung nichts zu kaufen, weil es teurer wird, wäre auch eine steile These. Die Karte wird letztendlich für das verkauft was sie wert ist. Und wenn das 1999 Dollar sind, sind es eben 1999. Mehr oder weniger.danyundsahne schrieb:Also doch 2500€+ für das Topmodell...und die Leute flippen aus, die meisten nehmen sich nen Kredit und kaufen wie blöde.

Zuerst würde ich abwarten was die Karte kostet. Das Preisthema ist aber der einzige Angriffspunkt, wollte man schon negativ im Vorfeld etwas sagen.danyundsahne schrieb:Aber die preisliche Entwicklung kann und darf man einfach nicht gut heißen.

Stell dir vor. Meine Hawaii 290X GPU hatte auch ein 512 bit Interface und kostete nur 499 Dollar.danyundsahne schrieb:Bei 512-bit, wohl mindestens 32, vll sogar 48GB VRAM, wird der Preis einfach nicht unter 2K€ sein, wohl eher Richtung 2,5K. Das muss man sich mal überlegen...für eine GPU, bei der die meisten eh nur Zocken wollen....

Gähn. Der Preis ist von mehreren Dingen abhängig. Natürlich auch von der Konkurrenz. Wenn AMDs Topmodell nur 35% auf das alte drauflegt, Nvidia aber 60% oder mehr und AMD den gleichen Preis verlangt, kann Nvidia auch die Preise anziehen.danyundsahne schrieb:Und jetzt sagt mir nicht wieder AMD sei schuld. Nein, das verbockt NV ganz alleine mit den Preisen

Abgesehen davon haben wir aktuell sowieso keine teuren Preise mehr, du kannst dein "Geweine" also nicht so wirklich ernst meinen.

- Registriert

- Okt. 2023

- Beiträge

- 2.634

Wenn man 5 Meter vor dem Fernseher sitzt vielleicht. Das Art Design hat nichts mit Grafikqualität zu tun. Mit gefiel Borderlands 3 auch, dennoch behaupte ich nicht, dass das besser als X aussieht.OdinHades schrieb:Also auf meiner Playsi lief es schulterzuck

[wege]mini

Banned

- Registriert

- Juli 2018

- Beiträge

- 8.357

DevPandi schrieb:5 % mehr Takt resultieren in 0,2 % mehr FPS.

True words.

DevPandi schrieb:Selbst if-else-Konstrukte sollte man weitgehend vermeiden.

Soso. Du bist also auch schon ein älteres Semester. Wenn dann noch GO TO ins Spiel kommt, sind wir wieder in den 80er Jahren des letzten Jahrhunderts und bei BASIC.

Leider hast du völlig recht. Das "Können" der Softwareheinis ist leider nur so gut, wie die anderen Softwareheinis es ihnen bei gebracht haben, als die an "Hochschulen" waren.

btt:

Wenn ich es bauen müsste, würde ich über Latenzen vom VRAM reden und über maximale Geschwindigkeiten im Durchsatz. Dann würde ich überlegen, ab wann 512Bit zu einem Punkt kommt, wo man mit Kanonen auf Spatzen schießt.

Aktuell gehe ich von 384Bit aus.

mfg

danyundsahne

Commodore

- Registriert

- Okt. 2007

- Beiträge

- 4.512

Das ist mir bewusst, ich weiß dass sehr viele Menschen gerne das Geld ausgeben, weil sie es können und wollen. Und es ist mir auch bewusst, das NV sein Geld hauptsächlich mit der deutlich gewinnträchtigeren KI/Server/Datacenter Branche verdient.juwa schrieb:Für nicht wenige Leute sind 2,5k€ nicht wirklich viel Geld. Bedenke auch, dass für Nvidia der Gaming Bereich sowieso nur ein Nebengeschäft ist, den man so beiläufig mitnimmt. Das große Geld verdienen die in anderen Bereichen.

So wie ich aber schrieb, wird sich die Preisgestaltung auch für uns Gamer im Lineup darunter entsprechend des Halo Produktes auswirken. Sieht man ja schon seit einigen Gens bei NV und selbst teilweise bei AMD, wenn auch nicht ganz so gravierend.

Und der Mainstream muss sich dann entweder mit stagnierender Performance für tatsächlich noch mehr Geld rumärgern.

Und die Kluft wird auch hier immer größer.

Die Preise steigen in jeder Klasse, aber die Performance stagniert unterhalb des Vollausbaus (bzw. des tatsächlich verkauften Halo Produktes, ist ja nicht immer der Vollausbau TITAN gewesen).

Eine hypothetische RTX4090ti/Titan hätte locker 1999USD (eher 2199USD) gekostet wenn es schon eine 3090ti als Vollausbau getan hat.

Naja, was heißt keinen Mehrwert....man bietet die wohl schnellste Gaming GPU an und erfreut sich an den Käufern. Ob die Karte schlussendlich 2,5k Kosten wird, wird man abwarten müssen. Aber die Preisspirale geht eher Richtung Norden als gen Süden....juwa schrieb:Also so lange keine neue Konsolengeneration erscheint dürfte eine 2,5k€ Karte von NV der nächsten Generation für Spiele nicht viel Mehrwert bringen, als das was die aktuelle Generation schon kann.

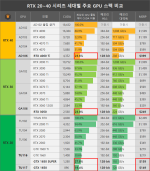

Anhänge

Zuletzt bearbeitet:

- Registriert

- Juli 2021

- Beiträge

- 2.984

Ein Kind der 90er und frühen 00er. Hab mein BSc 2011 gemacht.[wege]mini schrieb:Du bist also auch schon ein älteres Semester. Wenn dann noch GO TO ins Spiel kommt, sind wir wieder in den 80er Jahren des letzten Jahrhunderts und bei BASIC.

Ansonsten: Das gewisse Sachen bei Shadern nicht gemacht werden sollten, liegt halt daran, dass sie In-Order arbeiten und SIMD. Wenn du Pech hast, splittest du die Threads auf und hast anschließend den Salat.

Das dann Kapselungen und Co fehlen ist nur logisch.

Latenzen sind für die GPU irrelevant. Solange die Zugriffe planbar sind, kann man das kompensieren.[wege]mini schrieb:Wenn ich es bauen müsste, würde ich über Latenzen vom VRAM reden und über maximale Geschwindigkeiten im Durchsatz.

R

RogueSix

Gast

[wege]mini schrieb:Wenn ich es bauen müsste, würde ich über Latenzen vom VRAM reden und über maximale Geschwindigkeiten im Durchsatz. Dann würde ich überlegen, ab wann 512Bit zu einem Punkt kommt, wo man mit Kanonen auf Spatzen schießt.

Aktuell gehe ich von 384Bit aus.

Sehe ich ebenso, aber vielleicht hat nVidia auch den leicht teuflischen Plan gefasst, die RTX 5090 auch für Profi-Kunden relativ attraktiv zu machen.

Die RTX 4090 wurde ihnen ja scheinbar vor Inkrafttreten des China-Embargos palettenweise aus den Händen gerissen und dies sicherlich nicht von Gamern.

Wenn das wirklich der Plan ist, dann wird sich für uns Gamer mit der RTX 5090 möglicherweise die Zeit von Krypto-Wahnsinn und CoVid-Knappheit in Form von AI-Irrsinn wiederholen, was... nicht so schön wäre

ruthi91

Captain

- Registriert

- Nov. 2007

- Beiträge

- 3.919

48GB wären nur möglich mit Vram Chips einer Zwischengröße, also wenn es 3Gbyte gäbe (weiß ich grad nicht).danyundsahne schrieb:Bei 512-bit, wohl mindestens 32, vll sogar 48GB VRAM, wird der Preis einfach nicht unter 2K€ sein, wohl eher Richtung 2,5K. Das muss man sich mal überlegen...für eine GPU, bei der die meisten eh nur Zocken wollen.

Oder sie behalten das 384bit Interface bei und bestücken wieder doppelseitig wie auf der 3090.

Weiterhin steht in den Sternen ob es nochmal GDDR6X wird oder schon GDDR7.

Sollten sie wirklich 512bit und GDDR7 gleichzeitig bringen, wäre der Anstieg der Speicherbandbreite enorm und überhaupt fraglich ob notwendig.

Fürs Gaming jedenfalls nicht, nachdem die GPUs ja deutlich mehr Cache bekommen haben.

Oder das Topmodell soll diesmal prädestiniert für AI sein im privaten / semiprofessionellen Umfeld oder wo schlichtweg keine zigtausend Euro verfügbar sind für die Servermodelle.

Ich denke auch einen Mehrleistungssprung wie ihn 3090 und 4090 hingelegt haben, wird deutlich schwieriger zu erreichen sein. Mit TSMC 4N sind sie fast schon am Limit. Sie müssten noch mehr Recheneinheiten in den Chip kriegen und/oder einen noch größeren und teureren Chip in Kauf nehmen.Orok91 schrieb:Irgendwie erwarte ich nur 15-20% die eine 5090 drauf legt

Oder sie finden nochmal deutlich mehr Spielraum bei der Taktschraube und die 5000er erreichen 3,5Ghz.

- Registriert

- Feb. 2019

- Beiträge

- 6.125

johnieboy schrieb:Ich finde diese "Leaker" ja nur mittelmäßig unterhaltsam.

Die werfen mit Zahlen um sich und irgendwas davon wird schon richtig sein wenn die GPUs dann veröffentlicht werden.

Zur aktuellen Zeit kann ja auch alles noch stimmen. Je nach dem was man vor hat und was AMD macht, kann man theoretisch jetzt noch alles umsetzen und ändern. Daher machen Gerüchte auch eher Sinn, wenn es zur Produktion geht und das ist dann 2-3 Monate bevor die Karten kommen.

So sind es easy Klicks, weil WIR drauf klicken.

Karl.1960

Lieutenant

- Registriert

- Dez. 2011

- Beiträge

- 577

Irgendjemand kauft das auch für 7000€😃Unti schrieb:Wir brauchen definitiv keine 5090 für 3500 Euro

- Registriert

- Feb. 2019

- Beiträge

- 6.125

ruthi91 schrieb:Ich denke auch einen Mehrleistungssprung wie ihn 3090 und 4090 hingelegt haben, wird deutlich schwieriger zu erreichen sein. Mit TSMC 4N sind sie fast schon am Limit. Sie müssten noch mehr Recheneinheiten in den Chip kriegen und/oder einen noch größeren und teureren Chip in Kauf nehmen.

Oder sie finden nochmal deutlich mehr Spielraum bei der Taktschraube und die 5000er erreichen 3,5Ghz.

Gehe auch nicht von 70%+ aus. Nicht nur weil der Sprung bei der Fertigung kleiner ist, sondern weil AMD scheinbar auch keine Konkurrenz sein wird. Für 70%+ würde die Karte garantiert nicht mehr im gleichen Preissegment kommen.

danyundsahne

Commodore

- Registriert

- Okt. 2007

- Beiträge

- 4.512

Klar, alles Gerüchte, was schlussendlich kommt, wird man sehen müssen. Aber GDDR7 ist im Gespräch, genauso wie das 512-bit SI. Das eine bedingt nicht das andere...aber wenn beides so kommt, dann wird es a) schnell und b) sehr teuer. Nicht nur im Serverbereich, auch für uns Gamerruthi91 schrieb:48GB wären nur möglich mit Vram Chips einer Zwischengröße, also wenn es 3Gbyte gäbe (weiß ich grad nicht).

Oder sie behalten das 384bit Interface bei und bestücken wieder doppelseitig wie auf der 3090.

Weiterhin steht in den Sternen ob es nochmal GDDR6X wird oder schon GDDR7.

Sollten sie wirklich 512bit und GDDR7 gleichzeitig bringen, wäre der Anstieg der Speicherbandbreite enorm und überhaupt fraglich ob notwendig.

Fürs Gaming jedenfalls nicht, nachdem die GPUs ja deutlich mehr Cache bekommen haben.

Oder das Topmodell soll diesmal prädestiniert für AI sein im privaten / semiprofessionellen Umfeld oder wo schlichtweg keine zigtausend Euro verfügbar sind für die Servermodelle.

Cohen

Commodore

- Registriert

- Aug. 2010

- Beiträge

- 4.645

"Richtig schnell" = unter 10 GB/s.Mcr-King schrieb:Naja stimmt nicht ganz die haben auch eine SSD die richtig Schnell ist und dadurch geht dass Streaming direkt in die GPU.

Zum Vergleich:

Speicheranbindung PS5 = 16GB @ 448 GB/s (über 40x so schnell)

Speicheranbindung Xbox Series X schneller Speicher = 10 GB @ 560 GB/s (über 50x so schnell)

Speicheranbindung Xbox Series X langsamer Speicher = 6 GB @ 336 GB/s (über 30x so schnell)

Speicheranbindung Xbox Series S schneller Speicher = 8 GB @ 224 GB/s (über 20x so schnell)

Speicheranbindung Xbox Series S langsamer Speicher = 2 GB @ 56 GB/s (über 5x so schnell)

- Registriert

- Feb. 2019

- Beiträge

- 6.125

danyundsahne schrieb:Klar, alles Gerüchte, was schlussendlich kommt, wird man sehen müssen. Aber GDDR7 ist im Gespräch, genauso wie das 512-bit SI. Das eine bedingt nicht das andere...aber wenn beides so kommt, dann wird es a) schnell und b) sehr teuer. Nicht nur im Serverbereich, auch für uns Gamer

Wenn beides kommen sollte, dann wird es für Gamer nicht teuer, weil die Karte dann nicht für Gamer ist.

Raise

Cadet 3rd Year

- Registriert

- März 2023

- Beiträge

- 51

Ich bin ehrlich und würde eine Grafikkarte für 2000-3000€ kaufen, wenn es folgende Eigenschaften besitzt:

Wenn die 5090 die obenstehenden Kriterien erfüllt, dann werde ich mir eins kaufen. Dann wäre mir auch der Preis von 2000-3000€ es Wert. Wenn AMD mir das bieten könnte, dann würde ich mir eine AMD Karte kaufen. Mir ist der Hersteller egal.

- Minimum 32GB Vram

- Displayport 2.1 UHBR 20 maximale physikalische Bandbreite (80Gbit/s) nativ

- Gutes Kühlkonzept, geringe Lautstärke und Qualität

- 512 Bit Bus

- Neue hilfreiche Features

- Garantiert mir jedes Spiel in 4k auf Ultra + Raytracing nativ mit mindestens 60 FPS

- Angemessener Stromverbraucht ~400 Watt

Wenn die 5090 die obenstehenden Kriterien erfüllt, dann werde ich mir eins kaufen. Dann wäre mir auch der Preis von 2000-3000€ es Wert. Wenn AMD mir das bieten könnte, dann würde ich mir eine AMD Karte kaufen. Mir ist der Hersteller egal.

[wege]mini

Banned

- Registriert

- Juli 2018

- Beiträge

- 8.357

DevPandi schrieb:Solange die Zugriffe planbar sind, kann man das kompensieren.

Guter Punkt. Im RAM Limit, fällt einem das dann aber auf die Füße. Wie du schon sagtest, Sprungvorhersage (ich sage gerne Voodoo) gibt es da nicht und den RAM immer nur vollklatschen, weil ja so viel davon da ist, ist auch keine Lösung.

Schon zu Zeiten, als noch Commodore geil war, musste man mit Clear RAM 3rd Party Software arbeiten, da die Softwareheinis einfach nur rumgeschlampt haben. Und damals gab es noch ChipRAM und FastRAM.

Niemand braucht aber einen Teil eines Levels im RAM, an den man nie wieder zurück kehren wird. Wenn man jetzt dauerhaft im Hintergrund die Texturen vorhält, weil der Protagonist bald dort sein wird, wo er hin gehen will, braucht man Latenz.

mfg

Ähnliche Themen

- Antworten

- 242

- Aufrufe

- 15.471

- Antworten

- 395

- Aufrufe

- 29.228

- Antworten

- 47

- Aufrufe

- 5.482

- Antworten

- 800

- Aufrufe

- 48.989

- Antworten

- 183

- Aufrufe

- 22.638