Ich glaube, so wie Nvidia gerade seine Preise in Relation zur Berichterstattung gestaltet, kann man da nur gewinnen als Konkurrenz. AMD geht dieses Mal ganz bewusst in die Rolle des Underdogs und könnte damit ziemlich gut fahren. Ob sich das geschäftlich lohnt, steht auf einem anderen Blatt. AMD ist dank der Server- und CPU-Sparte aber nicht auf diesen Bereich angewiesen.Fasbir schrieb:Niemand kann ernsthaft versuchen, einen Preiskampf mit nV anzuzetteln, mit der Illusion sich letztlich nicht nur selbst zu schaden.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Bericht RDNA 4 ab 549 USD: Das sind AMD Radeon RX 9070 XT & 9070 mit RDNA 4 & FSR 4

Memphis@MG

Lt. Commander

- Registriert

- Aug. 2006

- Beiträge

- 1.179

was solls da zu rätseln geben? du hast % in den charts legst darüber einfach den ublift zu einer 79xt oder 79xtx und dann brauchste nur rechnen. ist jetzt kein hexenwerk.Abexa schrieb:Ah ja und die 5070Ti hat wie viel.....16 und die 5070 wird wie viel haben....12 bei weniger Leistung und mehr Stromverbrauch

Um ehrlich zu sein, total schlau, um im Gespräch zu bleiben. Jetzt wird hier herumgerätselt, was die tatsächliche Leistung werden wird und wir sind jetzt wie Geier auf die Tests gespannt und interessieren uns am Ende mehr für diesen als für die 5070 Tests

Ich denke jetzt einfach mal Strategie. Die Chipausbeute dürfte mittlerweile sehr gut sein und da die Kosten bei der Fertigung des Chips wahrscheinlich dieselben sind und am Anfang die kaufen, die sie unbedingt haben wollen, greifen eher zur XT Also am Ende mehr Gewinn für AMD nach 1 bis 2 Monaten wird dann allmählich die non XT immer billiger bis es so 100 Euro Unterschied sind. War schon bei der 6080(XT) so und wird hier nicht anders sein

einzige punkt wäre MAXIMAL der "preis" darum der vergleich. leistungstechnisch hat man die definitiv nicht gepickt für!

Ergänzung ()

was du nicht vergessen darfst ist das der mid range bereich eine VIEL breitere käuferschicht hat. und da nv die "aktien" abgraben ist ein sehr guter move! für die paar highend-nerds die ihre 4080super und 4090 jetzt expilizit die 5080 und 5090 ersatz suchen ist der aufwand für so einen chip die marge und die möglich verkaufzahle nicht wert!Boimler schrieb:Ich glaube, so wie Nvidia gerade seine Preise in Relation zur Berichterstattung gestaltet, kann man da nur gewinnen als Konkurrenz. AMD geht dieses Mal ganz bewusst in die Rolle des Underdogs und könnte damit ziemlich gut fahren. Ob sich das geschäftlich lohnt, steht auf einem anderen Blatt. AMD ist dank der Server- und CPU-Sparte aber nicht auf diesen Bereich angewiesen.

daher ist schon ganz recht das man da rein hält wo nv wegen "übermütigkeit" sonst was für preise für midrange karten aufruft. sollte amd´s karten hier allein NUR gegenhalten (kein massiven mehr oder weniger fps) reicht das schon mit dem entsprechenden preis in dem segment marktanteile zurück zu gewinnen.

Sollte selbst die RT leistung deutlich angenehmer an NV liegen wird dieses "argument" auch bröckeln im großen und ganze nur eine WIN WIN situation für den verbraucher!

RAZORLIGHT

Lt. Commander

- Registriert

- Dez. 2012

- Beiträge

- 1.985

Und der von dir zitierte Satz hat 2 Komponenten...gartenriese schrieb:Es gibt doch noch gar keinen Vergleich zwischen FSR4 und DLSS4.

Ergänzung ()

Nö, da es 2017 nichts anderes gab mit Nvidia Karte.Alphanerd schrieb:Das ist halt einfach nur ne sehr unschlaue persönliche Entscheidung gewesene

MiroPoch

Ensign

- Registriert

- Juni 2021

- Beiträge

- 221

5hred schrieb:Kein Wort bisher zur besseren/effektiveren Texturkompression der 9070 oder wurden da keine Fortschritte gemacht?

Im Stream wurde da was von erwähnt, ab Minute 6.

Red_Bull

Lieutenant

- Registriert

- März 2005

- Beiträge

- 637

Könntest du bitte Deutsche Worte nutzen? dankewertertzu schrieb:cringe

Ich habe jetzt nicht alles gelesen, aber was auf den ersten 10 Seiten bezüglich der Preise gejammert wird, geht ja auf keine Kuhhaut. Klar, AMD wird hat eine Karte auf fast-4080-Niveau gefälligst für 500$ zu verscherbeln, während Nvidia die Karten so verknappt, dass man das doppelte bezahlen muss für ein Leistungsplus im einstelligen Prozentbereich. Und selbst wenn AMD das gemacht hätte, hätten die Nörgler hier trotzdem noch ein Haar in der Suppe gefunden. Und dann noch beschweren, warum AMD denn kein Highend-Modell rausgebracht hat. Ja warum wohl? Weil AMD keinen Bock darauf hat, den Preissenker für Nvidia-Karten zu spielen und trotzdem auf den Entwicklungskosten sitzen zu bleiben. AMD macht das schon richtig die 5080- und 5090-Kunden zu ignorieren. Haters gonna hate.

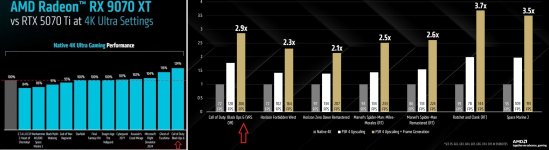

Um auch was zur Technik zu schreiben: Es scheint sich unter der Haube viel getan zu haben bei der Architektur. Das wirkt fast wie der Sprung von Vega zu RDNA1, wo man auch mit deutlich weniger CUs fast die Leistung der alten Arch einholt (damals Radeon VII vs 5700XT). Die Änderungen an der RT-Pipeline lesen sich alle sehr sinnvoll: Flachere Suchbäume, gedrehte Bounding-Boxen und out-of-order Speicherzugriffe. Ich finde es immer spannend solche Details zu lesen, während Nvidia sowas selten offen legt. Am Vergleich mit der 5070Ti sieht man aber dennoch, dass AMD in RT immer noch relativ zurückfällt. Es wird gemunkelt, dass es für die BVH-Traversierung immer noch keine dedizierten Einheiten gibt wie bei Nvidia. Aber gut, AMD muss ja nicht alles genau so lösen wie Nvidia.

Was mich allerdings enttäuscht hat, ist dass DP2.1 nur in der UHBR13.5-Ausführung unterstützt wird. Bei den ganzen 4K240-OLEDs wäre es schon ein nett gewesen, diese nativ anzusteuern. Nachdem Nvidia mit Ada bei DP der Bremser war, machen sie es diesmal richtig. Ich hoffe auch, dass AMD ihren Idle- und 2D-Verbrauch mit der neuen Display-Engine endlich in den Griff bekommen haben. Da war RDNA3 ein einziges Trauerspiel.

Um auch was zur Technik zu schreiben: Es scheint sich unter der Haube viel getan zu haben bei der Architektur. Das wirkt fast wie der Sprung von Vega zu RDNA1, wo man auch mit deutlich weniger CUs fast die Leistung der alten Arch einholt (damals Radeon VII vs 5700XT). Die Änderungen an der RT-Pipeline lesen sich alle sehr sinnvoll: Flachere Suchbäume, gedrehte Bounding-Boxen und out-of-order Speicherzugriffe. Ich finde es immer spannend solche Details zu lesen, während Nvidia sowas selten offen legt. Am Vergleich mit der 5070Ti sieht man aber dennoch, dass AMD in RT immer noch relativ zurückfällt. Es wird gemunkelt, dass es für die BVH-Traversierung immer noch keine dedizierten Einheiten gibt wie bei Nvidia. Aber gut, AMD muss ja nicht alles genau so lösen wie Nvidia.

Was mich allerdings enttäuscht hat, ist dass DP2.1 nur in der UHBR13.5-Ausführung unterstützt wird. Bei den ganzen 4K240-OLEDs wäre es schon ein nett gewesen, diese nativ anzusteuern. Nachdem Nvidia mit Ada bei DP der Bremser war, machen sie es diesmal richtig. Ich hoffe auch, dass AMD ihren Idle- und 2D-Verbrauch mit der neuen Display-Engine endlich in den Griff bekommen haben. Da war RDNA3 ein einziges Trauerspiel.

Nightmar17

Lt. Commander

- Registriert

- Feb. 2020

- Beiträge

- 1.540

Wird es auch Karten für 300€ geben? Mehr habe ich bisher für keine gpu bezahlt, die letzte war eine RX590 für 170€

Könnte den bisherigen Informationen nach ein rundes Produkt werden.

Aber AMD muss mehr investieren um wieder Marktanteile zu gewinnen. Sie brauchen ein komplettes Portfolio mit mehreren GPUs um den vollen Markt zu bedienen. Dabei können sie gerne einen x900 Konkurrenten auslassen. Der geht in extreme Regionen, wo es schwer wird. Aber sie müssten eine x800 schlagen. Sie haben das diese Generation vielleicht sogar versucht, der N48 hat ja sogar mehr Transistoren als GB203. Nur irgendwie kommt da nicht die passende Performance raus. Wenn eine 5700 mit dem kleinen GB205 Die mit einer 9070 mithalten wird, wäre das für AMD unschön. Preislich sitzt dann Nvidia am deutlich längeren Hebel.

Und bei der Software müssen sie auch zulegen. Wenn FSR4 auf Niveau von DLSS4 liegt, wäre es schon mal super. Aber da müssen die auch am Ball bleiben und vor allem muss das auch bei so gut wie allen Spielen implementiert sein.

Aber AMD muss mehr investieren um wieder Marktanteile zu gewinnen. Sie brauchen ein komplettes Portfolio mit mehreren GPUs um den vollen Markt zu bedienen. Dabei können sie gerne einen x900 Konkurrenten auslassen. Der geht in extreme Regionen, wo es schwer wird. Aber sie müssten eine x800 schlagen. Sie haben das diese Generation vielleicht sogar versucht, der N48 hat ja sogar mehr Transistoren als GB203. Nur irgendwie kommt da nicht die passende Performance raus. Wenn eine 5700 mit dem kleinen GB205 Die mit einer 9070 mithalten wird, wäre das für AMD unschön. Preislich sitzt dann Nvidia am deutlich längeren Hebel.

Und bei der Software müssen sie auch zulegen. Wenn FSR4 auf Niveau von DLSS4 liegt, wäre es schon mal super. Aber da müssen die auch am Ball bleiben und vor allem muss das auch bei so gut wie allen Spielen implementiert sein.

- Registriert

- Dez. 2023

- Beiträge

- 270

ohje

theGucky

Lt. Commander

- Registriert

- Dez. 2020

- Beiträge

- 1.599

Die 9070 fühlt sich aber leider wieder wie die 7900XT und 7900XTX zum Release an. Die 9070 ist nur da um die 9070XT zu verkaufen bei dem 50$ Abstand. Für ~20% Abstand hätte sie 499$ sein müssen.

Ich finde die 9070XT nicht so gelungen, da es im Grunde ein Rückschritt in Sachen VRAM ist.

Alle meckern, das eine 4080 zu wenig VRAM hat, alle meckern, das die 5070Ti im Grunde auch zu wenig VRAM hat. Die 9070XT ist nun auf dem selben Level und hat auch zu wenig VRAM Punkt.

Da würde ich lieber die 7900XTX mit 24GB für die aktuell 899€ empfehlen. Wer weiß...die mag vielleicht noch mal im Preis fallen...

Ich finde die 9070XT nicht so gelungen, da es im Grunde ein Rückschritt in Sachen VRAM ist.

Alle meckern, das eine 4080 zu wenig VRAM hat, alle meckern, das die 5070Ti im Grunde auch zu wenig VRAM hat. Die 9070XT ist nun auf dem selben Level und hat auch zu wenig VRAM Punkt.

Da würde ich lieber die 7900XTX mit 24GB für die aktuell 899€ empfehlen. Wer weiß...die mag vielleicht noch mal im Preis fallen...

Stuffz

Lt. Commander

- Registriert

- Dez. 2017

- Beiträge

- 1.506

Jojo, Ganz nett. Ich warte aber ab. Meine Anforderungen sind eigentlich ganz einfach. Soll nicht mehr als 500€ kosten. Soll nicht mehr als 250 Watt verbrauchen. Soll keinen schwachsinnigen Spezialstecker für die Stromzufuhr benötigen. Und dabei die halbwegs aktuellen Spiele bedienen können. Und Linux-Support (ohne closed-source-Krücken) muss her. EOD.

Wenn die non-XT den gleichen VRAM-Ausbau hat, effizienter läuft und auch noch günstiger ist, würde ich eher zur non-XT greifen.Cronos83 schrieb:Der Preis für die XT wirkt fair, der für die non-XT ist wieder absolutes Upselling.

Fair von mir aus. Aber so richtig holen mich die Preise noch nicht ab. Für ein non-XT-custom-Modell kämen für mich (inkl. Versand und inflationsbereinigt) nur 549,99€ in Frage. Und selbst da müsste ich mir schon sehr genau überlegen, ob ich endlich den Sprung von FHD zu (W)QHD mache - aber alles sehr persönlich! Andere Gamer können mit ihrem Geld natürlich machen, was sie wollen!

Wir wissen aber auch nicht um ihre Fertigungs- und Logistikkapazitäten. Langfristig wäre ein größerer Marktanteil wohl der sinnvollere Weg. Muss doch aber eh über mehrere Generationen erfolgen, oder?Cronos83 schrieb:Man kann in der Position halt nicht beides haben - deutlich steigenden Marktanteil UND gute Marge.

Her mit den unabhängigen Tests! HER DAMIT!

Du weißt wofür der Buchstabe U in UVP steht, bzw. hast generell die Bedeutung des Akronym inhaltlich verstanden ?Do Berek schrieb:An UVP glaub ich erst wenn ich sie seh.

Im übrigen sind die auch für die einfachen Modelle wie eine Sapphire Pulse mit Standardtaktraten gedacht, aber nicht für eine übertaktete Nitro+ mit deutlich aufwendigeren Kühlsystemen.

Referenzmodelle haben wir diesmal ja nicht; wobei ich den Platzhalter Renderer optisch eigentlich ganz nice finde.

BobHB

Cadet 1st Year

- Registriert

- Feb. 2025

- Beiträge

- 10

Komm, für dich gehen sie 650€ runter. Dann bekommst du es umsonst.isengard schrieb:bringt das mal auf 250/350€ runter, dann können wir weiter reden und bis dahin ist das völlig unspektakulär.

Wie viele Jahre ist dieser Satz schon alt? Alle wissen, dass gaming am Ende ist. Nur Gaming weiß es noch nicht.isengard schrieb:aber blecht doch ruhig fleißig weiter, denn die wahrheit ist, dass gaming schon längst am ende ist

Ich muss sagen, wahrscheinlich wird die 9070xt meine nächste Karte.

Tolle Karte. Und ich möchte auch damit zeigen, dass nvidia an uns vorbei entwickelt hat (vorallem vom Preis).

Lieber nehme ich jetzt eine 9070xt + einen neuen oled Monitor, als diese unglaublich überteuerten Dinge (realistisch bezahlt man 1500+ für eine gute rtx 5080)

Ich denke, wir alle sollten mal echt nachdenken.

Wenn wir weiter solche Preise akzeptieren, werden die Preise noch höher.

Nvidia hat kaum mehr Interesse an uns normalen grafikkarten Leuten. Ist ok, ist ja Business.

Aber ich kaufe lieber eine 9070xt + einen neuen oled, als diese Scheise weiter zu machen.

Und ich bin seit geforce 2 pro dabei.

Lieber kaufe ich mir jetzt eine 9070xt plus einen Monitor (oled).

Das bringt mehr

Mfg von nvidia, ist doch auch nur von Vorteil, wenn man 200fps und damit auch Hz anpeilt.

Also ich spiele mit etwa 80 fps als Limit, mit GSync. Ehrlich gesagt, mehr brauche ich nicht (ist aber etwas, was jeder für sich entscheiden muss).

Aber für mich ist Mfg der größte bullshit.

Selbst normales FG ist es schon.

Also wenn meine Karte nciht genug frames schafft, dann reduziere ich alles, bis sie 60+ hat.

Keine Ahnung wie es andere Menschen machen, aber für mich sind diese "fg" einfach nur bullshit. Selbst bei einfachen fg. Nun ich brauche etwa 50-60 schon normal.

Inwiefern mir dann 100 fps mehr bringen?

Es ist ja auch so, dass in dem Moment die "echten" frames reduziert werden.

Das heißt, wenn du 60 hast, hast du mit fg vielleicht 110. Aber du hast Auch keine 60 echte mehr darin. Denn dieser reduzieren sich auch.

Tolle Karte. Und ich möchte auch damit zeigen, dass nvidia an uns vorbei entwickelt hat (vorallem vom Preis).

Lieber nehme ich jetzt eine 9070xt + einen neuen oled Monitor, als diese unglaublich überteuerten Dinge (realistisch bezahlt man 1500+ für eine gute rtx 5080)

Ich denke, wir alle sollten mal echt nachdenken.

Wenn wir weiter solche Preise akzeptieren, werden die Preise noch höher.

Nvidia hat kaum mehr Interesse an uns normalen grafikkarten Leuten. Ist ok, ist ja Business.

Aber ich kaufe lieber eine 9070xt + einen neuen oled, als diese Scheise weiter zu machen.

Und ich bin seit geforce 2 pro dabei.

Lieber kaufe ich mir jetzt eine 9070xt plus einen Monitor (oled).

Das bringt mehr

Ergänzung ()

Mfg von nvidia, ist doch auch nur von Vorteil, wenn man 200fps und damit auch Hz anpeilt.

Also ich spiele mit etwa 80 fps als Limit, mit GSync. Ehrlich gesagt, mehr brauche ich nicht (ist aber etwas, was jeder für sich entscheiden muss).

Aber für mich ist Mfg der größte bullshit.

Selbst normales FG ist es schon.

Also wenn meine Karte nciht genug frames schafft, dann reduziere ich alles, bis sie 60+ hat.

Keine Ahnung wie es andere Menschen machen, aber für mich sind diese "fg" einfach nur bullshit. Selbst bei einfachen fg. Nun ich brauche etwa 50-60 schon normal.

Inwiefern mir dann 100 fps mehr bringen?

Es ist ja auch so, dass in dem Moment die "echten" frames reduziert werden.

Das heißt, wenn du 60 hast, hast du mit fg vielleicht 110. Aber du hast Auch keine 60 echte mehr darin. Denn dieser reduzieren sich auch.

Zuletzt bearbeitet:

Darkwater

Lieutenant

- Registriert

- Jan. 2022

- Beiträge

- 516

Ole739 schrieb:Lieber nehme ich jetzt eine 9070xt + einen neuen oled Monitor, als diese unglaublich überteuerten Dinge (realistisch bezahlt man 1500+ für eine gute rtx 5080)

Naja, die 9070XT ist ja eher das Gegenstück zur 5070Ti deren uvp. rund 880€ ist...

Ob der Aufpreis lohnt oder nicht wird sich in den Tests nächste Woche zeigen; die Ti wird vermutlich zumindest im RT/PT bei vergleichbarem OC etwas vorne liegen aber der Dreh und Angelpunkt ist halt FSR4 vs. DLSS4 (samt MFG und Reflex) wo es schwierig einzuschätzen ist wie viel diese Features an € beim Kaufpreis einer Karte wert sind.

GerryB

Commodore

- Registriert

- Sep. 2016

- Beiträge

- 4.551

Wieviele Monis können denn Das überhaupt derzeit ?C.J. schrieb:Bei den ganzen 4K240-OLEDs wäre es schon ein nett gewesen, diese nativ anzusteuern.

evtl. nur der eine GB

Vermutlich reicht UHBR13.5 in der Preisklasse/Kombi 9070xt+OLED-240Hz auch aus. (oder DSC)

Graka 699€ + Moni 779/719€ = 1478/1418€ hat schon Was für sich, <<1500€

(ältere UWQHD-Moni´s sind deutlich preiswerter als die kommenden neuen 4k-Monis mit UHBR20)

mal schauen, wieviel Fps@UWQHD man dann mit FSR4quality+FG in COD BO6 hat, und ob so ein 240Hz-Moni

ausgelastet wird (4k=206fps sollte äquivalent 240fps@UWQHD ermöglichen)

Anhänge

Zuletzt bearbeitet:

Darkwater

Lieutenant

- Registriert

- Jan. 2022

- Beiträge

- 516

Ole739 schrieb:Mfg von nvidia, ist doch auch nur von Vorteil, wenn man 200fps und damit auch Hz anpeilt.

Die Hauptschwäche von MfG ist im Moment dass es eigentlich schon um die 60FPS braucht um das Spielgefühl nicht spürbar zu beeinträchtigen und da reicht dann oft tatsächlich normales FG um auf vernünftige Frameraten zu kommen (allerdings habe ich auch keinen Monitor der mehr als 144hz darstellen kann, bin also derart hohe Bildraten auch gar nicht gewohnt).

Der interessantere teile ist imo Reflex und das tool was in zukunft den VRAM-bedarf bei spielen wo es trainiert wurde Reduzierne können soll (Name ist mir entfallen) - über die wird nicht so viel geredet, weil sie nicht 5000er Generation exklusiv sind, aber wohl NVIDIA-Exklusiv, und der imo fast wichtigere teil des Pakets...

Ähnliche Themen

- Antworten

- 763

- Aufrufe

- 60.981

- Antworten

- 666

- Aufrufe

- 49.690

- Antworten

- 213

- Aufrufe

- 17.268

- Antworten

- 307

- Aufrufe

- 18.257

- Antworten

- 237

- Aufrufe

- 23.554