Ich hatte jetzt schon relativ viele Zen3-Prozessoren in Gebrauch und hab noch nie erlebt, dass die groß gedrosselt haben, egal welche TDP-Klasse. Das klingt für mich nach einem Problem mit der Belüftung. Der 5800X3D ist eigentlich kein großer Hitzkopf, wenn man einen großen Kühler und genug Platz im Gehäuse hat. Bezogen auf die neuen Ryzen 9000 wäre ich daher vorsichtig zu sagen, die wären ein noch größeres Problem. Jede Generation hat ihre Eigenarten im thermischen Verhalten.Nighteye schrieb:Durchaus auch eine Möglichkeit. Interessant. Drosseln tut mein 5800X3D eh sowieso immer.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Test Ryzen 5 9600X & Ryzen 7 9700X im Test: Benchmarks mit RTX 4090, RX 7900 XTX und Speicher-Scaling

- Registriert

- Juni 2001

- Beiträge

- 19.763

Ja das kommt halt auf deine Spieleauswahl an. Viele hat Microsoft automatisch auf ihrer Whitelist, also solange die Gamebar läuft, kommst du halbwegs gut durch und das klappt. Aber einige Spiele sind nicht drauf, da musst du das erzwingen. Und genau das ist das eben das nervige - bei Outcast bin ich da eben reingerannt .. das ist auch nach all den Monaten da schlichtweg nicht drauf.RogueSix schrieb:Sehr gute Frage, weil das wegen Sinnlosigkeit vermutlich kaum jemand (außer TPU unabsichtlich) bisher getestet hat.

Wenn ich nach den TPU Ergebnissen gehe, dann würde ich rein aus der Erinnerung der vorherigen Ergebnisse sagen/schätzen, dass der 7950X3D jetzt um ca. 15% zulegen konnte.

Und es stimmt, es ist nervig. Mal sehen wie sie das optimieren können, ansonsten bleibt nur der Griff zum 1-CCD-Modell, der braucht den Scheiss nicht.

Nighteye

Lt. Commander

- Registriert

- Okt. 2013

- Beiträge

- 1.526

Achso das betrifft nur Multi CCD X3D,s die nur X3D auf einem CCD haben. Dann ist das ja für Klassische non X3D CPU,s mit 2 CCD,s wie den 5900X und 7900X und 7950X egal.RogueSix schrieb:Auf jeden Fall funktioniert die GameBar ja wie eine "Whitelist", die der CPU sagt, wann es sich um ein Game handelt und wann das "produktive" non-3D Cache CCD bitte "schlafen" gehen soll, während das 3D Cache CCD übernimmt.

Das heißt ich muss bei Zen 5 9900X Benchs auch nicht drauf achten. Gut zu wissen.

Solange du kein Star Citizen zockst, reichen kleine 8 Kerner ja.RogueSix schrieb:Daher kommt für mich persönlich auch nur der 9800X3D in Frage. Ich habe absolut keine Produktiv-Use-Cases für "MOAR COARS".

Bei Star Citizen sind all meine 16 Threads auf voll ausgelastet, trotz GPU Limit.

Star Citizen benötigt einen 12 Kerner stand heute, und Cloud Imperium Games hat noch nichtmal die Multi Core Optimierung eingebaut, die kommt erst in den nächsten 6 Monaten frühestens.

Wie viel Kerne dann wohl ausgelastet werden ? 16 ?

Ich bin gespannt.

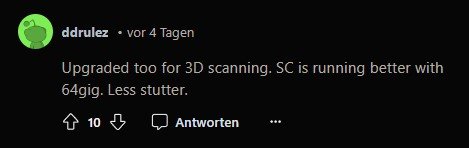

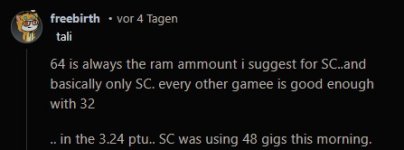

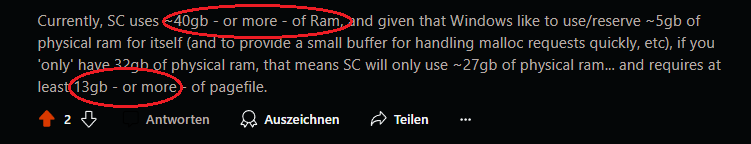

Daher habe ich auch den Arbeitsspeicher für mein 5800X3D System nicht von 32GB auf 64GB aufgerüstet, obwohl Star Citizen 64Gb benötigt damit die Pagefile nicht die ganze zeit benötigt wird.

Meine Windows SSD hat nur noch 80% Lifetime laut Crystaldiskinfo weil ich 640h Star Citizen mit 32Gb gezockt hab und die ganze Zeit Virtueller Ram in die Pagefile geladen wird. (Geschätzt alle 5 Min neue 10GB weil anders als in Starfield gibt es in Star Citizen keine Ladezeiten, dafür wird die Umgebung immer im Hintergrund in den Ram gestreamt)

Das Spiel ist ein Monster auf allen ebenen.

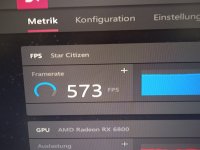

Aber hab dennoch gute FPS. Im Warp 320fps, im Blank Space 500fps. Auf Stationen 170fps. (Alles im GPU limit)

Ergänzung ()

Testet mal Star Citizen mit den neuen Zen 5 12 und 16 Kernern, da ist es dann egal, weil fast alle 16 Kerne belastet werden.Volker schrieb:Ja das kommt halt auf deine Spieleauswahl an.

Das hier war zb vor einem Jahr mit DX11 und ohne Multi Core Optimierung.

71% CPU Auslastung beim 7950X3D.

Heute wäre dies viel mehr, weil seit dem viele Patches waren, die Multicore Auslastung weiter verbessert haben.

Und eine weitere größere Multicore-Optimierung kommt erst noch mit der Vulcan API.

Wie viele Kerne dann wohl ausgelastet werden.

In 2 Jahren ist der 16 Kerner sicher so am Limit wie heute mein 8 Kerner.

Das ist ein richtiges Männer Spiel, für Männliche Systeme.

Anhänge

-

SC CPU Load 5800X3D.jpg204,6 KB · Aufrufe: 163

SC CPU Load 5800X3D.jpg204,6 KB · Aufrufe: 163 -

Star Citizen Seraphim Station CPU Load.jpg166,2 KB · Aufrufe: 170

Star Citizen Seraphim Station CPU Load.jpg166,2 KB · Aufrufe: 170 -

SC 64GB vs 32GB.jpg57,8 KB · Aufrufe: 151

SC 64GB vs 32GB.jpg57,8 KB · Aufrufe: 151 -

SC needs 64GB 2.jpg12,8 KB · Aufrufe: 145

SC needs 64GB 2.jpg12,8 KB · Aufrufe: 145 -

SC needs 64GB.jpg18,3 KB · Aufrufe: 153

SC needs 64GB.jpg18,3 KB · Aufrufe: 153 -

SC Ram usage.png18,7 KB · Aufrufe: 168

SC Ram usage.png18,7 KB · Aufrufe: 168 -

Star Citizen 71% CPU Load 7950X3D.jpg234,8 KB · Aufrufe: 168

Star Citizen 71% CPU Load 7950X3D.jpg234,8 KB · Aufrufe: 168

Zuletzt bearbeitet:

- Registriert

- Mai 2011

- Beiträge

- 22.758

Da ist es ja gut, dass ich hier auch nicht mehr als 60FPS benötige und es da gecapped habe(verstehe Leute, die lieber in Richtung 120FPS gehen, aber ich wüsste ernsthaft nicht was ich im All mit 300-500FPS anfangen sollte^^), damit hat mein 7800X3D dann auch überhaupt keine Probleme.Nighteye schrieb:Bei Star Citizen sind all meine 16 Threads auf voll ausgelastet, trotz GPU Limit.

Star Citizen benötigt einen 12 Kerner stand heute, und Cloud Imperium Games hat noch nichtmal die Multi Core Optimierung eingebaut, die kommt erst in den nächsten 6 Monaten frühestens.

Wie viel Kerne dann wohl ausgelastet werden ? 16 ?

Hab ihn aktuell sogar mit PBO auf -300MHz eingestellt, sodass er nur noch auf 4750MHz läuft, und die Auslastung der Threads liegt so bei 50-80%

Gortha

Banned

- Registriert

- Jan. 2017

- Beiträge

- 3.877

Dein RAM läuft nur mit 2400 MHz?Nighteye schrieb:WLP ist neu drauf (Arctic MX5), Prime bewirkt nach 2 Sekunden direkt 90C° und dabei bleibt es.

Also quasi 5C° kühler als bei Star Citizen, wohl weil bei Prime die Graka nicht mitheizt.

Takt ist dabei auf 4ghz gedrosselt.

Der CPU Kühler ist bis 220W TDP Spezifiziert. Ist schon heftig dass so eine sparsame CPU, so viel Hitze absondert.

So sind meine Settngs:

Deine CPU Drosselt also... Lass den VCore also die CPU Spannung auf Auto und arbeite mit dem PBO2Tuner.

Ram sollte hoch!!!

Sunjy Kamikaze

Commodore

- Registriert

- Aug. 2015

- Beiträge

- 4.572

Du beschreibst das Game als wäre es Top Optimiert für Mulitcore. Dabei ist es das eben nicht. Es lastet alles aus was es bekommen kann läuft aber auch mitlerweile so langsam auf nicht High end Rechnern vernünftig.Nighteye schrieb:Solange du kein Star Citizen zockst, reichen kleine 8 Kerner ja.

Sonst könnten 75% der spiele das game gar nicht zocken.

Niemand würde sich Heutzutage einen gefallen tun sein game auf 16 Kerner zu Optimieren. Die hat nämlich nichtmal 1% der Gamerschaft.

Star Citizen ist einfach ein Game das Abrundtief schlecht Optimiert ist nichts anderes. Die Performance schwankt ja sogar von server zu Server immens.

Ich liebe das Game aber nur weil es schlecht Optimiert ist zu sagen es ist ein Game für High End systeme ist halt nicht der Weg to Go meiner Meinung nach.

Nighteye

Lt. Commander

- Registriert

- Okt. 2013

- Beiträge

- 1.526

Beide aussagen totaler Quark tut mir leid.Sunjy Kamikaze schrieb:Star Citizen ist einfach ein Game das Abrundtief schlecht Optimiert ist nichts anderes. Die Performance schwankt ja sogar von server zu Server immens.

1. Server fps haben nichts mit deinen Client fps zu tun.

(Ich hab immer gleich viel fps, egal ob der server 30fps oder deutlich weniger hat)

2.) Das Spiel ist gut Optimiert. Es sieht Grafisch besser aus als Battlefield 2042, und ich hab in Battlefield 2042 weniger fps.

Und Star Citizen ist 10x komplexer als BF2142 was die Umgebung und Interaktion angeht. (es muss logischerweise viel mehr berechnet werden)

Star Citizen ist das erste MMO wo alles Physikalisch und Persistent ist.

Die Waffen und Module in deinem Raumschiff, stecken da wirklich drin, und wenn genau diese einen zb Laser oder Railgun Schuss abbekommen, fallen genau diese Schiffssysteme aus, und es wird auch alles Physikalisch dargestellt wie Beschädigungen, defekte Verbindungen usw. Du kannst auch alle Module aus deinem Raumschiff einzeln ausbauen. Du kannst sogar die Hülle abziehen.

Und genau dort wo die hülle nachgibt, kann sie auch brechen oder ganz abreißen, es gibt Feuer, Sauerstoffinteraktion, Schwerkraft Generatoren usw. Jede Beschädigung, jeder Kratzer, jeder Spraydosen Einsatz irgendwo, alles bleibt an den Wänden/Fahrzeugen/Raumschiffen. Sogar die Munitionshülsen, abgeschossene Metallstücke die dann im All rumfliegen, alles ist Persistent.

Wenn eine Rakete deinen Rumpf in tausend Teile zerberstet, dann liegen/fliegen diese teile alle wirklich Physikalisch und können andere mit ihrer Wucht treffen.

Battlefield ist wie Tetris dagegen. Und irgendwo muss diese Vielfalt ja berechnet werden.

Das heißt nicht das es schlecht Optimiert ist. Das heißt es ist einfach komplexer als das was du gewohnt bist.

Ich erreiche diese FPS mit einer um 600mhz Runtergetakteten RX6800 nonXT die 4 Jahre alt ist.

Meine CPU ist untertaktet, und 2133mhz Ram (4x8GB) auf 7 Jahre altem pcie 3.0 Mainboard aus Zen 1 Zeiten.

(Nichts optimiert, nur Flaschenhälse, mein ganzer Rechner hat insgesamt keine 1000€ gekostet und ist alt)

PS: Dein System gefällt mir. Geiler Rechner. (Kein Scherz)

Anhänge

Zuletzt bearbeitet:

na die neuen sind in Spielen durch das Power Limit nicht die wucht, legen sonnst aber gute 5% zu je nach Game mal mehr mal weniger, da sie aber teutlich kühler hierdurch sind kann ich mir schon gut vorstellen das die 3d den abstand vergrössen, erstens bessere IPC und (hoffentlich) mehr turbo takt.Vitche schrieb:Ob da dann eben ein großer Sprung vom 7800X3D möglich ist? Ich bezweifele es ein Stück weit.

na ganz klar für die OEMs, die brauchen weniger aufwand für Kühlung zu betreiben/günstiger und können nun mit ZEN5 und Xtream werben ansteller der non xmatmartin schrieb:Bei solchen Benchmarks fragt man sich für wen dieser Refresh bei solchen Preisen interessant sein soll.

das kann ich mir nicht vorstellen, aber das der Abstand zum 7x3d grösser wir, da er mehr von der IPC sowie eventuell mehr Takt profitieren dürfte, aber effizienz dürfte da nicht gross steigen wenn nicht gar ansteigen da sie dem dann eben mehr Power gönnen.R4yd3N schrieb:Wenn der 9800X3D in eine ähnliche Kerbe schlägt, dann wird der 7800X3D ausgetauscht.

sieht nun wirklich gut für Arrow Lake aus, allerdings werden die 3d fürs Gaming wohl die Erste Wahl bleiben führen ja jetzt schon 7/3.Taxxor schrieb:So wie es aktuell aussieht, scheint Intel beim Gaming gute Chancen zu haben. Arrow Lake müsste gar nicht viel schneller sein als Raptor Lake und es dürfte auch für die X3D Zen5 CPUs schwer werden.

wieso nicht er hat doch recht, die versprechen waren auch in meinen Augen eine riesen verarsche CP 12% vor dem 14700k und nun ganze 10% hinter dem 14600k ? da muss sicher der ein oder andere Kopf im Marketing dran glauben, war ja doller übertrieben wie es Intel je getan hat.ben12345 schrieb:Psst, solch Fakten darfst du hier im Forum nicht bringen,

ja AMD braucht einen neuen IOD meine Hoffnung nach wie vor das der eben anfang 25 mit Fire Range bringt, muss effizienter und schneller werdenConvert schrieb:Man kann also nur hoffen, dass AMD nach einem Jahr, also einem Refresh im Jahr 2025 die Anbindung zwischen IOD und CCD auf IFo (ähnlich wie bei Navie31/32) umstellt

Ich hab im Framecap auch keine Probleme mit dem Spiel und mein 6-Kerner hat auch noch Luft. Wenn du, wie du schreibst, eine voll ausgelastete CPU hast, ist es kein GPU-Limit. Dann ist entweder etwas nicht optimiert (im Spiel) oder dein System läuft im CPU-Limit. Letzteres kannst du mit einem Frame-Limit ganz einfach beheben. Da erübrigt sich jede Diskussion um optimierte CPUs.Nighteye schrieb:2.) Das Spiel ist gut Optimiert.

gecan

Cadet 4th Year

- Registriert

- Okt. 2021

- Beiträge

- 111

tolle leistungsverbrauch troz selbes prozess, vorallem die sc leistung überzeugt !

hut ab an amd und weiter so !!!

nur schade bzw dumm von amd den 9700 und 9600 direkt mit x zu bezeichnen, den die hätten ohne x erscheinen müssen, um den unwissende kunde wie hier überral im foren nicht lesen zu müssen, das die enttäuscht sind und nicht verstehen, was sache ist, den die sache ist, das amd sich anscheinend puffer für xt und freilich auch für die 3d cache versionen geplant hat usw !

ansonsten preisleistung eine absolutes fail, beide müssen um ca 100 euro fallen, sonst liegen die wie blei im regalen, weil für die meisten gamer total unattraktiv im vergleich zu 7800x 3d usw.

hut ab an amd und weiter so !!!

nur schade bzw dumm von amd den 9700 und 9600 direkt mit x zu bezeichnen, den die hätten ohne x erscheinen müssen, um den unwissende kunde wie hier überral im foren nicht lesen zu müssen, das die enttäuscht sind und nicht verstehen, was sache ist, den die sache ist, das amd sich anscheinend puffer für xt und freilich auch für die 3d cache versionen geplant hat usw !

ansonsten preisleistung eine absolutes fail, beide müssen um ca 100 euro fallen, sonst liegen die wie blei im regalen, weil für die meisten gamer total unattraktiv im vergleich zu 7800x 3d usw.

Zuletzt bearbeitet:

Sunjy Kamikaze

Commodore

- Registriert

- Aug. 2015

- Beiträge

- 4.572

https://robertsspaceindustries.com/telemetryNighteye schrieb:Beide aussagen totaler Quark tut mir leid.

Dann hättest du einen Rechner der jegliche in Star Citizen genutzen Systeme absolut vom Tisch Bläst. Keine ahnung was da bei dir schief läuft aber das klingt halt voll nach werbung für SC und nach nix anderem.

Das Game läuft zwar besser als noch vor 10 jahren. Aber ich kenne keinen in meinen 200 Mann Clan der in irgend einer STadt über 100 fps auch nur im ansatz hat.

Spielst du in 480x320 oder wo genau bekommst du solche fps werte ran? Die sind ja nicht nur leicht drüber sondern jenseits von allem was man aus SC kennt.

Meine CPU läuft in SC bei 20 Watt und dümpelt vor sich hin weil meine GPU schwitzt wie eine Sau die man durchs dorf treibt. (in 4K auch nicht anders zu erwarten) Aber selbst im Deep Space hab ich maximal 90-120 fps. Sobald wir im Clan mal was größeres anstellen ruckelt es auch direkt unter 40 bei einigen Schiffen.

Ich würde gern mal ein Video dazu sehen. Evtl hast du ja genau das system das man für SC braucht damit es endlich mal läuft wie man es sich wünscht.

Nighteye

Lt. Commander

- Registriert

- Okt. 2013

- Beiträge

- 1.526

NeinSunjy Kamikaze schrieb:Spielst du in 480x320 oder wo genau bekommst du solche fps werte ran?

Hab ich dir per PN geschicktSunjy Kamikaze schrieb:Ich würde gern mal ein Video dazu sehen.

Und Hammer Rechner hast du, finde ich Mega gut. Deine Graka und deinen Ram hätte ich auch gern =)

Ne, Fire Range ist einfach nur eine Notebook-Auskoplung der aktuell vorgestellten Desktop-Chips. Es muss schon eine Desktorefreshgeneartion kommen.Icke-ffm schrieb:ja AMD braucht einen neuen IOD meine Hoffnung nach wie vor das der eben anfang 25 mit Fire Range bringt, muss effizienter und schneller werden

2025 ist für ein neues IOD eigentlich zu knapp und eher wahrscheinlich, wenn AMD von Samsung irgend einen günstigen Prozess für das IOD bekommt und daran bereits arbeitet. Wenn es bei TSMC bleibt, dann macht ein neuer IOD erst im N4C-Prozess Sinn. Der N4C-Prozess ist bei TSMC im Jahr 2025 verfügbar, also könnte AMD im Jahr 2026 das neue IOD liefern. Das aktuelle IOD in 6nm kam auch ein Jahr später raus, als die 6nm Verfügbarkeit bei TSMC, oder AMD schaft die Implimentierung in N4C schneller, als damals beim 6nm-IOD. Alternativ wäre es auch möglich das IOD in N4P aufzulegen und ein Jahr später auf N4C zu portieren, weil die Portierung so einfach ist, wie damals von 7nm auf 6nm. Aber eigentlich ist N4P noch zu teuer für das IOD, deswegen denke ich, dass AMD auf N4C warten wird, wenn Samsung kein besseres Angebot liefert.

https://pics.computerbase.de/1/1/2/4/2/5-c45728fac2037c02/4-1080.20d93c44.png

https://pics.computerbase.de/1/1/2/4/2/5-c45728fac2037c02/8-1080.df465af6.png

Zusätzlich zur Flächenreduktion durch den 4nm Prozess könnte das Die Area-Scalling von 8,5 Prozent gegenüber dem "normalen N4P" gut helfen, um die NPU noch zusätzlich zur GPU im IOD unterbringen zu können ohne das der IOD-Chip zu groß wird...

Zuletzt bearbeitet:

es braucht nicht zwingend eine flächen reduktion, ein neuer IOD ohne IGPU, besserer Speicheranbindung, weniger Ide verbauch NPU und nativem USB4 geht auch in 6nm sicher noch zu bewerkstelligen, das sind alles Punkte die AMD im NB braucht, und selbst auf AM5 könnte man diese dann als 9700xt bringen als Gamer CPU eben die brauchen auch keine IGPU und FL1 sowie FP11 sind eh nur für Gaming oder eben AIW dann mit externer GPU. selbst Luna Lake hat die IO noch in 6nm sollte also auch da effizent umzusetzen sein

Ich dachte die IGPU wird im Notebook gebraucht um beim Desktopbetrieb (also keine 3D-Anwendung) die externe GPU komplett ausschalten zu können. Oder wird die externe GPU nur dann abgeschaltet, wenn das Notebook eine Intel+Nvidia-Kombination hat?Icke-ffm schrieb:ein neuer IOD ohne IGPU, [...], das sind alles Punkte die AMD im NB braucht, ...

ja mag sein, bin kein Techniker oder insider, nur schau Dir Phoenix2 an der hat 2ganze sowie 4c cores und 4CU und 137mm2 in 4nm, genausogut denkbar das AMD einen IOD auflegt der eben garkeiner ist. an abgespeckter phoenix2 nachfolger , 4x 5c cores nur 8MB L3, dafür aber 256Bit SI. sollten klar in 4nm auch nicht auf mehr Fläche kommen wie der Aktuelle IOD, eher weniger, somit könnte AMD das IOD auch einzeln im Low end verkaufen ohne externe Chiplets, bez im NB eben dann im Ide die externen CCD abschalten und so effizienter sein

- Registriert

- Mai 2011

- Beiträge

- 22.758

Und dann nur 120W mit ner 6800 bei 170FPS?Nighteye schrieb:Nein1440p High Details.

Da liegt meine 4090 schon in der Start-Kabine deutlich drüber, um 60FPS zu erreichen

Nighteye

Lt. Commander

- Registriert

- Okt. 2013

- Beiträge

- 1.526

@Taxxor Nvidia ist nicht so gut zum Videospielen. Die haben kein Frame Gen über den Treiber (API Level) und benötigen erst Optimierung seitens entwickler bevor Frame Gen mit Nvidia funktioniert.

Hab 200+fps in Area 18 (aber nie mehr als 250fps da) 1440p High Details

500+ fps inspace.

Aber dafür hat meine Graka auch 329€ Neu gekostet und ist von der Architektur her dieses Jahr erst 4 Jahre alt.

Also dafür darf man so viel fps auch erwarten.

Hab 200+fps in Area 18 (aber nie mehr als 250fps da) 1440p High Details

500+ fps inspace.

Aber dafür hat meine Graka auch 329€ Neu gekostet und ist von der Architektur her dieses Jahr erst 4 Jahre alt.

Also dafür darf man so viel fps auch erwarten.

Anhänge

Zuletzt bearbeitet:

Ähnliche Themen

- Antworten

- 1.072

- Aufrufe

- 84.029

- Antworten

- 295

- Aufrufe

- 36.412

- Antworten

- 42

- Aufrufe

- 6.762

- Antworten

- 97

- Aufrufe

- 8.905