longusnickus schrieb:

ein "casual gamer" kauft sich keine GPU für 650€ (sein wir realistisch. das ding wird die ersten monate weit über 700€ kosten. sogar 800 halte ich für realistisch)

der holt sich max, eine arc b580 für 300€.... auch mit 12GB VRAM, oder gleich ein steam deck

GeForce RTX 4070 Super hat man bis November für knapp unter 600€ bekommen, und das war dann schon ein Preis den ich für Causal Gamer noch in Ordnung finde.

Wenn man dann auf den teuren Sockel AM5 oder 1851 als Basis verzichtet, sondern auf den preiswerteren Sockel AM4 oder 1700 setzt, zum Beispiel mit Ryzen 7 5700 X3D, Ryzen 7 5800XT, Core i5-13600KF oder Core i5-14600KF, dann hält sich auch der Gesamtpreis in Grenzen, und man hat ein schönes Upper Mid-Range System für Causal Gamer.

Aber wenn man sich eine richtige Grafikkarte kauft, dann führt kein Weg an Nvidia vorbei.

Natürlich muss es nicht unbedingt eine GeForce RTX4070 Super sein. Es gibt ja darunter auch noch die GeForce RTX 4060 Ti in der 8GB oder 16GB Variante und die normale GeForce RTX 4060. Und auch die GeForce 30 Serie ist noch immer aktuell genug. Da gibt es die GeForce RTX 3050 in 6GB oder 8GB Varianten, die GeForce RTX 3060 in 8GB oder 12GB Varianten und die GeForce RTX 3070 Ti.

Die Intel Arc B580 12GB ist für 350€ völlig unintressant, da ist eine Nvidia GeForce RTX 3060 12GB für 320€ sogar etwas günstiger, hat ebenfalls 12GB VRAM, ist sogar ein bisschen kompakter und stromsparender.

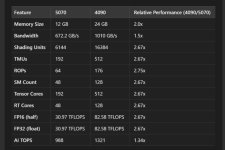

Arc B580 12GB vs. RTX 3060 12GB:

https://technical.city/de/video/GeForce-RTX-3060-vs-Arc-B580

Aber nochmal zurück zur GeForce RTX 4070 Super die es bis November für knapp 600€ gab. Das sieht es dann schon so aus:

Arc B580 12GB vs. RTX 4070 Super 12GB:

https://technical.city/de/video/GeForce-RTX-4070-SUPER-vs-Arc-B580

Da kann man schon sagen das Nvidia bei Grafikarten fast konkurrenzlos ist, und AMD und noch mehr Intel völlig hinterherhinken.