Das ist Quatsch. Jeder, der in der Lage ist, die Regler im Grafikmenü zu bedienen kann das sogar in 1440p oder 4K mit 10 GB spielen, ohne groß an Qualität zu verlieren. Alle anderen, für die das Game nur auf Anschlag läuft, müssen halt draufzahlen.pinacolada schrieb:Die 12GB Karten von nvidia sind ein Witz und reichen nixht mal mehr auf full hd. Bei indiana jones ist das game tot und die 12gb werden gesprengt

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

News Radeon RX 9070 XT: Spiele-Benchmarks und neuer Hinweis auf 3 GHz

- Ersteller MichaG

- Erstellt am

- Zur News: Radeon RX 9070 XT: Spiele-Benchmarks und neuer Hinweis auf 3 GHz

Bei all den Preisparität etc Spekulanten. Selbst wenn AMD im Preis niedriger ansetzen wird, wäre es wirtschaftlich gesehen wohl die schlechtere Entscheidung. NVIDIA würde durch ihre Kapitalreserven etc einfach nachziehen und die Karte wieder kanabilisieren. Wir müssten also Verkaufszahlen haben um eine wirtschaftliche Prognose aufzustellen bei der AMD nach Möglichkeit verlässlichen Gewinn macht. Vielleicht kommt es amd billiger wirklich zum gleichen Preis wie die 5070 anzubieten und Kenner schätzen FSR 4.0 und 16GB mehr.

coxon

Banned

- Registriert

- Mai 2005

- Beiträge

- 8.839

Erwartest du in Zeiten von Ressourcenknappheit, Rezession und Inflation etwa, dass Luxusartikel an Wert verlieren und die Preise in den Keller gehen? Die Entwicklung der letzten fünf Jahre hat da leider etwas ganz gegensätzliches gezeigt, und von einer Umkehrung dieses Marktverhaltens ist leider nicht auszugehen.Tornavida schrieb:Ne wäre es nicht. Die Karte hat mir ein Freund vor fast einem Jahr ganz normal im Laden geholt!

Raider_MXD

Cadet 4th Year

- Registriert

- März 2021

- Beiträge

- 85

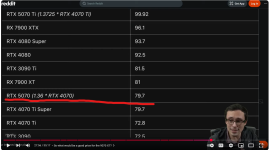

Caramelito schrieb:Wenn sie so kommt, also quasi 4070ti Super, wird sie halt auch gute 700eur kosten.

Keine Ahnung, ob das dann ein Erfolg wird..

Die 5070 wird wohl auch etwa auf dem Niveau der 4070ti Super liegen und soll mit einer UVP von $549 kommen. Davon muss AMD einen ordentlichen Abstand halten, wenn sich die 9070XT verkaufen soll.

YouTube

An dieser Stelle steht ein externer Inhalt von YouTube, der den Forumbeitrag ergänzt. Er kann mit einem Klick geladen und auch wieder ausgeblendet werden.

Ich bin damit einverstanden, dass YouTube-Embeds geladen werden. Dabei können personenbezogene Daten an YouTube übermittelt werden. Mehr dazu in der Datenschutzerklärung.

Anhänge

"Gängig" würde ich nicht sagen. Keine der Quellen, die ich beziehe, verwendet diese Bezeichnung.coxon schrieb:Ist eigentlich schon seit Jahren gängig. 4k60, 1440p60 oder 2k60, oder halt FHD/1080p60. Die 60 steht dabei für die fps. ^^

coxon

Banned

- Registriert

- Mai 2005

- Beiträge

- 8.839

Sehe ich ganz anders. Nvidia hat das die letzten Jahre nicht getan, und das werden sie in Zukunft auch nicht.Ferax schrieb:NVIDIA würde durch ihre Kapitalreserven etc einfach nachziehen und die Karte wieder kanabilisieren.

Nur bezog ich mich dabei nicht auf die RTX 4080 Super, sondern wie folgt auf das kleinere Modell (entschuldige, da war ich dir nicht deutlich genug?)coxon schrieb:nur beschwert sich da kaum einer ... hach ...

Punkt.TheManneken schrieb:dass man bei 4070TiS+ Leistung ankommen wird, "darf" das Ding eigentlich nicht mehr als 300 W ziehen

Gruß Fred.

coxon

Banned

- Registriert

- Mai 2005

- Beiträge

- 8.839

Genau. Da hat die deutsche Gründlichkeit gefehlt!FR3DI schrieb:entschuldige, da war ich dir nicht deutlich genug?

- Registriert

- Mai 2011

- Beiträge

- 21.221

sweber schrieb:Kann nochmal jemand erklären, was "2K" Auflösung sein soll, wenn nicht Full HD?

Wenn 3.840 x 2.160 als "4K" bezeichnet wird (weil 3.840 fast 4.000 ist), dann müsste "2K" nach dergleichen Logik 1.920 x 1.080 sein.

Cerebral_Amoebe schrieb:WQHD

halb so breit, halb so hoch wie 4K (ungefähr)

Halb so breit und halb so hoch wie 4K, und zwar nicht nur ungefähr, wären 1920x1080.

2K ist 2048x1080 und alle Auflösungen, die sich in diesem Bereich bewegen, so auch 1920x1080

https://en.wikipedia.org/wiki/2K_resolution

Genau so ist 4K 4096x2160 und alle Auflösungen, die sich in diesem Bereich bewegen, so auch 3840x2160

https://en.wikipedia.org/wiki/4K_resolution

2K und 4K beschreiben nur die horizontale Pixelanzahl.

WQHD wäre 2,5K

Hier auch ein schöner Post dazu

https://linustechtips.com/topic/691408-2k-does-not-mean-2560×1440/

Zuletzt bearbeitet:

Limonadenmann schrieb:Ich hab mir als Budget 600€ gesetzt für die 9070XT, falls die da rüber geht wirds für mich wieder eine grüne.

Für eine neue wird es aber schwierig, wenn das günstigste Modell erst bei 649€ startet bei Nvidia.

CDLABSRadonP...

Commodore

- Registriert

- Feb. 2021

- Beiträge

- 4.382

Ja, 2K ist 2048x1080, 1920x1080 und alles dergleichen. 2,5K ist 2560x1440, 2560x1600 usw., genau wie 4K sowohl 4096x2160, 3840x2160, 3840x1800 ist. Wird einfach schlicht und ergreifend falsch, entgegengesetzt der eigentlichen Logik, verwendet.sweber schrieb:Kann nochmal jemand erklären, was "2K" Auflösung sein soll, wenn nicht Full HD?

Wenn 3.840 x 2.160 als "4K" bezeichnet wird (weil 3.840 fast 4.000 ist), dann müsste "2K" nach dergleichen Logik 1.920 x 1.080 sein.

So oder so, ich finde diese Bezeichnung überflüssig und unverständlich.

Raider_MXD

Cadet 4th Year

- Registriert

- März 2021

- Beiträge

- 85

Knobi Wahn schrieb:Gehen wir mal von 5070 = 4070Ti Super aus und der Preis von 549$ bzw. 650 € aus, wäre das schon etwas teuer.

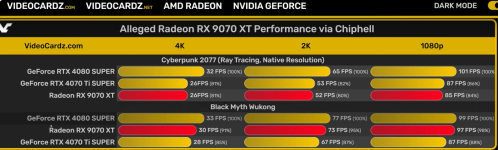

Annahme: Die 9070XT liegt auf 4070Ti Super Leistungsniveau.

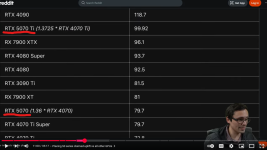

Sowohl die 5070 als auch die 9070XT werden derzeit in der Tat etwa auf dem Niveau der 4070Ti Super verortet. Man wird sehen, ob sich das so bestätigt.

Anhänge

ruthi91

Captain

- Registriert

- Nov. 2007

- Beiträge

- 3.858

Also leistungsmäßig da wo man bereits seit 2 Jahren eine 7900XT stehen hat die mit 20GB aufwarten kann.Obvision schrieb:Inoffizielle Zahlen spachen von 479 - 549 $, was dann so 570 - 650 € sind.

Das wäre ein fairer Preis, der immernoch P/L weit vorne liegen würde

Ebenfalls steht da noch eine 7900GRE die man schon mal vorsorglich aus dem Programm nimmt und darunter lauert die 7800XT die noch lange kein altes Eisen ist bzw. der 9070 nonXT gefährlich wird.

Ebenso der Vor-Vorgänger 6800XT / 6900XT / 6950XT muss sich abseits von FSR4 nicht fürchten.

Auf der grünen Seite muss man sich der 4070 Super und der kommenden 5070 stellen, welche beide mit ~100W weniger TDP aufwarten können. Siehe Gerücht 330W, also auch genau da wo bereits jetzt schon eine 7900XT steht.

Da fragt man sich wozu die ganze Entwicklungsarbeit in einen monolithischen 4nm Chip gesteckt wurde.

Ganz grundsätzlich hat Radeon auch das Problem, dass Nvidia nicht nur das eine Halo Produkt stellt, sondern absehbar 4-5 Modelle (~4080, 4090, 5070Ti, 5080, 5090) hat die über dem AMD Lineup rangieren.

Selbst wenn AMD in den Preiskampf gehen würde, wäre Nvidia ganz bequem dazu in der Lage preislich nachzuziehen, schließlich wirft das Server-GPU Geschäft ja genug ab.

Dazu kommt noch, dass man zurückgehaltene Features wie DLSS 3/4 auch nachträglich der Vorgänger-Generation verfügbar machen könnte.

Auch andere Incentives wie Spiele Bundles wären möglich und auch da sehe ich die Wahrscheinlichkeit bei Nvidia viel höher an, sich begehrte AAA Blockbuster zu ködern.

Das Kräfteverhältnis ist mittlerweile so dermaßen zu Ungunsten AMDs verschoben, dass ich sie nicht mehr aus eigener Kraft aus ihrem Loch rauskommen sehe, außer Nvidia verpatzt auch 2-3 Generationen so wie Intel.

Raider_MXD

Cadet 4th Year

- Registriert

- März 2021

- Beiträge

- 85

Dann werden die wie Blei in den Regalen liegen falls sich die jüngsten Performanceleaks bestätigen.Benji21 schrieb:Ich tippe mal die XT landet preislich zwischen 5070/Ti, die non XT knapp unterhalb der 5070.

Anhänge

BOBderBAGGER

Fleet Admiral

- Registriert

- Feb. 2008

- Beiträge

- 15.454

Klingt logisch ich gebe 600+ euro für ne GPU aus die eigentlich schnell genug ist aber manges Speicher muss ich dann am Regler drehen.schkai schrieb:Das ist Quatsch. Jeder, der in der Lage ist, die Regler im Grafikmenü zu bedienen kann das sogar in 1440p oder 4K mit 10 GB spielen

Schon längst korrigiert aber was kann ich für wenn Nvidia dieses idiotische Super Namen benutzt die man ständig mit sagen muss obwohl es nur idiotisches Marketing ist besonders bei der 4080 die ja eh fast ne 1:1 kopie ist nur billiger.coxon schrieb:Wann haben die Grünen die Karte denn gebracht? ^^

TempeltonPeck

Lt. Commander

- Registriert

- Juni 2007

- Beiträge

- 1.135

DaysShadow schrieb:Ebenfalls für @Zenx_ @TempeltonPeck @mike2105

Mein Kommentar bezieht sich auf die Konkurrenz zwischen AMD und Nvidia bzgl. Leistungskrone, da gabs mal ein hin und her, aber AMD läuft da nur noch hinterher. Ich vermisse da irgendwie etwas den Willen für „ganz oben“.

Andererseits eben, bis auf die teuerste Karte der Konkurrenz können sie ja mitspielen und liefern jede Generation seit der 6000er Reihe äquivalente Leistung, nur eben „intern“ immer eine Stufe drüber, 6900 entsprach ca. 3080 etc. pp.

Ich hab selbst ne AMD Karte, und hatte vor meinem temporären Laptopausflug auch eine 6900 XT, weil ich für die Mehrleistung den Mehrpreis der 4090 nicht eingesehen hab. Meine 7900 XTX hat 891 CHF gekostet, insofern Big Bang for the buck, angesichts heutiger Preise.

Weiß daher auch nicht was der aggressive Ton teilweise soll.

Und noch explizit @TempeltonPeck Toxisch? 😂 geh mal an die frische Luft.

Keine Ahnung was für dich daran Aggessiv ist oder was du lustig findest aber Foren und Solziale Medien haben nun mal den Hang zur Toxizität. Ja und auch dein Beitrag. Nach den Likes meines Beitrags scheinen das auch viele andere so zu sehen.

Der Punkt ist das immer nach High End geschrien wird und alles andere ignoriert wird. Muss es den immer High End sein? Das Narrativ das auf Tec und Games Seiten gepflegt wird das alles unter 4K in 144HZ bei allen Regler auf max unspielbar ist wirkt.

Auch Sätze wie "der Wille nach ganz oben" ist einfach Quatsch. Wer sagten das AMD das nicht will. Natürlich wollen die das. Schon allein aus Maketing Gründen. Nur wenn sich AMD eingesteht lieber jetzt diesen Schritt aus zu lassen dann haben die Gründe. Bestes Beispiel sind die ersten Ryzen. AMD wusste das die erst einmal nicht Intel das Wasser riechen können aber ein guter wieder Einstieg sind und mit jeder Generation wurde der Abstand zu Intel kleiner.

Außerdem. Eine Leistungsstarke und günstige Mittelklasse GPU kann viel mehr Käufer ansprechen. Daraus ein Abgesang auf ADM GPU zu orakeln ist halt nichts anderes wie das ständige schlecht reden von Radeons hier auch wenn du selbst eine besitzt.

Ähnliche Themen

- Antworten

- 345

- Aufrufe

- 30.665

- Antworten

- 169

- Aufrufe

- 14.715

- Antworten

- 240

- Aufrufe

- 16.515

- Antworten

- 654

- Aufrufe

- 47.310

- Antworten

- 307

- Aufrufe

- 17.003