coxon

Fleet Admiral

- Registriert

- Mai 2005

- Beiträge

- 12.428

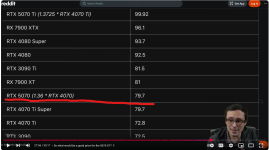

Ich sags immer wieder gern: baue erst mal deine eigene GPU bevor du so nen Käse verfasst. 🥳DaysShadow schrieb:Super, AMD hat mit ihrer neuen Reihe damit also die über 2 Jahre alte Konkurrenz eingeholt.